就在前几天,我们刚刚分享了相关内容,没想到这么快又有了新动态。这次,我们第一时间拿到了清华大学沈阳团队关于 DeepSeek 的最新攻略,迫不及待地想要和大家分享。

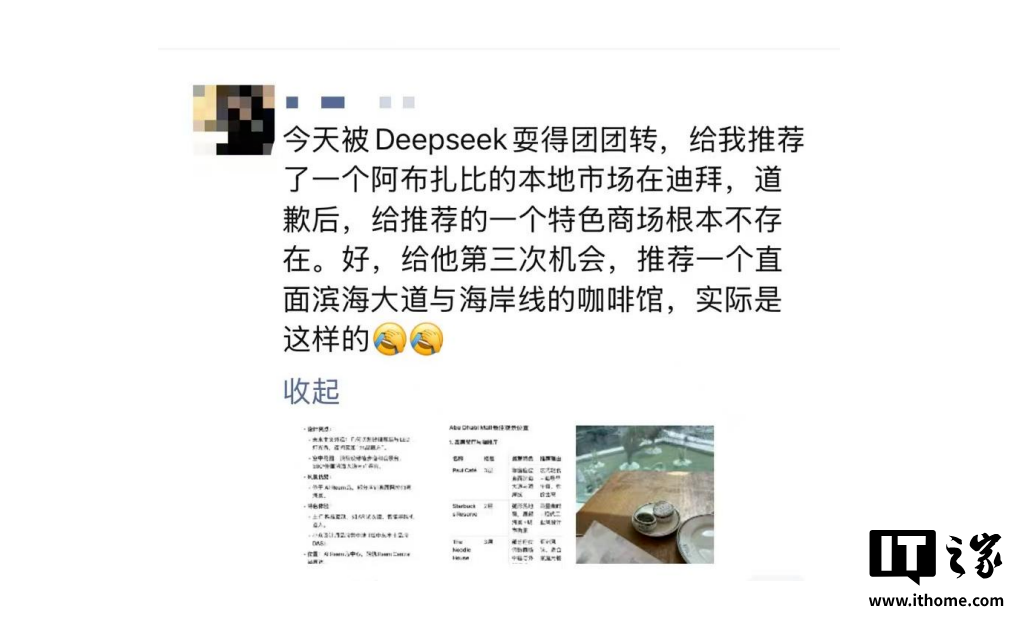

不知道大家在使用 DeepSeek 等大语言模型时,有没有遇到过“一本正经地胡说八道”的情况?

这次的第五部新宝典,聚焦的就是 AI 幻觉这一问题。

对于普通用户来说,如何应对 AI 幻觉,甚至巧妙利用 AI 幻觉,看完这篇攻略后,相信你就能找到答案。

对了,这次给大家分享的 PDF 下载,是未经修改的原版哦,网上有很多版本被卖课者魔改,植入了广告。

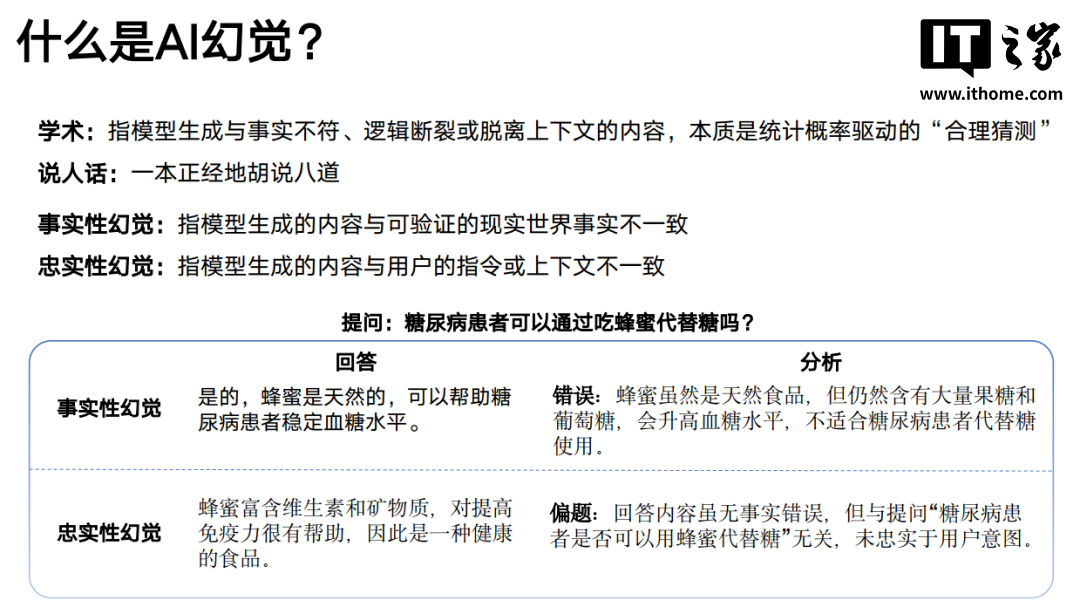

一、什么是 AI 幻觉

所谓 AI 幻觉,其实就是模型生成的内容与事实不符、逻辑断裂或脱离上下文,本质上是基于统计概率的“合理猜测”。

换句话说,那些看似有理却与事实相悖的情况,就是 AI 幻觉。

它主要分为两种:

-

事实性幻觉:模型生成的内容与可验证的现实世界事实不一致。

-

忠实性幻觉:模型生成的内容与用户的指令或上下文不一致。

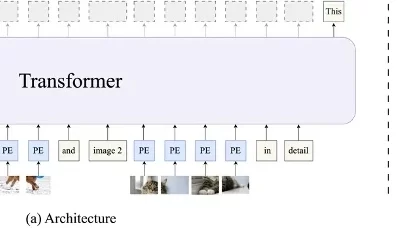

二、为什么会产生幻觉

AI 产生幻觉的原因主要有以下几种:

-

数据偏差:训练数据中的错误或片面性被模型放大,例如在医学领域,过时的论文可能导致错误结论。

-

泛化困境:模型难以处理训练集外的复杂场景,比如预测南极冰层融化对非洲农业的影响。

知识固化:模型过度依赖参数化记忆,缺乏动态更新能力,例如对 2023 年后的事件可能会完全虚构。

-

意图误解:用户提问模糊时,模型容易“自由发挥”,比如“介绍深度学习”可能会偏离实际需求。

我们可以通过虚构事件来测试各大 LLM 的事实性幻觉情况。

三、如何减缓 AI 幻觉

作为普通用户,我们该如何减缓 AI 幻觉的影响呢?

首先,开启联网搜索功能,让 AI 能够对齐信息的颗粒度,这样“胡说八道”的几率自然会减少。

其次,在编写提示词时,提前做好知识边界的限定,降低 LLM 虚构的可能性。

此外,我们还可以使用多款 AI 模型,对生成的结果进行交叉验证,让 DeepSeek 和千问等模型相互“竞争”。

目前,AI 幻觉仍然是无法完全杜绝的问题。我们在使用大语言模型辅助工作时,不能将其视为“万能神药”,而是要保持自己的判断力。

四、AI 幻觉的创造力价值

当我们需要确定性的结果时,AI 幻觉显然是不受欢迎的。

然而,在需要“创造力”的领域,幻觉可能反而是一种有价值的资源。

当然,我们还需要逐步建立方法论,经过合理的验证过程,才能让 AI 幻觉的“想象力”为我们所用。

看完这篇文章,你是不是对“AI 幻觉”这个近期热门的词汇有了一些基础的了解呢?

微信公众号回复:AI

即可获取清华大学原版秘籍,点此或扫描 / 长按下方二维码皆可进入公众号,关注后发消息即可。