在人工智能领域,阿里巴巴旗下的Qwen团队再次取得重大突破,推出了全新的开源大型语言模型——QwQ-32B。这款模型以其320亿参数的强大配置和卓越的推理能力,为AI的发展注入了新的活力。

QwQ-32B的发布,不仅是技术上的进步,更是对开源理念的践行。该模型在Hugging Face和ModelScope上以Apache2.0许可证开源,为全球的开发者和研究人员提供了极大的便利。无论是商业机构还是个人用户,都可以免费使用这一模型,并将其应用于各种场景,包括收费服务。这种开放的姿态,无疑将进一步推动AI技术的普及和创新。

QwQ系列自2024年11月首次推出以来,一直致力于通过强化推理过程来提升模型的逻辑推理和规划能力。QwQ-32B的发布,标志着该系列在推理能力上的又一次飞跃。早期的QwQ模型已经在数学和编码任务中展现出了出色的表现,但在编程基准测试中仍存在一些不足。QwQ-32B的出现,正是为了解决这些问题,并进一步提升模型的整体性能。

在性能提升方面,QwQ-32B通过整合强化学习和结构化自我提问,实现了显著的进步。强化学习作为一种强大的训练方法,能够显著提高模型解决复杂问题的能力。QwQ-32B采用了多阶段强化学习训练方法,分别针对数学推理、编码能力和通用问题解决能力进行优化。这种训练方式不仅提升了模型在特定任务上的表现,还增强了其在多种任务中的综合能力。

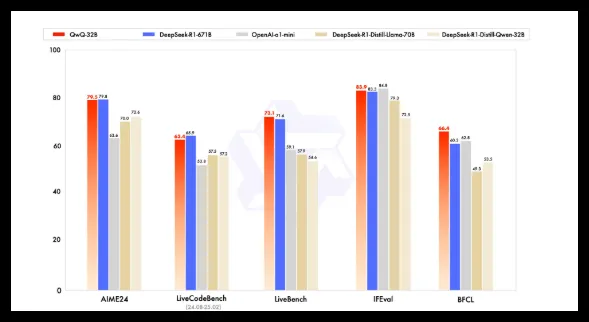

在基准测试中,QwQ-32B与DeepSeek-R1、o1-mini等领先模型进行了对比。尽管其参数量小于部分竞品,但QwQ-32B依然取得了极具竞争力的结果。例如,DeepSeek-R1拥有6710亿参数,而QwQ-32B在性能相当的情况下,显存需求更小,通常在GPU上仅需24GB vRAM,相比之下,运行完整的DeepSeek R1则需要超过1500GB vRAM。这使得QwQ-32B成为低成本高性能的理想选择,为资源有限的开发者和企业提供了极大的便利。

从技术细节来看,QwQ-32B采用了因果语言模型架构,并进行了多项优化,包括64个Transformer层、RoPE、SwiGLU、RMSNorm和Attention QKV bias。它还采用了广义查询注意力(GQA),拥有131,072tokens的扩展上下文长度,并经历了包括预训练、监督微调和强化学习在内的多阶段训练。这种架构和训练方式的结合,使得QwQ-32B在处理复杂任务时表现出色。

QwQ-32B的强化学习过程分为两个阶段。第一阶段专注于数学和编码能力,通过准确性验证器和代码执行服务器进行训练,确保模型在这些关键领域的表现。第二阶段则通过通用奖励模型和基于规则的验证器进行奖励训练,以提高指令跟随、人类对齐和代理推理能力,同时不影响其在数学和编码方面的优势。这种分阶段的训练方法,使得QwQ-32B能够在多个领域实现平衡发展。

此外,QwQ-32B还具备agentic capabilities,能够根据环境反馈动态调整推理过程。这种能力使得模型在面对复杂多变的环境时,能够更加灵活地做出决策。Qwen团队还建议使用特定的推理设置以获得最佳性能,并支持使用vLLM进行部署,方便开发者快速上手。

展望未来,Qwen团队将QwQ-32B视为通过扩展强化学习增强推理能力的起点。他们计划进一步探索扩展强化学习、整合代理与强化学习以实现长期推理,并持续开发为强化学习优化的基础模型,最终迈向通用人工智能(AGI)。这一目标的实现,将为AI领域带来更深远的影响。

模型地址:https://qwenlm.github.io/blog/qwq-32b/