在当今数字化时代,多模态检索技术正逐渐成为人工智能领域的重要发展方向,而北京智源人工智能研究院在这一领域取得了令人瞩目的成就。2025年3月6日,智源研究院宣布开源BGE-VL多模态向量模型,这一成果无疑为多模态检索领域带来了新的活力与突破。

BGE-VL模型在图文检索、组合图像检索等多模态检索任务中展现出了卓越的性能,其效果在众多同类模型中脱颖而出,显著提升了多模态检索的整体性能。这一成就的背后,是基于一个大规模合成数据集MegaPairs的开发。MegaPairs数据集通过巧妙地结合多模态表征模型、多模态大模型以及大语言模型,从海量的图文语料库中高效地挖掘出多模态三元组数据。这种创新的方法不仅具备出色的可扩展性,能够以极低的成本持续生成多样化且高质量的数据,还大幅提升了数据质量。与传统依赖人工标注数据的方式相比,MegaPairs仅需1/70的数据量,便能实现更优的训练效果,这无疑为多模态检索技术的发展提供了一种全新的思路。

在技术实现方面,MegaPairs的构建过程分为两个关键步骤。首先,通过多种相似度模型从图像数据集中挖掘出多样化的图像对。其次,利用开源的多模态大模型和大语言模型合成开放域检索指令。这一过程完全无需人工参与,即可实现大规模、高质量且多样化的多模态检索指令数据集的生成。此次发布的版本包含了2600万条样本,为多模态检索模型的训练提供了极为丰富的数据支持。

基于MegaPairs数据集,智源BGE团队精心训练了3款不同尺寸的多模态检索模型,分别是BGE-VL-Base、BGE-VL-Large和BGE-VL-MLLM。这些模型在多个任务上的表现远超以往的方法,展现了强大的性能优势。在Massive Multimodal Embedding Benchmark(MMEB)的36个多模态嵌入评测任务中,BGE-VL不仅在零样本性能上实现了最优表现,而且在有监督微调后的性能上也一骑绝尘,充分证明了其良好的任务泛化能力。

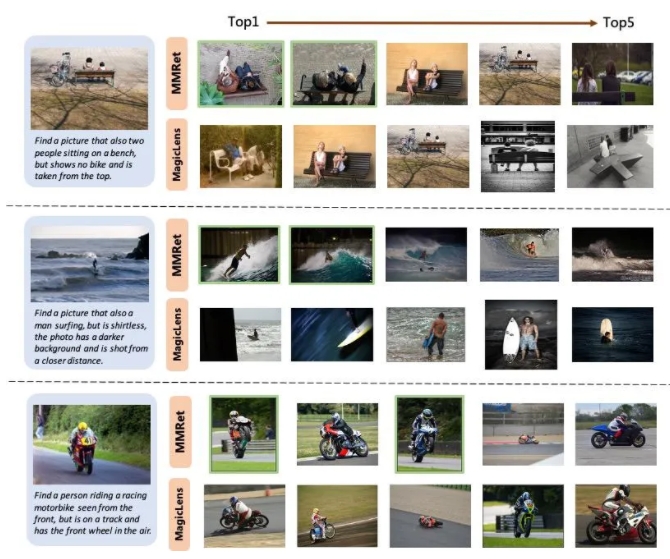

在组合图像检索任务中,BGE-VL的表现尤为引人注目。它在CIRCO评测集上刷新了现有基准,大幅超越了谷歌的MagicLens系列和英伟达的MM-Embed等对比基线。其中,BGE-VL-MLLM较之前的SOTA模型提升了8.1个百分点,而BGE-VL-Base模型则以不到1/50的参数量,超越了其他大模型底座的多模态检索器,这一成就令人瞩目。

此外,研究还表明,MegaPairs数据集不仅在性能上表现出色,还具有良好的可扩展性和高效性。随着数据规模的不断扩大,BGE-VL模型展现出了一致的性能增长趋势。与在37M闭源数据上训练的SOTA模型Google MagicLens相比,MegaPairs仅需1/70的数据规模(0.5M),便能实现显著的性能优势。这一发现不仅为多模态检索技术的发展提供了有力支持,也为未来的研究和应用提供了新的方向。

对于感兴趣的开发者和研究人员来说,项目主页已经开放,可以访问GitHub - VectorSpaceLab/MegaPairs获取更多详细信息。同时,模型地址也已公布,可通过Hugging Face获取相关模型资源。