7月4日,腾讯公司宣布,其开发的混元文生图大模型——混元DiT,正式推出小显存版本,仅需6GB显存即可流畅运行,为广大开发者提供了更为便捷的本地部署方案。

与此同时,腾讯还对外开源了混元文生图打标模型“混元Captioner”,这一模型支持中英文双语,针对文生图场景进行了特别优化,能够显著提升开发者构建文生图数据集的效率。

混元DiT模型的此次升级,不仅推出了小显存版本,还与Kohya训练界面进行了整合,并升级至1.2版本,旨在进一步降低技术门槛,同时提高生成图像的质量。

DiT架构的文生图模型以其生成图像的卓越质感而著称,但对显存的高要求一直是其普及的障碍。为此,混元DiT特别推出了小显存版本,仅需6GB显存即可运行优化后的推理框架,极大地方便了个人电脑用户进行本地部署。

在与Hugging Face的合作下,混元DiT的小显存版本、LoRA和ControlNet插件已经成功适配到Diffusers库中。开发者现在可以通过极为简洁的代码调用来使用这些功能,无需下载原始代码,大大降低了使用成本。

此外,混元DiT还宣布接入了Kohya,这是一个开源的轻量化模型微调训练服务,它提供了一个图形化的用户界面,使得开发者可以轻松地训练自己的LoRA模型,而无需深入代码层面。

Kohya的用户可以通过图形化界面完成模型的全参数微调和LoRA训练,训练出的模型可以无缝集成到Kohya生态系统中,并与WebUI等推理界面结合,实现从训练到生成图像的完整工作流程。

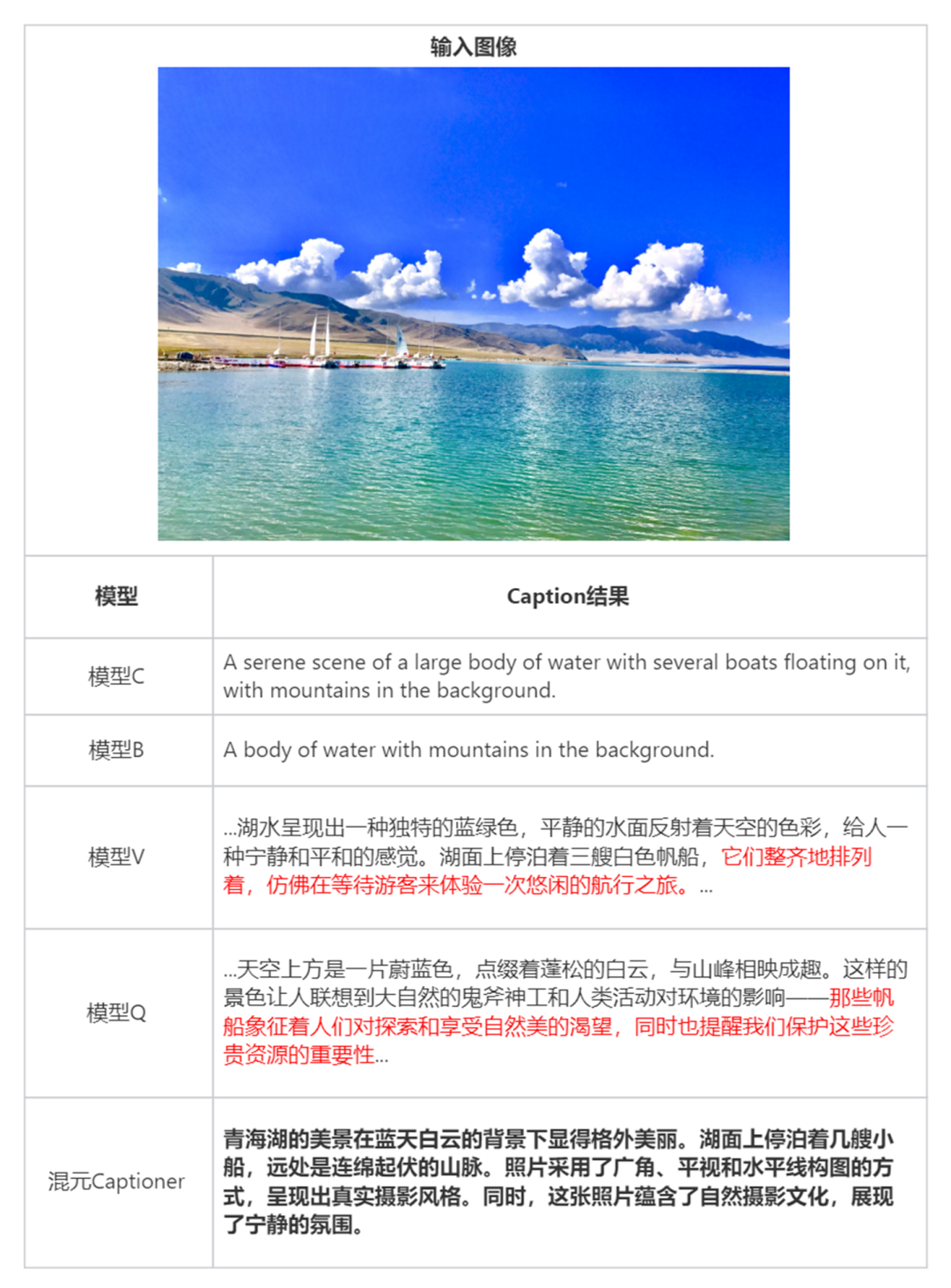

腾讯混元团队最新开源的混元Captioner模型,进一步增强了模型的易用性。该打标模型能够帮助开发者快速生成数据集,无论是导入原始图片集生成标注,还是对已有图片和描述进行优化,混元Captioner都能提供强大的支持。

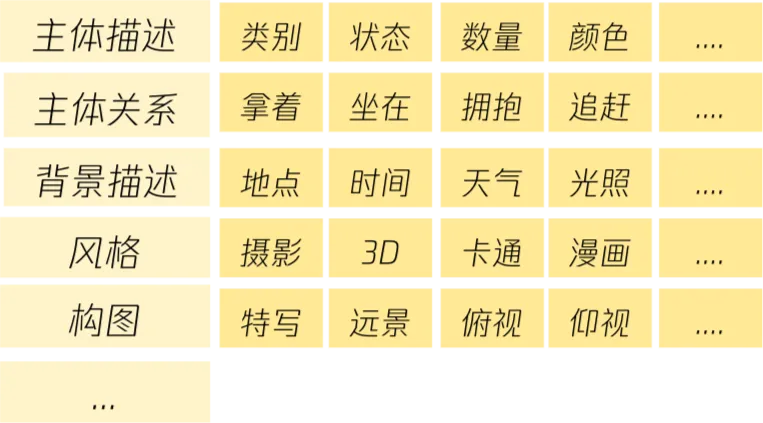

当前,业界在生成图片描述文本时,常面临描述过于简单或繁琐、缺乏背景知识以识别知名人物和地标等问题,且许多模型对中文的支持不够精准。混元Captioner针对这些痛点进行了专门优化:

-

构建了一个结构化的图片描述体系;

-

在模型层面,通过整合人工标注、模型输出和公开数据等多种来源,提升了描述的完整性;

-

注入了包括文学作品形象、地标、食物、动物、中国元素等在内的丰富背景知识。

腾讯混元开源文生图大模型的相关链接如下:

-

官网:https://dit.hunyuan.tencent.com/

-

代码:https://github.com/Tencent/HunyuanDiT

-

模型:https://huggingface.co/Tencent-Hunyuan/HunyuanDiT

论文:https://tencent.github.io/HunyuanDiT/asset/Hunyuan_DiT_Tech_Report_05140553.pdf