7月5日,2024年世界人工智能大会(WAIC 2024)上,面壁智能的联合创始人兼首席科学家刘知远向世界宣布了一项重大突破:开源了新一代高效能、低功耗的人工智能模型——“面壁小钢炮”MiniCPM-S,同时推出了全栈工具集MobileCPM,旨在帮助开发者轻松构建大模型SuperApp。

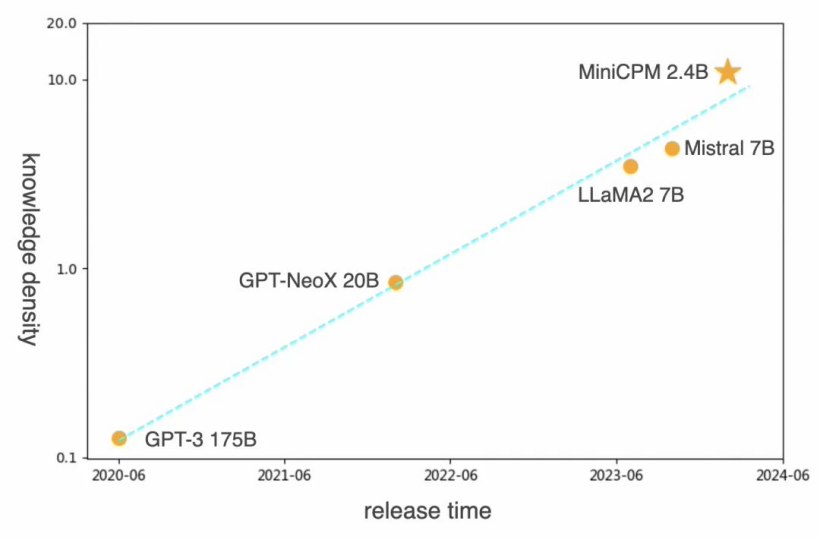

面壁智能在2024年的创新之旅中,推出了性能媲美GPT-3的MiniCPM-2.4B,其参数量仅为24亿,知识密度却提升了约86倍。公司表示,这仅仅是个开始,他们通过不断优化的Scaling Law,将持续提升模型的知识密度,训练出更高效、性能更强的基础大模型。

此次开源的MiniCPM-S模型,采用了先进的“稀疏激活”技术,有效降低了大模型的推理能耗。这种技术通过减少每个词元激活的神经元数量,实现了在同等参数下的能耗显著降低。

MiniCPM-S 1.2B模型采用了高度稀疏的架构设计,通过替换传统的激活函数为ReLU,并结合渐进式的稀疏感知训练,巧妙地解决了以往大模型在稀疏激活上的难题。

与同等规模的稠密模型相比,MiniCPM-S 1.2B展现出以下显著优势:

-

Sparse-高稀疏度带来的低能耗:在FFN层实现了平均87.89%的高稀疏度,推理算力需求大幅下降84%;

-

Speed-极速推理:减少了计算量,响应速度显著提升。在纯CPU环境下,结合Powerinfer推理框架,推理解码速度提升了约2.8倍;

Strong-保持强大性能:即便计算量减少,下游任务的性能依然不受影响。

MiniCPM-S 1.2B在知识密度上实现了“前所未有的提升”,达到了同规模稠密模型MiniCPM 1.2B的2.57倍,Mistral-7B的12.1倍。

开源链接如下:

-

论文地址:https://arxiv.org/pdf/2402.13516.pdf

-

模型地址:https://huggingface.co/openbmb/MiniCPM-S-1B-llama-format

-

PowerInfer直接运行格式:https://huggingface.co/openbmb/MiniCPM-S-1B-sft-gguf

面壁智能还开源了业界首个端侧大模型工具集MobileCPM,使开发者能够轻松将大模型集成到App中,并实现“即插即用”。该工具集包含了开源端侧大模型、SDK开发套件以及翻译、摘要等多样化功能,能够满足不同应用场景的定制需求。MobileCPM默认集成了面壁新一代的高效稀疏架构模型MiniCPM-S 1.2B。

目前,MobileCPM已经支持iOS系统,安卓版本也在紧锣密鼓地开发中。开源地址和TestFlight外测地址已对外公布。