谷歌的新一代语言模型Gemma 2一经问世,便引起了学术界的广泛关注。清华大学和北京航空航天大学的两位博士生,凭借其深厚的专业知识和创新精神,迅速推出了经过指令微调的Gemma 2模型,显著提升了模型在中文对话、角色扮演、数学计算以及工具使用等方面的能力。

在国际大型语言模型(LLM)中,非英语语言往往面临着性能上的不平等待遇,这种差距在某些情况下甚至可以用“悬殊”来形容。此前,有用户发现GPT-4o的分词器语料库中,中文数据的污染问题严重,充斥着赌博和色情网站,这严重影响了中文用户与AI的交流体验。

尽管Gemma 2模型开源且功能强大,但其在中文处理能力上与英文相比仍有一定差距。然而,这一问题可以通过微调技术得到有效解决。“Fine-tune it!”成为改善模型性能的口号。

7月1日,Gemma 2发布仅4天后,清华大学的人工智能博士生王慎执便在X平台发布了经过微调的Gemma-2-9B-Chinese-Chat模型。

Gemma-2-9B-Chinese-Chat是专为中文和英文用户量身定制的Gemma-2模型,针对超过10万个偏好对进行了精细调整。

该模型在中文提示方面表现出色,逻辑、编码、数学和写作技能均有所提升。

更多项目详情,可以在Huggingface平台查阅。

项目地址:[Gemma-2-9B-Chinese-Chat](https://huggingface.co/shenzhi-wang/Gemma-2-9B-Chinese-Chat)

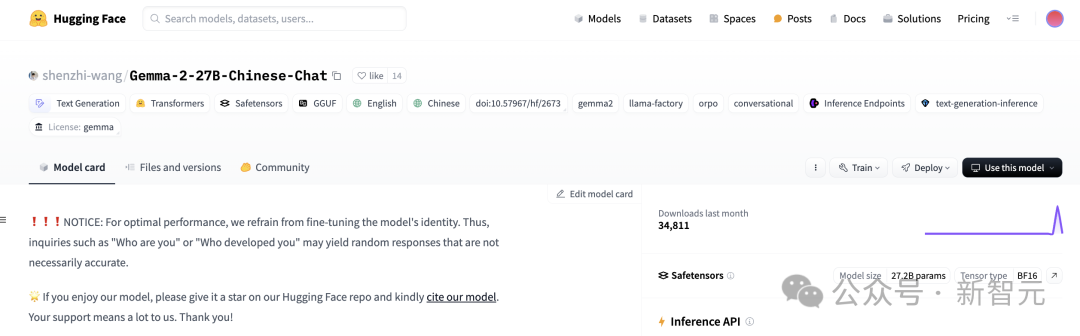

令人惊喜的是,仅隔一天,27B的微调版本也正式上线。根据HuggingFace主页信息显示,模型的下载量已突破3.4万次。

项目地址:[Gemma-2-27B-Chinese-Chat](https://huggingface.co/shenzhi-wang/Gemma-2-27B-Chinese-Chat)

项目介绍中提到,采用的微调算法为ORPO,该算法将监督微调和RLHF或DPO等偏好对齐方法相结合,是一种创新的算法。

与原始的9B Gemma 2模型相比,经过微调的Gemma-2-9B-Chinese-Chat在减少“中文问题英文回答”和“中英文混杂回答”的现象上取得了显著进步,同时在角色扮演、工具使用和数学计算方面也有所提高。

即使是面对“最佳中文训练数据”弱智吧的挑战,微调后的模型也能给出出色的回应。

示例

微调模型的贡献者提供了包括角色扮演、函数调用、数学问题、弱智吧挑战、安全问题、写作和编码在内的多个示例。

此外,还提供了一个在线demo,让用户可以亲身体验模型的强大功能。

角色扮演

首先让模型扮演周杰伦进行rap表演,接着尝试扮演鲁智深,示例如下:

但通过在线demo的测试发现,这位鲁智深的“粗鲁”表现还有待提高,目前连续性表现尚不理想。

数学

无论是年龄问题还是经典的鸡兔同笼问题,Gemma-2-9B-Chinese-Chat都能轻松解决。

弱智吧

尽管NLP程序员通常对弱智吧的文字游戏感到头疼,但微调模型在处理这类问题时表现出了不错的能力。

函数调用

用户可以通过特定的输入格式,调用模型中的各种工具,例如:

用户输入示例:

Hereisalistoftoolsthatyouhaveavailabletoyou:```pythondefinternet_search(query:str):"""ReturnsalistofrelevantdocumentsnippetsforatextualqueryretrievedfromtheinternetArgs:query(str):Querytosearchtheinternetwith"""pass``````pythondefdirectly_answer():"""Callsastandard(un-augmented)AIchatbottogeneratearesponsegiventheconversationhistory"""pass```Write'Action:'followedbyalistofactionsinJSONthatyouwanttocall,e.g.Action:```json[{"tool_name":"toolname(oneof[internet_search,directly_answer])","parameters":"theinputtothetool"}]

微调模型输出示例:

[{"tool_name":"internet_search","parameters":{"query":"biggestpenguinintheworld"}}]

安全

写作

当要求模型撰写关于人工智能的综述时,模型能够提供如下内容:

人工智能(AI)是计算机科学的一个分支,专注于创造能够执行复杂任务的智能机器。AI旨在开发能够学习、解决问题和理解自然语言的系统。人工智能的应用领域广泛,包括图像识别、语音助手、推荐系统、自动驾驶汽车和预测性维护等。

AI技术涵盖了机器学习、深度学习和自然语言处理等多个子领域。机器学习是AI的一个分支,致力于开发能够从数据中学习并进行预测的算法。深度学习作为机器学习的一个子集,使用人工神经网络模拟人脑功能。

AI在医疗保健、金融、运输和零售等行业中发挥着重要作用。在医疗领域,AI助力医生诊断疾病、预测患者护理需求和制定个性化治疗计划。在金融行业,AI被用于欺诈检测、风险管理和提供个性化投资建议。

AI技术在提高效率、降低成本和推动创新方面具有巨大潜力。然而,它也带来了就业流失、隐私问题和伦理挑战。随着AI技术的快速发,各国政府和组织正在制定新的法律和法规来应对这些挑战。

人工智能是当今世界最具创新性的力量之一。随着技术的不断进步,AI有潜力彻底改变我们的工作、生活方式和社会结构。同时,AI也引发了新的伦理和社会问题,这些问题需要我们深入思考。

编码

用户请求模型用Python实现快速排序算法,并要求输入为float类型的列表,返回排序后的列表,同时代码需要添加中文注释。模型输出示例如下:

defquick_sort(nums):#快速排序的递归函数#如果列表长度小于等于1,则直接返回,因为列表已经是排序好的iflen(nums)<=1:returnnums#选择基准值,这里选择列表的第一个元素pivot=nums[0]#分隔列表,将小于基准值的元素放在左侧,大于基准值的元素放在右侧left=numfornuminnums[1]ifnum<pivotright=numfornuminnums[1]ifnum>=pivot#递归地对左侧和右侧进行快速排序left=quick_sort(left)right=quick_sort(right)#将左侧、基准值、右侧合并成一个排序后的列表returnleft+[pivot]+right

作者信息

王慎执和郑耀威是Gemma-2-9B-Chinese-Chat和Gemma-2-27B-Chinese-Chat微调模型的主要贡献者。

王慎执是清华大学自动化系LEAP实验室的三年级博士生,师从宋士吉教授和黄高副教授。他在北京航空航天大学沈元荣誉学院计算机科学与技术专业以优异成绩获得工学学士学位。

王慎执是开源项目的积极推动者,曾发布多个流行的微调LLM,如Llama3-8B-Chinese-Chat、Llama3-70B-Chinese-Chat和Mirage-7B-v0.3-Chinese-Chat等。

在业余时间,王慎执还在知乎上撰写中文科技博客,拥有超过10k的粉丝。郑耀威是王慎执在本科期间的同学,两人曾多次合作。

郑耀威目前仍在北航攻读博士学位,他以第一作者身份在CVPR、AAAI、WWW等顶级会议上发表了多篇论文,并担任多个会议和期刊的审稿人。

他还是大模型微调框架LLaMA Factory的发起人和主要开发者,该项目在GitHub上获得了超过2万星标。

在这些杰出贡献者的努力下,开源模型的发展道路将越来越宽广,模型的中文处理能力也将不断增强。

<