在人工智能领域,强化学习一直是推动技术进步的关键力量。而随着 DeepSeek R1 的问世,强化学习在大模型中的应用潜力被进一步释放。尤其是 Reinforcement Learning with Verifiable Reward(RLVR)技术的出现,为多模态任务带来了全新的优化路径。从几何推理到视觉计数,从图像分类到物体检测,RLVR 在这些任务中的表现都远远超过了传统的监督微调(SFT)方法。

不过,此前的研究大多集中在 Image-Text 多模态任务上,对于更复杂的全模态场景,如视频中的多模态融合,研究还相对较少。为了填补这一空白,通义实验室团队积极探索 RLVR 与视频全模态模型的结合,并于近日宣布开源 R1-Omni 模型。

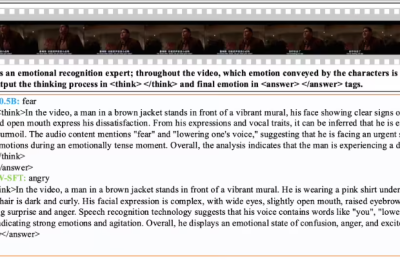

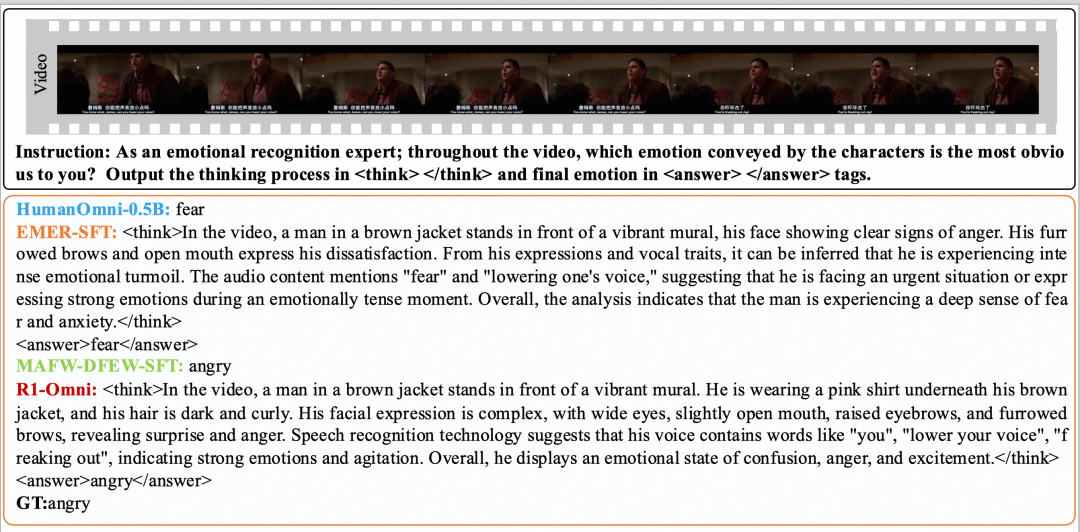

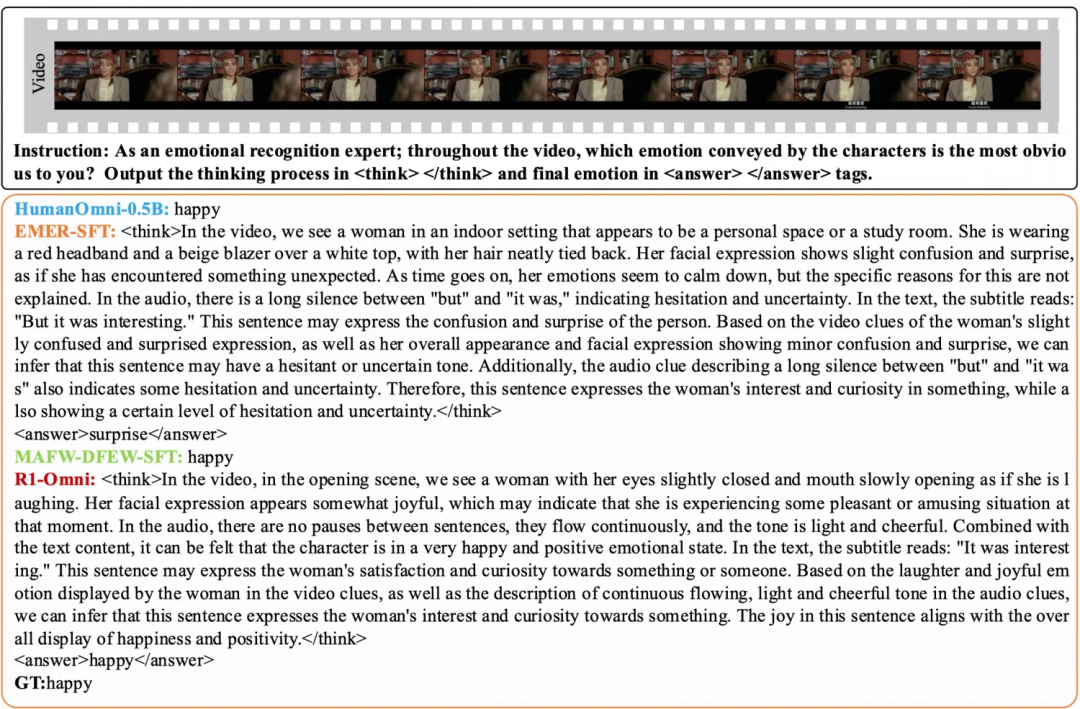

R1-Omni 的一大显著特点是其出色的透明性,即推理能力。借助 RLVR 方法,音频和视频信息在模型中的贡献变得更加清晰,模型能够明确展示不同模态信息在情绪识别等任务中的关键作用。

以情绪识别为例,R1-Omni 可以清楚地分析哪些模态信息对特定情绪的判断起到了决定性作用。这种透明性不仅提高了模型的可解释性,也为多模态任务的优化提供了新的思路。

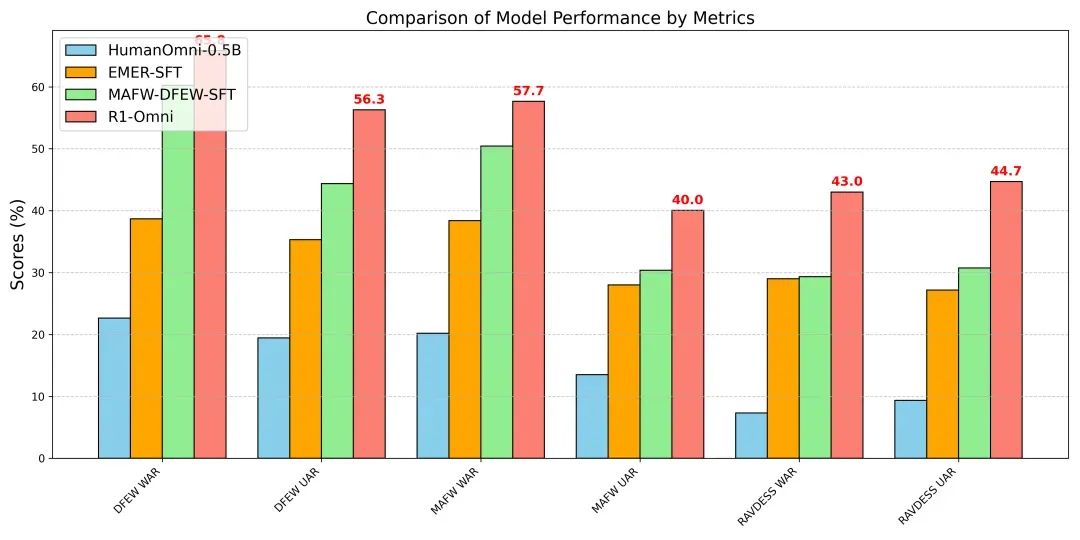

为了验证 R1-Omni 的性能,通义实验室团队进行了广泛的实验,将其与原始的 HumanOmni-0.5B 模型、冷启动阶段的模型以及在 MAFW 和 DFEW 数据集上进行有监督微调的模型进行了对比。实验结果显示,在同分布测试集(DFEW 和 MAFW)上,R1-Omni 相较于原始基线模型平均提升超过 35%,在 UAR 指标上相较于 SFT 模型的提升更是高达 10% 以上。

更令人印象深刻的是,R1-Omni 在不同分布测试集(RAVDESS)上也展现出了卓越的泛化能力。其 WAR 和 UAR 指标均提升超过 13%,这充分证明了 RLVR 在提升推理能力和泛化性能方面的显著优势。

随着 R1-Omni 的开源,研究人员和开发者将能够更深入地探索强化学习在多模态任务中的应用潜力。这一模型的推出不仅为情绪识别等任务提供了新的解决方案,也为未来多模态人工智能的发展奠定了坚实的基础。

感兴趣的读者可以通过以下链接获取更多关于 R1-Omni 的信息:

-

论文:[https://arxiv.org/abs/2503.05379](https://arxiv.org/abs/2503.05379)

-

Github:[https://github.com/HumanMLLM/R1-Omni](https://github.com/HumanMLLM/R1-Omni)

模型:[https://www.modelscope.cn/models/iic/R1-Omni-0.5B](https://www.modelscope.cn/models/iic/R1-Omni-0.5B)