深入剖析存储行业的动态后,本文聚焦于HBM市场的供需状况及其对相关企业业绩的潜在影响。

经过对市场数据的细致分析,我们发现当前HBM的供需紧张局势可能不会持续太久。尽管多数机构仍持供不应求的观点,但若各厂商的产能扩张计划顺利实施,市场或将面临供过于求的风险。

在对供需关系的评估中,部分市场分析将台积电的CoWos产能视为需求的风向标。然而,我们认为HBM的真正需求应从AI服务器及其背后的云服务提供商着手考量。通过分析这些企业的资本支出和AI服务器的出货量,我们能更准确地把握市场需求。若AI服务器的出货量未达预期,上游的CoWos和HBM供应商可能面临产能过剩的困境。

基于云服务提供商的资本支出和AI服务器出货量,结合存储厂商的产能扩张计划,我们预计HBM市场将从2023年末的供不应求,转变为2024年末的供过于求。

目前HBM供应紧张的局面,我们认为主要原因有二:一是产能提升和良品率的改善需要时间;二是三星的新产品尚未进入英伟达的供应链。随着产能和良品率的逐步提升,以及三星产品通过认证,HBM的供应紧张状况有望得到缓解。

从需求端来看,HBM市场有望带来逾百亿美元的增长空间。然而,考虑到三家主要厂商的产能规划,美光科技可能仅能占据约10%的市场份额,为公司带来约10亿美元的收入增长,占其总收入的比例不足5%。

美光科技的股价上涨,除了HBM的增量因素外,还得益于传统产品的市场回暖。即便如此,根据公司2025财年超过80亿美元的核心经营利润预期,当前股价对应的市盈率约为18倍,对于一个具有明显周期性特征的公司而言,并不算低估。股价的进一步上涨需要更多超出预期的表现,例如AI PC和AI手机的普及、互联网公司对AI服务器采购的大幅增加,或是竞争对手的不足为公司创造额外机会等。以下是对HBM供需关系和美光业绩的详细分析。

一、HBM供需关系分析

在对美光及存储公司的估值进行预测之前,HBM的供需关系是关键。随着AI服务器需求的增长,对HBM的需求也将显著提升。短期内需求的激增可能导致供需失衡,而存储厂商也相应地提高了产能扩张的预期。

HBM供需失衡的状况是否会持续?供给端:可以通过主要存储厂商的HBM产能规划来分析;需求端:市场机构通常通过台积电CoWos产能来推算需求,但我们认为应更关注最终消费者,即从AI服务器及互联网大厂的资本支出来评估需求。

1.1 互联网大厂资本支出与AI服务器

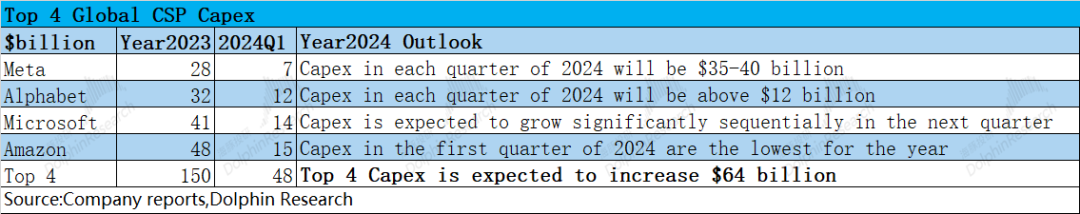

HBM主要应用于AI服务器,而互联网大厂购买这些服务器用于训练和推理。因此,这些大厂的资本支出直接影响AI服务器的出货量。随着GPT等技术需求的增长,主流云服务提供商纷纷增加了资本支出。2023年,四大云服务提供商(Meta、谷歌、微软和亚马逊)的资本支出总计达到1500亿美元。

根据一季度各公司管理层的交流情况,预计这四家公司的资本支出在本年度都将有所增加,我们预计它们的总资本支出有望增加640亿美元,同比增长42%。

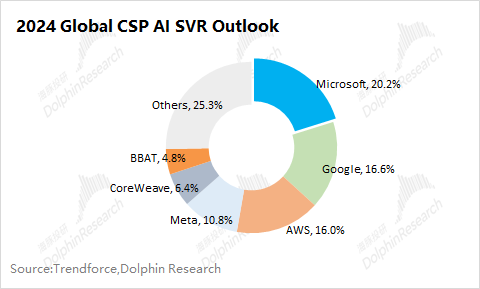

在乐观的假设下,如果这四家云服务提供商增加的资本支出全部用于购买AI服务器,我们可以评估AI服务器及HBM的市场需求。从AI服务器的市场份额来看,这四家云服务提供商大约占据了市场的70%。在乐观的假设下,我们预计2024年全球对AI服务器的市场需求增长将达到1000亿美元左右。

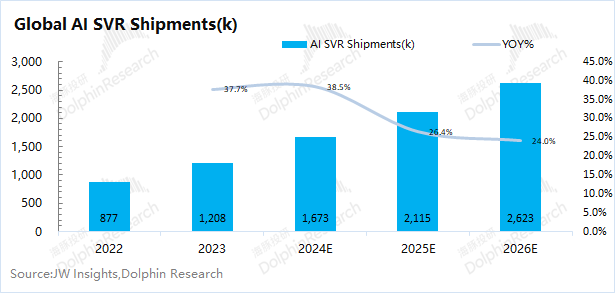

结合市场和行业情况,我们预计2024年AI服务器的出货量有望增加至167.3万台,同比增长46.5万台。

在1000亿美元的全球AI服务器新增采购额预期下,我们可以估算出单台AI服务器的平均价格约为21.5万美元。

综合数据分析,我们认为AI服务器的出货量预期是合理的,预计出货量同比增长38.5%。随着AI服务器的升级和平均价格的提升,在资本支出不变的情况下,可能会影响AI服务器出货量的增长。除非云服务提供商进一步增加资本支出。

1.2 对HBM供需缺口的测算

对HBM供需缺口的测算有助于我们理解和把握HBM的价格和市场变化。需求端从终端消费的AI服务器出发;供给端从存储厂商的产能规划来预期。

1)HBM需求端

结合市场和行业的预期,2024年AI服务器的出货量有望达到167万台。此外,今年GPU市场推出了GB200等新产品,单卡的容量达到140GB。因此,我们也调整了AI服务器中单卡的平均容量预期。

总体而言,在AI服务器出货量提升和升级的背景下,市场对HBM的需求将继续快速增长。在乐观的情况下,2024年HBM的需求端有望提升至512MGB,同比增长80%。

2)供给端

目前HBM市场供不应求,存储厂商的产能规划直接影响了HBM的供给情况。目前,HBM市场主要由海力士、三星和美光三家厂商占据。从这三家厂商的产能规划来看,在下游需求的推动下,它们都对HBM进行了明显的扩产。到2024年末,HBM的产能有望提升至273K/m,接近去年年底的3倍。

根据存储厂商的产能规划,我们可以推算整体HBM的供给情况。从2023年末的每月93K到2024年末的每月273K,存在一个产能爬坡过程。因此,2024年的年产能使用两年年末产能的加权平均数来测算,大约有2196k片的晶圆。以HBM3/HBM3E(11mm*11mm)为例,单片12寸晶圆大约能切割491颗芯片。我们做出以下假设:1)切割效率为90%;2)TSV等良品率55%;3)平均单颗粒的容量提升至2.2G左右。

我们可以测算出,HBM的供给端有望从2023年的147MGB提升至2024年的1174MGB,接近去年同期的8倍。这一大幅提升主要得益于大规模的产能扩张、TSV良品率的提升和单颗粒容量的增加。

3)供需端比较

由于目前三大存储厂商仅披露了2023年和2024年的产能情况,我们主要比较这两年HBM的供需关系。①需求端:结合云服务提供商的资本支出和AI服务器出货量,市场对HBM的需求有望从2023年的284MGB提升至512MGB;②供给端:结合存储主流厂商的产能计划,HBM的供给端更可能从2023年的147MGB快速提升至1000MGB以上;③供需关系:2023年供给端仅能满足需求的一半,严重供不应求。供不应求的局面促使各家厂商大幅提升产能计划。如果产能规划如实落地,2024年HBM的供需关系可能会出现明显反转,供给端反而可能超出整体市场需求。

1.3 对HBM供需关系的看法

在研究过程中,我们注意到一些市场研究机构采用台积电CoWos的产能作为HBM需求端的数据,这主要是因为:①HBM和CoWos都是影响AI服务器GPU出货量的主要瓶颈;②HBM在生产流程中也需要交给CoWos,最终成为AI芯片的一部分。

在供给严重不足的情况下,CoWos的产能具有一定的参考价值。但对于供需关系本身,我们更应该关注最终消费者(支付方)。如果大厂的资本支出跟不上,AI服务器的出货量没有成倍增长,扩张的产能也可能转为过剩的一方。我们认为,在AI服务器的推动下,HBM确实存在供不应求的情况。但随着扩产的跟进,HBM市场可能会从“供不应求”转向“供过于求”。对HBM容量的需求有接近翻倍的提升,但供给端更是提升到将近8倍(如果各家产能计划如期落地的话)。这不是因为需求突然减弱,而是供给端提升太快,导致供需失衡。

如果HBM继续保持供不应求的局面,需要:①各家互联网大厂再次大幅度提升资本支出计划;②存储大厂的扩产计划及产品认证不及预期,设备采购及产能提升都出现延后。