在当下人工智能领域,尤其是大型语言模型(LLM)的热潮中,企业对高效且经济的AI解决方案的需求愈发强烈。谷歌于3月12日宣布推出Gemma 3开源AI模型,这一举措正是为了满足市场对轻量级、高性能AI模型的迫切需求。Gemma 3基于与Gemini 2.0相似的技术架构,但在设计上更加注重轻量化,显著降低了能源消耗和运营成本。

谷歌强调,Gemma 3是一款专为快速部署而设计的轻量级模型,能够轻松适配多种设备,如手机、笔记本电脑以及工作站等。该模型不仅支持超过35种语言,还具备处理文本、图像和短视频等多模态数据的能力,这使得其在多样化应用场景中展现出强大的适应性。

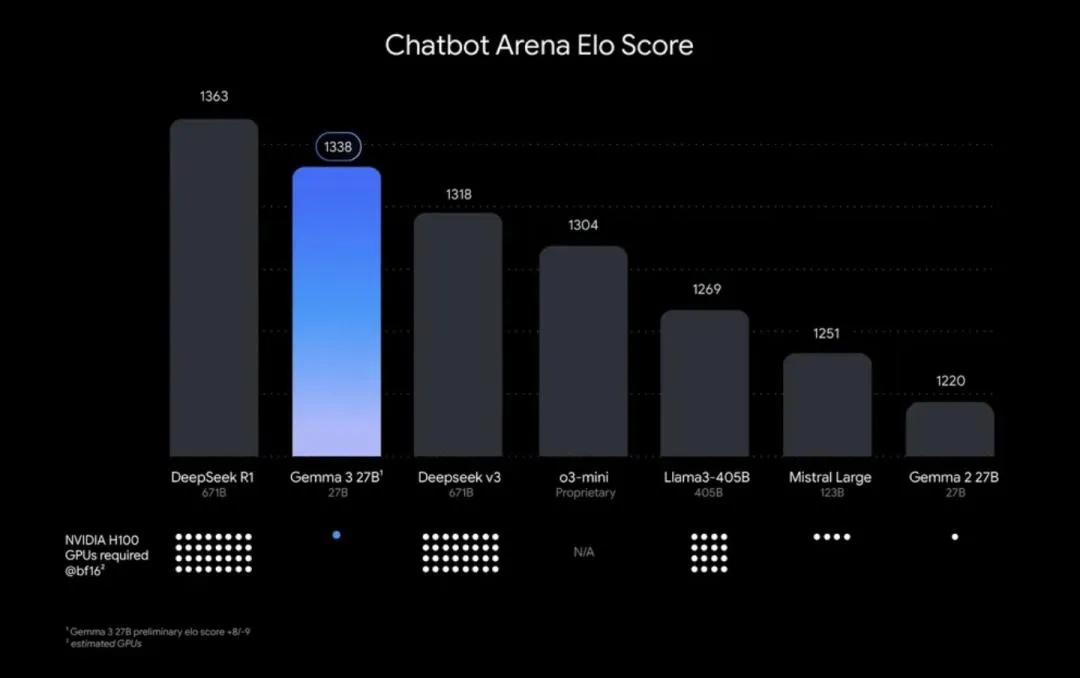

Gemma 3提供了多种不同规模的模型版本,包括10亿参数(1B)、40亿参数(4B)、120亿参数(12B)和270亿参数(27B)。开发者可以根据自身硬件条件和具体性能需求灵活选择合适的版本。谷歌在宣传中特别指出,Gemma 3在同尺寸范围内提供了最先进的性能,甚至在某些指标上超越了Llama-405B、DeepSeek-V3和o3-mini等其他知名LLM。其中,Gemma 3 27B版本在Chatbot Arena Elo评分中表现突出,仅次于DeepSeek-R1。

谷歌在其官方博客中详细介绍了Gemma 3的多项创新功能:

- 单加速器最佳性能:在LMArena排行榜的人类偏好评估中,Gemma 3的表现优于Llama-405B、DeepSeek-V3和o3-mini,特别适合在单GPU或TPU主机上运行。

- 多语言支持:Gemma 3不仅提供超过35种语言的开箱即用支持,还对140多种语言进行了预训练,极大地拓展了其在全球范围内的应用潜力。

- 高级文本和视觉推理能力:该模型能够分析图像、文本和短视频,为交互式应用带来了全新的可能性,例如在智能客服、内容创作等领域。

- 扩展的上下文窗口:Gemma 3的上下文窗口达到了128k tokens,远高于Gemma 2的80k,这使得它能够处理和理解更大量的信息,适用于需要长文本处理的场景。

- 函数调用功能:支持函数调用和结构化输出,方便用户自动化任务并构建智能代理,提升了模型在实际应用中的灵活性。

- 量化模型加速:Gemma 3引入了官方量化版本,在保持高精度的同时,进一步降低了模型大小和计算需求,使其更适合在资源受限的设备上运行。

谷歌自信地宣称,Gemma 3是“世界上最好的单加速器模型”,在单GPU主机上的性能超越了Llama、DeepSeek和OpenAI等竞争对手。此外,Gemma 3还与Hugging Face Transformers、Ollama、JAX、Keras、PyTorch等主流开发者工具实现了无缝集成。用户可以通过Google AI Studio、Hugging Face或Kaggle等平台轻松访问Gemma 3,而企业和开发者则可以通过AI Studio申请使用Gemma 3 API。

在架构优化方面,Gemma 3进行了两项关键改进。首先,为了解决长上下文推理过程中KV缓存内存增长的问题,谷歌采用了5:1的局部/全局层交错机制。通过增加局部注意力层的比例并缩短局部注意力跨度,Gemma 3有效缓解了长上下文时的KV缓存问题。此外,Gemma 3支持最长128K tokens的上下文长度,但1B参数模型的上下文长度为32K tokens。为此,Gemma 3将全局自注意力层的RoPE基频从10K提升至1M,而局部层的基频保持在10K。

在预训练方面,Gemma 3沿用了与Gemini 2.0相同的SentencePiece分词器,词汇表规模为262K,并针对非英语语言进行了优化。同时,Gemma 3还重新设计了数据混合策略,以提升模型的多语言能力,并融入了图像理解能力。相较于Gemma 2,Gemma 3增加了训练token量,以容纳图像和文本的混合数据。此外,Gemma 3还大幅增加了多语言数据,包括单语数据和平行语料。

在视觉模态方面,Gemma 3采用了SigLIP作为图像编码器,将图像编码成可由语言模型处理的token。其注意力机制对文本和图像输入的处理方式也有所不同:文本使用单向注意力,而图像则采用全局注意力,没有遮蔽,允许模型以双向方式查看图像的每个部分,从而对视觉输入进行完整且无限制的理解。

Gemma 3的发布引起了社区的广泛关注。许多网友对27B模型能够击败Claude 3.7 Sonnet表示惊讶,而开发者们则对谷歌的技术创新表示赞赏。谷歌Gemma团队成员alekandreev在Hacker News平台上回复用户提问时表示,模型大小的选择主要依据不同的设备类别,并且不同规模的模型是独立训练的。此外,InfoQ还注意到,alekandreev发布了Gemma团队的招聘启事,这表明谷歌对Gemma 3的未来发展寄予厚望。

自谷歌推出Gemma以来,小型语言模型的热度不断攀升。小型模型在特定任务中表现出色,尤其是在资源有限的环境中。蒸馏工艺作为一种将大型模型的知识转移到小型模型的技术,正逐渐成为企业优化AI部署的重要手段。然而,需要指出的是,Gemma并非Gemini 2.0的蒸馏版本,而是基于相同的数据集和架构独立训练而成。

越来越多的企业开始意识到,并非所有应用场景都需要大型语言模型的全部功能。例如,在简单的代码编辑器或特定领域的任务中,较小的模型可以更高效地完成任务,避免资源浪费和过度拟合的问题。谷歌Gemma 3的推出,无疑为那些寻求高效、经济且灵活的AI解决方案的企业和开发者提供了一个极具吸引力的选择。