在人工智能领域,一项突破性的进展正在重塑我们对大型语言模型(LLM)的理解。鄂维南院士带领的研究团队,在上海算法创新研究院的协作下,提出了一种全新的记忆格式——Memory3,旨在优化模型的存储效率并提升性能。

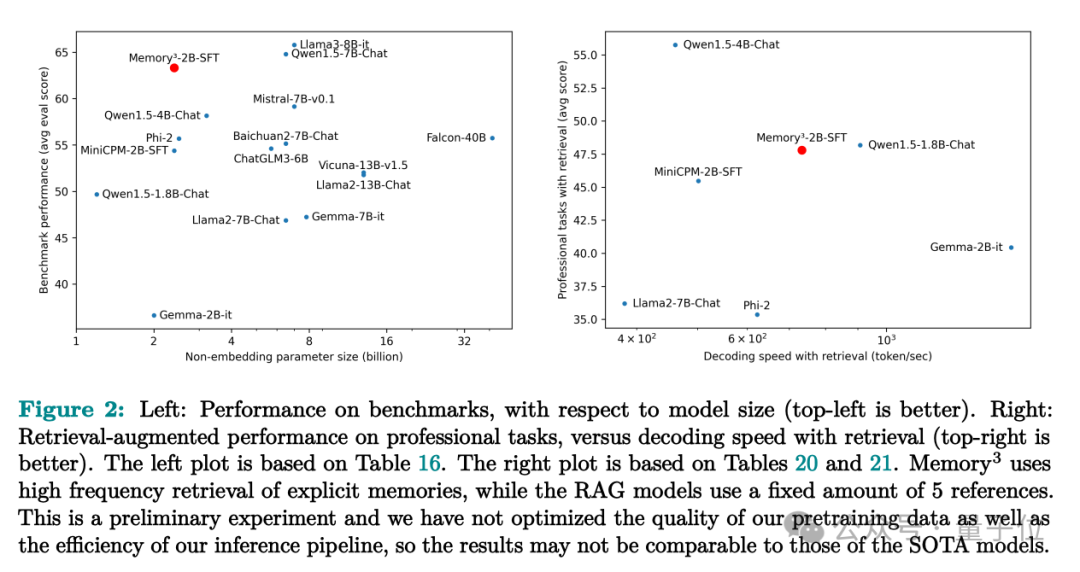

Memory3模型通过引入显式记忆,释放了原本用于存储知识的模型参数,这一创新使其在成本上远低于传统的参数存储方法和文本检索增强生成(RAG)技术,同时在解码速度上更胜一筹。实验结果显示,仅有2.4B参数的Memory3在多个领域,包括医学等专业任务中,超越了参数量更大的模型,并减少了推理过程中的“幻觉”现象。

这项研究的论文已经发布在arXiv上,迅速吸引了学术界的广泛关注。Memory3的核心理念是模仿人脑的记忆机制,将知识分为三类:显式记忆、隐式记忆和外部信息。显式记忆类似于我们能够主动回忆的长期记忆,如阅读过的书籍;隐式记忆则是无意识中使用的技能,例如骑自行车;而外部信息则类似于考试时的参考资料,容易获取但在解决新问题时效用有限。

在大型模型中,目前主要采用的是将知识以隐式记忆的形式存储在参数中,这种做法存在两个主要问题:一是知识分配效率不高,二是知识提取效率低下。Memory3模型通过模仿人脑的记忆机制,根据知识的使用频率,合理地在不同的记忆形式之间分配存储位置,有效降低了整体的计算成本。

研究团队进一步提出了记忆电路理论,重新定义了LLM中的知识和记忆,明确了哪些知识适合作为显式记忆存储,并设计了适合读写显式记忆的模型架构。通过分析大模型的内部机制,如事实问答和搜索复制粘贴等,团队认为每条知识都可以表示为一个输入-输出关系及其对应的内部电路。

Memory3模型的实现涉及到将所有引用文本在推理前转换为显式记忆,并保存在硬盘或非易失性存储设备上。在推理过程中,模型会检索与当前上下文最相关的显式记忆,并将它们整合到注意力机制中,共同参与生成下一个token的计算。

为了解决显式记忆带来的存储和计算挑战,Memory3采用了多维度的压缩策略,包括在layer、head和token维度上的稀疏化处理,以及使用向量量化技术进一步压缩key和value向量。这一系列优化措施使得显式记忆的规模从45.9TB大幅压缩至4.02TB,适应了GPU集群的存储容量。

在细节设计上,Memory3模型在推理时会每隔64个token进行一次检索,以避免重复检索显式记忆,并在内存中维护固定大小的缓存以存储最近访问过的记忆。此外,模型使用特定的输入符号区分参考文本和普通文本,确保了文本理解的准确性。

最终,Memory3模型在HuggingFace排行榜上的评测结果显示,显式记忆平均提升了2.51%的分数,相较于参数量更大的模型,这一提升在效率上相当于增加了51.1%的“有效模型大小”。在幻觉评估方面,Memory3也展现出了比大多数模型更少的信息丢失,表现更为优异。

这项研究不仅在理论上提供了深刻的见解,而且在实践中展示了Memory3模型的强大潜力。随着进一步的研究和发展,我们可以期待Memory3在未来的人工智能应用中发挥更大的作用。