7月9日,阿里云通义千问团队宣布开源两款先进的语音技术模型,分别为SenseVoice和CosyVoice,这标志着语音识别和语音生成技术的又一重大突破。

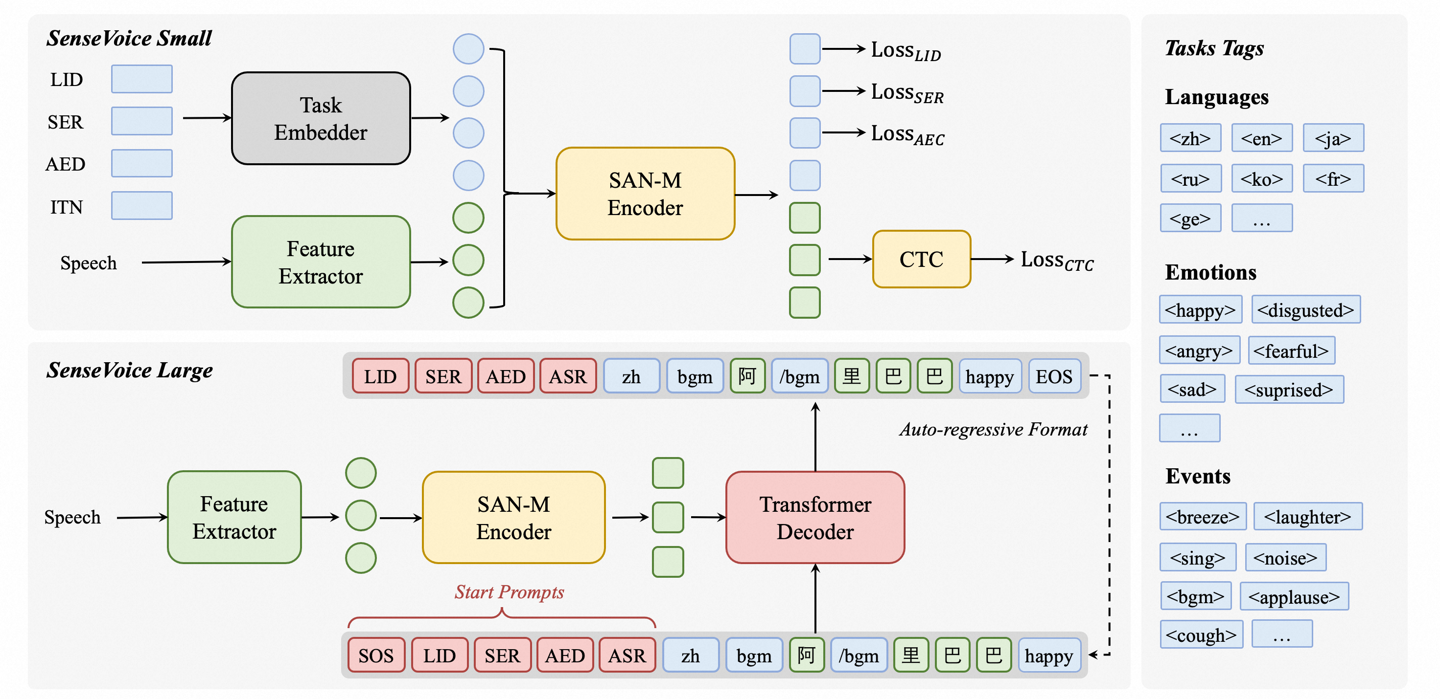

SenseVoice模型以其卓越的多语言语音识别能力而著称,其训练数据量超过40万小时,覆盖超过50种语言,识别精度超越了业界知名的Whisper模型。

-

在多语言识别领域,SenseVoice展现出了其强大的跨语言能力,无论是中文、英语还是其他小语种,均能实现精准识别。

-

模型的富文本识别功能同样令人瞩目,它不仅能够识别语音中的情感色彩,还能检测出背景音乐、掌声、笑声等多种声音事件,为语音分析提供了更多维度的信息。

-

SenseVoice-Small模型的高效推理能力尤为突出,其非自回归端到端框架设计,使得10秒音频的推理时间仅需70毫秒,速度是Whisper-Large的15倍。

-

此外,SenseVoice还提供了便捷的微调脚本和策略,使用户能够根据具体的业务需求,轻松解决长尾样本问题,实现模型的个性化定制。

在服务部署方面,SenseVoice提供了完整的部署方案,支持多并发请求处理,且客户端语言支持广泛,包括Python、C++、HTML、Java和C#等。

在与现有开源情感识别模型的对比测试中,SenseVoice-Large模型在几乎所有测试数据集上均取得了最佳性能,而SenseVoice-Small模型也在多数数据集上超越了其他开源模型。

CosyVoice模型则专注于语音生成领域,支持多语言、音色和情感的精细控制,特别在多语言语音生成、零样本语音生成、跨语言语音克隆以及指令跟随等方面表现出色,为语音合成技术的发展注入了新的活力。

这两款模型的开源,无疑将推动语音技术在更多领域的应用和发展,为开发者和企业提供了强大的工具和平台。

更多关于SenseVoice和CosyVoice的信息,可以访问以下链接:

SenseVoice: https://github.com/FunAudioLLM/SenseVoice

CosyVoice: https://github.com/FunAudioLLM/CosyVoice