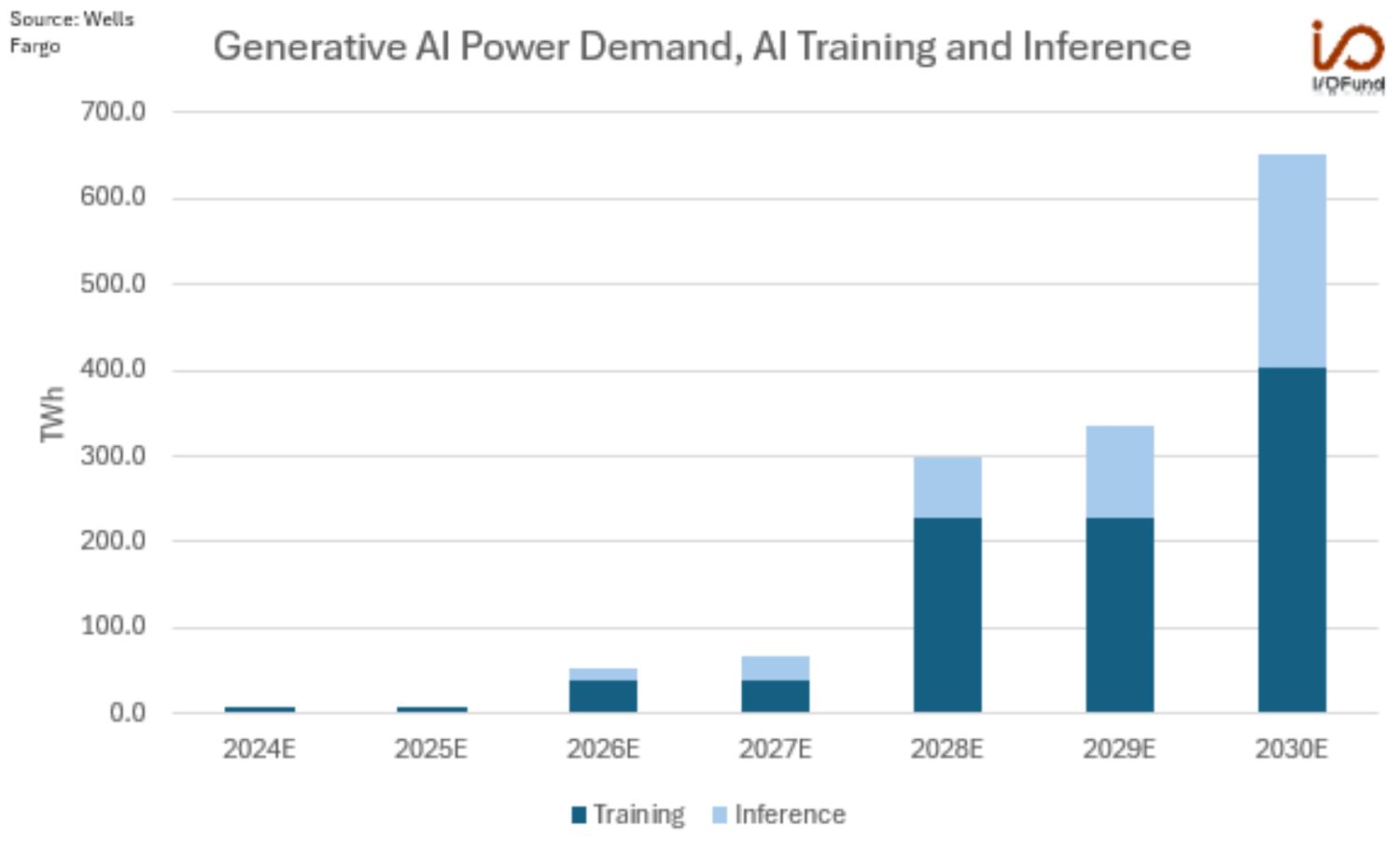

7月9日,金融巨头富国银行发布了一份引人注目的预测报告,指出人工智能(AI)领域的电力消耗正在以惊人的速度增长。据其分析,2024年AI的电力需求将达到8太瓦时(TWh),而到了2030年,这一数字将飙升至652太瓦时,增幅高达8050%。

富国银行进一步指出,AI的电力消耗主要是在模型训练上,预计到2026年将消耗40太瓦时,而到了2030年,这一数字将翻十倍,达到402太瓦时。同时,AI推理的电力消耗也将在本世纪20年代末迎来快速增长。

为了使读者对这些数字有更直观的认识,报告中还提供了一组对比数据:2023年,中国的年用电量为9224.1太瓦时,上海市为184.9太瓦时,深圳市为112.8太瓦时。通过这些数据,我们不难发现AI行业在电力消耗上的惊人潜力。

AI行业正面临着前所未有的电力需求挑战。以英伟达的H100 AI GPU为例,这款采用SXM外形设计的GPU,单机功耗就高达700瓦。而英伟达即将推出的下一代B200 AI GPU,其功耗更是达到了惊人的1200瓦。

AMD也不甘示弱,其上一代Instinct MI250 AI加速器的峰值功耗为560瓦,而新推出的MI300X AI加速器,峰值功耗提升至750瓦,增幅达到了50%。

英特尔同样在AI加速器领域取得了突破,其新款Gaudi 2 AI加速器的峰值功耗为600瓦,而Gaudi 3 AI加速器的峰值功耗更是达到了900瓦,同样实现了50%的增长。

更令人瞩目的是,英特尔的下一代Falcon Shore混合AI处理器,每个芯片的峰值功耗达到了1500瓦,刷新了行业记录。

这些数字仅仅是针对GPU部分的计算,如果将CPU和其他附加组件的耗电量也考虑在内,整体的电力消耗将更加惊人。以英伟达的GB200系统为例,该系统由2个B200 GPU和1个Grace CPU组成,其总功耗达到了2700瓦。

随着AI技术的不断进步和应用范围的不断扩大,电力消耗问题将成为行业发展的重要考量。如何平衡AI技术的快速发展与能源的可持续利用,将是未来AI行业需要面对的一大挑战。