7月12日,智谱AI团队宣布了一项突破性的进展,他们成功开发并开源了一款先进的视频理解模型——CogVLM2-Video。这一消息在人工智能领域引起了广泛关注,预示着视频内容分析和理解能力的巨大飞跃。

在现有的视频理解技术中,普遍采用的帧平均化和视频标记压缩技术常常导致关键时间信息的丢失,这不仅限制了模型对时间相关问题的准确回答能力,也使得模型在处理更广泛领域问题时显得力不从心。

针对这一挑战,智谱AI团队提出了创新的解决方案。他们基于视觉模型,开发了一种自动化的时间定位数据构建方法,成功生成了3万条与时间紧密相关的视频问答数据。这一创举不仅极大地丰富了训练数据的多样性,也为模型提供了更为精准的时间信息。

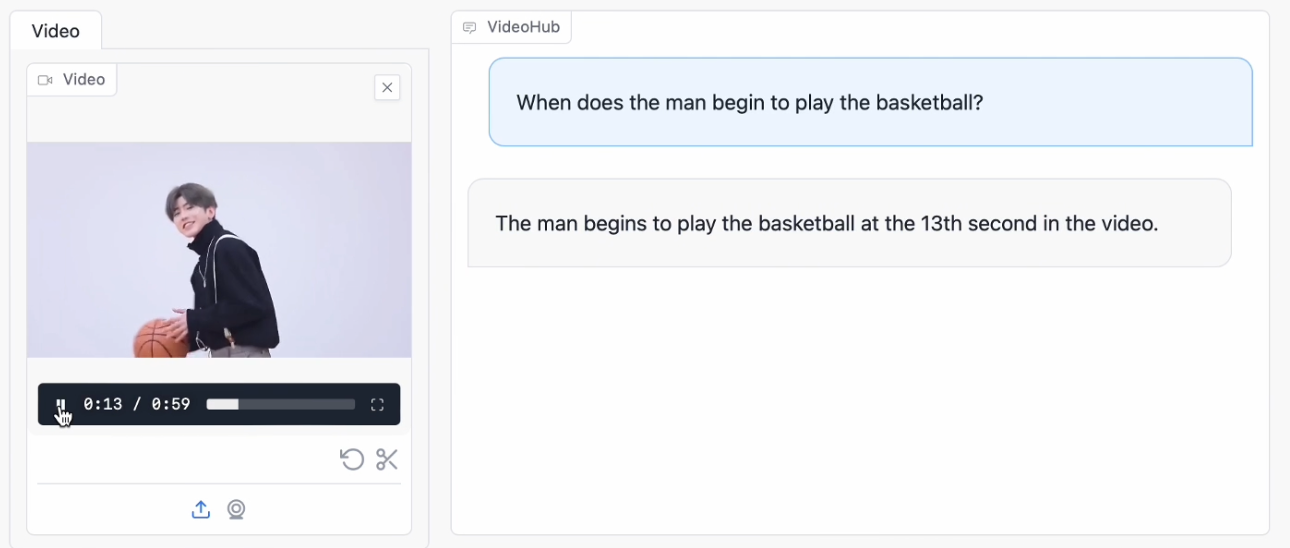

利用这些新生成的数据以及现有的开放领域问答数据,智谱AI团队进一步引入了多帧视频图像和时间戳作为编码器的输入,精心训练出了CogVLM2-Video模型。这一模型在处理视频内容时,不仅能够保持对时间信息的敏感度,还能够在视频字幕生成和时间定位方面展现出卓越的性能。

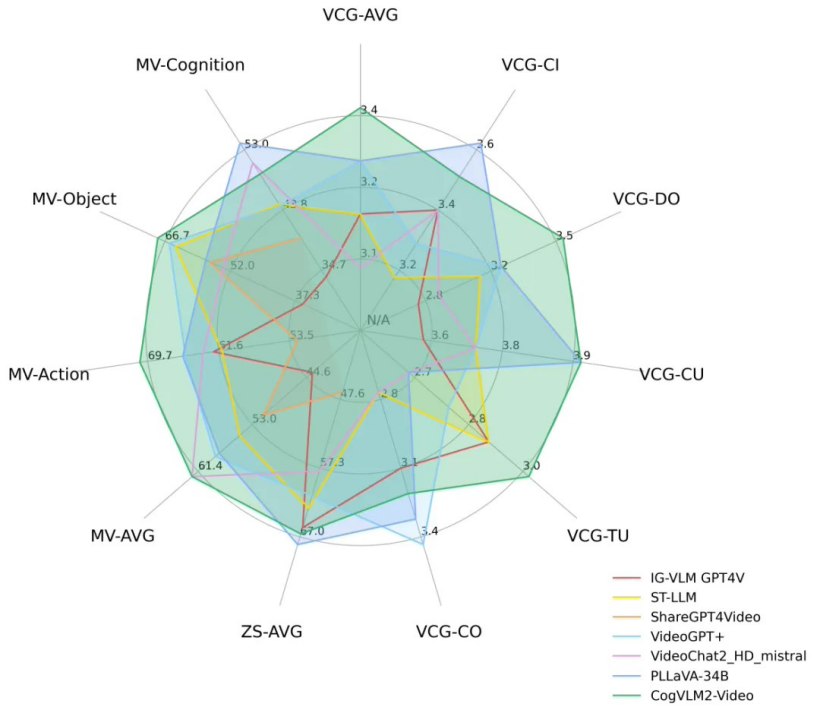

智谱AI团队自豪地表示,CogVLM2-Video模型在公共视频理解基准测试中已经达到了业界领先的水平。这一成就不仅体现了团队在视频理解技术方面的深厚积累,也为人工智能领域的未来发展提供了新的可能性。

对于有兴趣深入了解或试用CogVLM2-Video模型的开发者和研究人员,智谱AI团队提供了以下资源链接:

-

代码仓库:https://github.com/THUDM/CogVLM2

-

项目官网:https://cogvlm2-video.github.io

-

在线体验:http://36.103.203.44:7868/

这些资源将为人工智能领域的专业人士提供一个全新的视角,以探索和利用这一前沿技术。