在人工智能领域,多模态模型的发展正以前所未有的速度推进,而阿里云通义千问Qwen团队的最新成果——Qwen2.5-Omni,无疑是这一领域的又一重要里程碑。3月27日,Qwen团队正式宣布推出这一新一代端到端多模态旗舰模型,它不仅能够处理文本、图像、音频和视频等多种输入形式,还能实时生成文本和自然语音合成输出,为用户带来了全新的交互体验。

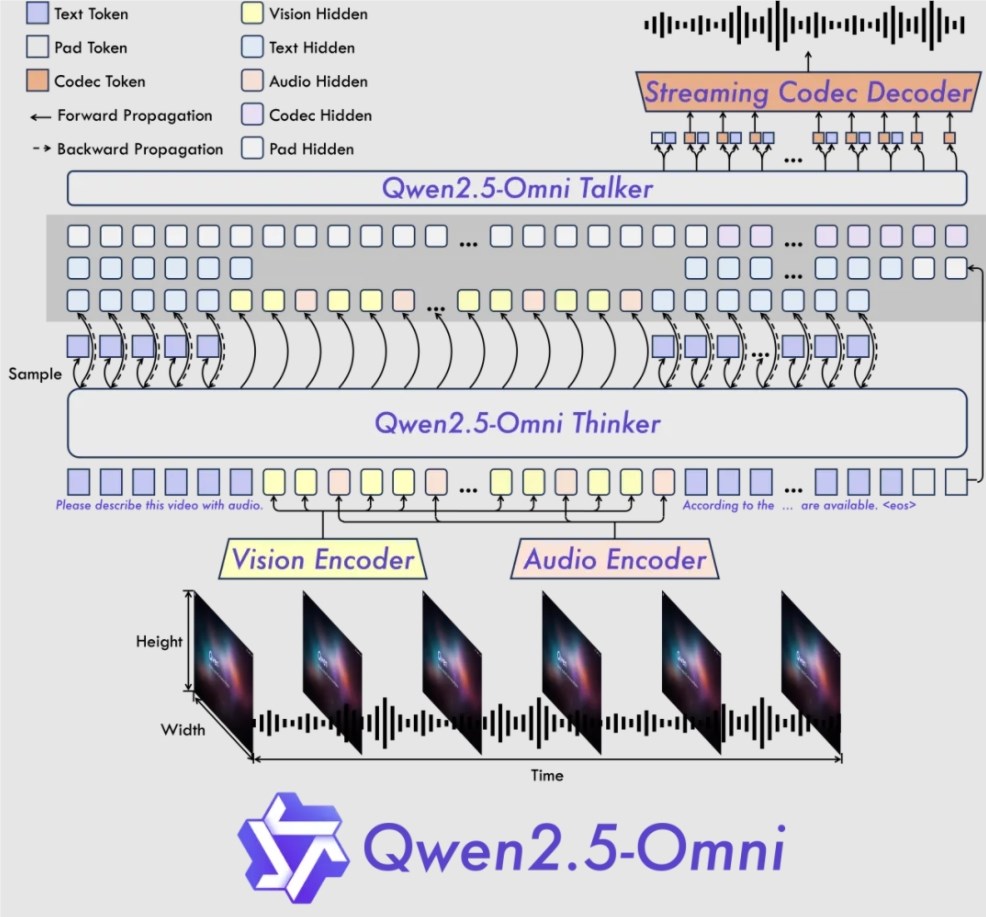

Qwen2.5-Omni的架构设计极具创新性,其采用的Thinker-Talker架构,将多模态输入处理与语音合成输出完美结合。Thinker模块如同一个智能大脑,能够对输入的多模态信息进行深度处理,生成高层次的语义表征和对应的文本内容。而Talker模块则如同一个发声器官,能够流畅地将Thinker模块生成的语义表征和文本内容转化为自然语音输出。此外,该模型还引入了一种名为TMRoPE(Time-aligned Multimodal RoPE)的新位置编码技术,通过时间轴对齐,实现了视频与音频输入的精准同步,进一步提升了模型在多模态任务中的表现。

在实时交互方面,Qwen2.5-Omni展现出了卓越的性能。它支持分块输入和即时输出,能够实现完全实时的音视频交互,这在以往的多模态模型中是难以想象的。无论是在语音生成的自然性还是稳定性上,Qwen2.5-Omni都超越了许多现有的流式和非流式替代方案。在全模态性能测试中,Qwen2.5-Omni不仅在音频能力上优于类似大小的Qwen2-Audio,还与Qwen2.5-VL-7B保持了同等水平。更令人印象深刻的是,它在端到端语音指令跟随方面表现出色,在MMLU通用知识理解和GSM8K数学推理等基准测试中,其表现与文本输入处理的效果不相上下。

Qwen2.5-Omni在多模态任务中的表现尤为突出。在OmniBench这一多模态任务中,Qwen2.5-Omni达到了SOTA(State-of-the-Art)的表现,超越了类似大小的单模态模型以及封闭源模型,如Qwen2.5-VL-7B、Qwen2-Audio和Gemini-1.5-pro。在单模态任务中,Qwen2.5-Omni同样表现优异,无论是在语音识别(Common Voice)、翻译(CoVoST2)、音频理解(MMAU)、图像推理(MMMU、MMStar)、视频理解(MVBench)还是语音生成(Seed-tts-eval和主观自然听感)等领域,它都展现出了强大的能力。

目前,Qwen2.5-Omni已经在多个平台上开源开放,包括Hugging Face、ModelScope、DashScope和GitHub。用户可以通过这些平台上的Demo体验其互动功能,或是通过Qwen Chat直接发起语音或视频聊天,沉浸式体验Qwen2.5-Omni模型的强大性能。无论是在技术层面还是在用户体验上,Qwen2.5-Omni都为多模态模型的发展树立了新的标杆,预示着人工智能在多模态交互领域的未来发展方向。

-

Qwen Chat:https://chat.qwenlm.ai

-

Hugging Face:https://huggingface.co/Qwen/Qwen2.5-Omni-7B

-

ModelScope:https://modelscope.cn/models/Qwen/Qwen2.5-Omni-7B

-

DashScope:https://help.aliyun.com/zh/model-studio/user-guide/qwen-omni

-

GitHub:https://github.com/QwenLM/Qwen2.5-Omni

-

Demo体验:https://modelscope.cn/studios/Qwen/Qwen2.5-Omni-Demo