各位小伙伴们,今天给大家带来一个令人眼前一亮的消息,腾讯又搞了个大动作,开源了一项超厉害的AI技术——HaploVL。这可不是一般的AI,它就像是拥有了“火眼金睛”,能让AI在处理图像和文字时更加得心应手,仿佛开启了“眼观六路,耳听八方”的模式。

说到现在的多模态大模型,它们在人工智能领域可是风头正劲,能看图说话,功能强大。但它们也有个小小的不足,那就是在处理图像细节方面有点力不从心。就好比让它们在一幅复杂的画面中找出某个细微之处,或者精确地比较两个物体的差异,它们可能就会犯难。

以往的解决方案要么是采用“视觉编码器+大语言模型”的组合,但这种方式容易丢失细节;要么就是使用那种功能全面的“统一架构模型”,不过这种模型训练成本极高,需要海量的数据来喂养,而且效果也未必尽如人意。

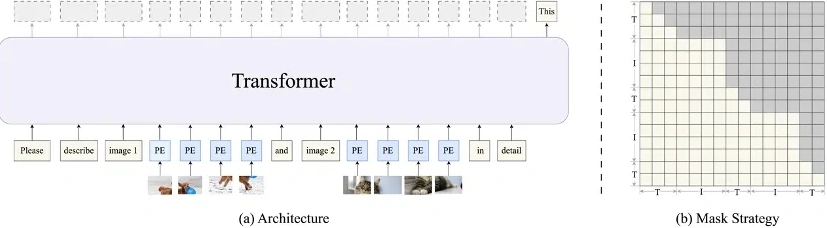

而HaploVL的出现,正是为了解决这些痛点。它采用了一种独特的单Transformer架构,能够动态地将文字和图片信息进行融合。这样一来,文字就如同“雷达”一般,能够对图像中的各种细节进行全面扫描,确保不会遗漏任何关键信息。而且,它还不像其他模型那样需要海量的数据来训练,既节省成本又高效。

HaploVL的架构堪称其秘密武器。它首先将图片和文字转化为AI能够理解的语言,然后在前端设置了一个“预解码器”,也就是视觉知识引擎。这个引擎就像“雷达”一样,能够扫描图像,捕捉细节,还能分析不同图像之间的关系。经过预解码器的处理后,信息再传递给“后解码器”,也就是语言生成引擎。这个引擎非常厉害,它能够像人类一样,用自然流畅的语言将图像信息描述出来。

HaploVL还有一个“独门秘籍”,那就是它的两阶段训练方法。首先进行预训练,为模型打下坚实的基础;然后再针对特定任务进行微调,使其在特定领域更加擅长。这样一来,HaploVL既具备了广泛的知识,又能在特定任务上表现出色,堪称“通才”与“专才”的完美结合。

经过一系列的测试,HaploVL的表现令人瞩目,尤其在需要精准视觉理解的细粒度任务上更是表现出色。比如让它识别图像中的高亮区域,并用自然语言进行描述,它都能轻松完成。这意味着在自动驾驶、智能安防等领域,HaploVL能够帮助系统更精准地感知环境,从而做出更明智的决策。以后开车,再也不用担心AI看不清路上的小障碍物啦!

感兴趣的小伙伴们可以点击链接深入了解:https://github.com/Tencent/HaploVLM。想了解更多AI创作软件工具,还可以关注AI人工智能网站——AITOP100平台的AI工具集。