在人工智能领域中,创新与技术的发展是推动其不断前行的两大驱动力。近年来,随着人工智能技术的飞速发展,大模型(Large Language Models,简称LLM)在影视资讯创作中的应用日益增多,它们在模仿人类写作风格、生成创意内容等方面展现出了巨大的潜力。然而,随之而来的还有一系列挑战,其中之一便是所谓的“幻觉”问题。

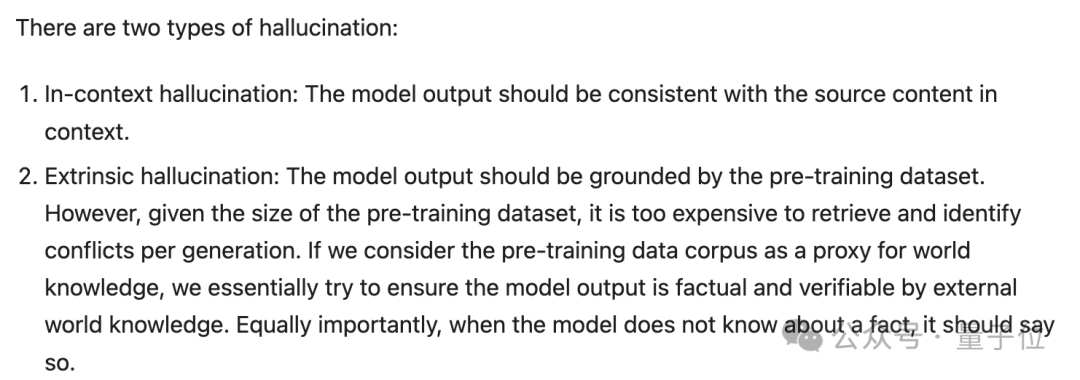

幻觉问题主要分为两种类型:上下文内幻觉和外在幻觉。上下文内幻觉指的是模型输出的内容与给定的上下文不一致,而外在幻觉则是指模型生成的内容与现实世界知识不符。例如,当一个模型被要求续写一个剧本时,如果它生成的情节与原剧本的设定或角色性格完全不符,就可能产生了上下文内幻觉;而如果它生成的情节在现实世界中根本不可能发生,就可能产生了外在幻觉。

为了解决这一问题,科学家们提出了多种方法。首先,通过改进预训练和微调阶段,可以减少模型生成幻觉内容的风险。预训练数据集的质量和多样性直接影响模型的输出质量,因此,确保数据集的时效性和准确性至关重要。此外,微调过程中,通过监督学习和强化学习等技术,可以使模型更好地适应特定的任务和领域。

科学家翁荔在其最新的博客中,深入探讨了LLM的外在幻觉问题,并提出了Agent公式:Agent = 大模型 + 记忆 + 主动规划 + 工具使用。这一公式强调了除了大模型本身,记忆、规划和工具使用也是构成智能Agent的关键要素。翁荔的研究不仅为理解LLM的幻觉问题提供了新的视角,也为未来的模型设计和应用指明了方向。

在幻觉检测方面,研究者们提出了多种评估方法,如检索增强评估、基于采样的检测等,这些方法可以帮助我们更准确地识别和量化模型的幻觉现象。同时,为了抵抗幻觉,研究者们也提出了一系列方法,包括从外部知识库检索信息、特殊的采样方法、对齐微调等。

在影视资讯创作中,LLM的应用前景广阔,但同时也面临着诸多挑战。通过不断优化模型的训练和应用方法,我们可以更好地利用这些强大的工具,创作出既具有创意又符合现实逻辑的高质量影视资讯。随着技术的不断进步,我们有理由相信,LLM将在人工智能领域中扮演越来越重要的角色。