走进现代大学的图书馆,你会看到一幅熟悉的景象:学生们头戴耳机,手捧咖啡,电脑屏幕上打开的AI工具页面几乎成了他们的新标配。

他们热衷于利用ChatGPT这样的AI工具来辅助完成作业,这却让教师们感到头疼不已,因为这些工具的使用让作弊行为变得难以控制。

人工智能技术能够迅速根据一个提示生成整篇论文或研究报告,而且完全免费。面对这种情况,教育工作者们迫切需要找到有效的解决方案来应对这一挑战。

据《每日邮报》2023年1月30日的报道,澳大利亚新南威尔士大学(UNSW)的一名学生因使用ChatGPT自动生成论文而被抓,这在澳大利亚尚属例。

UNSW的人工智能教授Toby Walsh指出,众多高校正在探索如何有效防止学生利用AI技术进行作弊。作为回应,新南威尔士州、昆士兰州和塔斯马尼亚州的高校已经开始封锁校园网络对ChatGPT的访问。

然而,Walsh教授认为,仅仅封锁网络访问是远远不够的,因为学生们总有办法通过代理服务器绕过这些限制。

“要想彻底杜绝作弊,唯一的办法就是将学生置于一个完全没有网络的环境中,只给他们提供纸和笔。”

CDT的调查显示,有59%的中学教师确信学生使用了AI技术来辅助学业,这一比例较上一学年上升了17个百分点。

依靠教师和学校的监督来避免AI工具的诱惑似乎并不现实,问题的解决需要从源头着手——即让AI企业参与进来,共同打击“AI枪手”。

据悉,OpenAI已经开发出了一种能够高精度识别ChatGPT生成文本的工具,但尚未对外发布。

ChatGPT的生成原理是依据输入内容预测句子中接下来可能出现的token。OpenAI正在讨论的反作弊工具将对token的选择方式进行微调,从而留下一种称为“文本水印”的模式。

这种水印虽然肉眼无法察觉,但可以通过OpenAI的检测技术发现。该检测器能够提供文档是否由ChatGPT编写的可能性评分。

内部文件显示,当ChatGPT生成大量文本时,水印的检测准确率可以达到99.9%。

尽管准确率极高,但OpenAI的员工担心,通过一些简单的技术手段,如水印的文本进行翻译再回译,或者在文本中添加表情号后手动删除,就可以轻易绕过这一检测。

此外,公司内部还面临着一个棘手的问题:谁可以使用这个检测工具。如果只有少数人能够使用,那么这个工具的实际效用将大打折扣;如果太多人获得访问权限,又可能会有人试图破解水印技术。

OpenAI的员工还讨论了是否应该直接向教育工作者或外部公司提供这个检测器,以帮助学校识别由人工智能撰写的论文和抄袭作品。

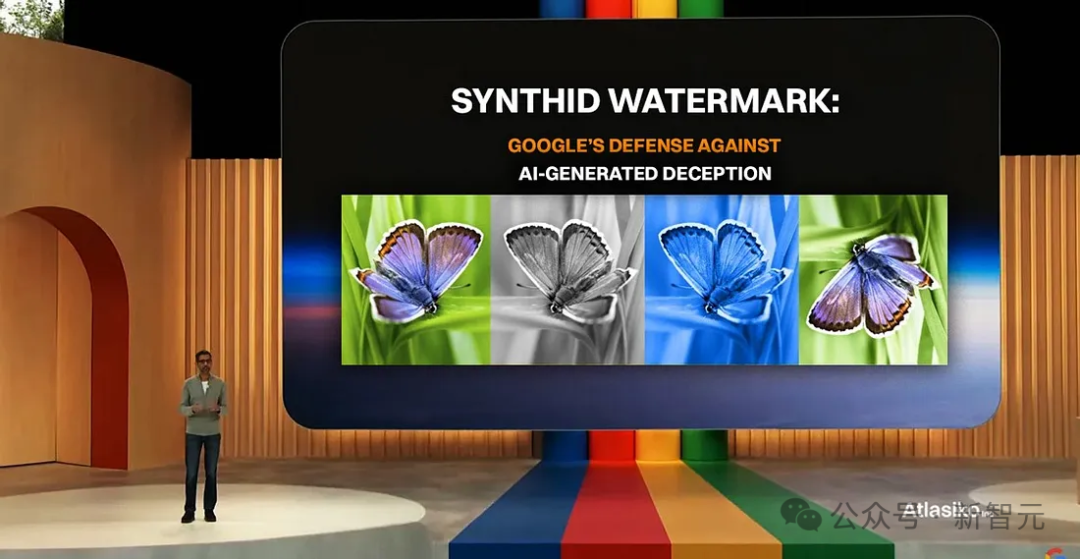

谷歌也开发了一种名为SynthID的水印工具,用以检测Gemini AI生成的文本,目前正处于Beta测试阶段,尚未广泛使用。

OpenAI还有一个工具,可以确定图像是否是使用文本到图像生成器DALL-E 3创建的,该工具已于去年春天发布用于测试。

据知情人士透露,OpenAI更倾向于开发音频和视频水印,因为其潜在的危害更为严重,尤其是在美国繁忙的选举年。

早在2023年1月,OpenAI就发布了一种算法,旨在检测多个AI模型编写的文本,但其成功率仅为26%,七个月后便被撤回。

其他公司和研究人员也开发了一些工具来检测人工智能创建的文本,但这些工具有时无法检测由高级大语言模型编写的文本,准确率较低,可能产生误报。

教育工作者人工智能顾问Mike Kentz表示,起初学生们确实被震慑到了,以为老师们已经掌握了一种方法,可以确定他们是否使用了人工智能代写。

但到了年底,学生们慢慢发现,老师们似乎并没有掌握这种方法。

一些教师鼓励学生使用AI来帮助研究或提供想法反馈,但问题在于,当学生使用像ChatGPT这样的应用程序来完成所有工作时,他们甚至不会去检查自己提交的作业。

犹他大学政治学教授Josh McCrain给学生布置了一份写作作业,作业中插入了难以辨认的小文字,提到了与作业无关的蝙蝠侠。

如果学生将作业复制并粘贴到人工智能中,作业提示内容就会被合并,导致“蝙蝠侠”出现在作业内容中。

结果,少数学生提交了一篇关于蝙蝠侠的论文。

McCrain教授正在调整写作作业,更多地关注人工智能不太熟悉的时事,并恳求学生不要将他们的工作外包给人工智能。

“这就是我试图向学生们强调的:你需要自己学习这些东西。”McCrain教授说。

有关水印工具的讨论早在OpenAI于2022年11月推出ChatGPT之前就已经开始。

它是由计算机科学教授Scott Aaronson开发的,过去两年他在得克萨斯大学休假期间一直在OpenAI从事安全工作。

2023年初,OpenAI联合创始人之一John Schulman在一份共享的Google文档中概述了该工具的优缺点。

OpenAI高管随后决定,在采取进一步行动之前,他们将征求一系列人士的意见。

在接下来的一年半时间里,OpenAI高管反复讨论,并寻求新数据集优化算法,犹豫是否发布该技术。

内部文件显示,2023年4月,OpenAI委托进行了一项调查,结果显示,世界范围的人们以四比一的比例支持人工智能检测工具的想法。

同月,OpenAI对ChatGPT用户进行了调查,发现69%的人认为作弊检测技术会导致使AI技术错误指控。

近30%的人表示,如果ChatGPT部署了水印功能,而竞争对手没有部署水印,他们会减少使用。

另外,OpenAI内部还有一种反对的声音是反作弊工具可能会损害ChatGPT的写作质量。

知情人士称,OpenAI今年早些时候进行了一项测试,发现文本水印不会降低输出质量。

6月初,OpenAI高级员工和研究人员再次聚会讨论该项目。该组织一致认为水印技术效果良好,但去年的ChatGPT用户调查结果仍然是一个头疼的问题。

内部文件显示,OpenAI需要在今年秋天之前制定一项计划,围绕AI透明度以及相关潜在新法律来左右公众舆论——

“如果做不到这一点,我们就有可能失去负责任企业的信誉。”