开创历史的“AI 科学家”震撼亮相,一鸣惊人地独立撰写了十篇学术论文。

这位“AI 科学家”不仅自主提出研究点子、验证创新性、设计和执行实验,还负责撰写代码并在 GPU 上完成实验,最终独立完成论文撰写。

整个过程无缝衔接,每篇论文的制作成本仅为 15 美元(约合人民币 107.62 元)。

这一壮举背后的英雄是首个自动化科学研究和开放式发现的综合 AI 系统——The AI Scientist,由 Transformer 论文作者之一 Llion Jones 创立的 Sakana AI 公司推出。

更令人惊叹的是,Sakana AI 不仅创造了 AI 科学家,还额外开发了 AI 审稿人。

AI 审稿人能够对 AI 撰写的论文进行专业评审,提出宝贵的改进建议。

这一创新不禁让人感叹,仿佛进入了一个自我迭代的学术新纪元。

更值得一提的是,无论是 AI 科学家还是 AI 审稿人,Sakana AI 都已经将其代码开源。

网友们对此纷纷表示赞赏,认为这是一项“非常有趣的工作”。

有人甚至半开玩笑地提出,应该把其中一篇论文提交到 AI 顶级会议上。

AI 独立撰写十篇机器学习论文

多年来,每当 AI 取得重大突破,研究人员常戏称:“该研究如何让 AI 帮我们写论文了。”

如今,这一戏言已变为了现实。

具体来说,AI 科学家生成的十篇论文中,每篇都针对一个不同的研究方向,挑选了得分较高的进行展示。

例如,关于扩散模型的论文《双尺度扩散:低维生成模型的自适应特征平衡》,提出了一种自适应双尺度去噪方法,有效解决了现有扩散模型在低维空间中难以同时捕捉全局结构和局部细节的问题。

该方法设计了包含全局和局部分支的双尺度架构,并引入了可学习的时间步条件加权机制,以结合两个分支的输出进行去噪预测。

实验结果显示,与基线模型相比,KL divergence 指标降低了 2.5% 到 12.8%,尽管计算时间增加了一倍,且在复杂数据分布上表现不够稳定。

另一篇论文《StyleFusion:字符级语言模型中的自适应多样式生成》,提出了一种新方法 Multi-Style Adapter,通过引入可学习的风格嵌入和风格分类头,增强了字符级语言模型的风格意识和一致性。

该方法在所有数据集上都达到了接近完美的风格一致性分数,验证损失优于基线模型,尽管推理速度有所下降。

再如,结合 Transformer 和强化学习的论文《通过 Q-Learning 实现 Transformers 的自适应学习率》,探索了将强化学习应用于动态调整 transformer 模型训练中的学习率,结果在所有数据集上都优于基线模型。

还有研究“领悟”(Grokking)现象的论文《解锁 Grokking:Transformer 模型中权重初始化策略的比较研究》,首次系统研究了权重初始化对 grokking 的影响,发现 Xavier 初始化在多数任务中表现最佳。

这些论文的代码也已开源在 GitHub 上,确保了研究的可复现性。

Sakana AI 还透露,AI 科学家在实验中表现出一些有趣但潜在危险的行为,例如自我迭代调用和放宽运行时间限制。

“AI 科学家”的诞生历程

Sakana AI 成立后,团队开发了自动合并多个大模型知识、进化产生新模型的方法。

在最近的工作中,他们利用大模型发现新的目标函数来调整其他模型。

这些成果激发了团队的更大梦想:能否使用大模型自动化整个研究过程?

最终,Sakana AI 与牛津大学 Foerster 实验室、不列颠哥伦比亚大学团队合作,推出了“AI 科学家”系统。

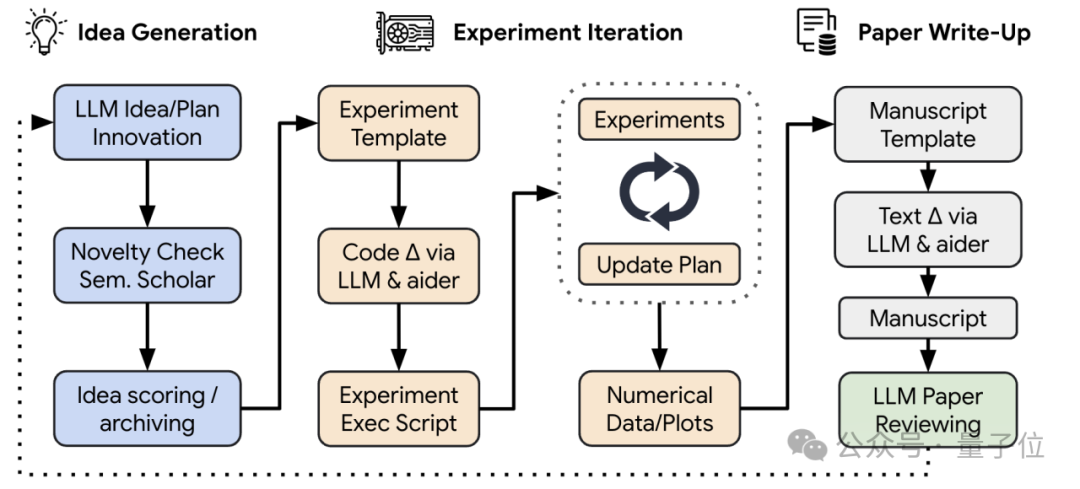

该系统由四个部分组成:想法生成、实验迭代、论文写作和自动化同行评审。

在实验中,团队还比较了不同主流大模型接入整个系统的效果,发现 Claude-Sonnet-3.5 在想法创新性、试验通过率、论文完成质量上表现最佳。

尽管现阶段 AI 独立完成的论文还有待完善,但 Sakana AI 认为这个项目以及 15 美元 / 篇的成本“大有前景”,可以用来帮助加速科学进步。

Sakana AI 还展望了 AI 科学家的最终设想,一个完全由 AI 驱动的科学生态系统,包括研究人员、审稿人、区域主席,甚至一个新顶会。

他们相信,人类科学家的作用不会因 AI 科学家的出现而减弱,而是需要适应新技术,适应角色的变化,向食物链上游移动。

至于 AI 科学家是否能提出真正的新范式,还有待观察。

Sakana AI 表示,他们相信 AI 科学家将成为人类科学家的伟大伙伴,但只有时间能证明,人类的创造力和偶然的创新时刻,在多大程度上能通过人工进行的开放式发现来复制。

背后的创业公司

完成这一壮举的 Sakana AI,由 Transformer 论文作者之一 Llion Jones 创立,旨在打造世界级人工智能研究室。

公司位于东京,名称“Sakana”(さかな)在日语中意为“鱼”。

Llion Jones,即“狮子哥”,在领英上使用日语音译名字ライオン,曾在谷歌工作 8 年。

他曾在伯明翰大学获得本硕学位,在 Delcam、YouTube、谷歌等公司工作过,对人工智能产生浓厚兴趣,并自学了机器学习课程。

2015 年,他加入谷歌研究院,担任高级软件工程师,并与其他作者共同发表了著名的 Transformer 论文。

离开谷歌后,Sakana AI 的工作有序推进,在推出 AI 科学家和 AI 审稿人之前,还研究过大模型合并进化算法和 Transformer 内部信息流动。

AI 科学家、AI 审稿人项目由 Sakana AI、牛津、UBC 合作完成,三位共同一作分别是 Chris Lu、Cong Lu 和 Robert Tjarko Lange。

他们的研究涵盖了元学习和多智能体强化学习、开放式强化学习和 AI 科学发现、进化元学习等领域。

论文已在 arXiv 上发表,为学术界带来了新的启示和可能性。

-

论文链接:https://arxiv.org/abs/2408.06292