在人工智能领域,一项革命性的技术突破正悄然改变着游戏规则。

(传统注意力机制已非必需)

这便是全新登场的 Falcon Mamba 7B 模型,它以一种全新的架构,挑战了现有模型的性能极限。

Falcon Mamba 7B 模型采用了创新的 Mamba 状态空间语言模型架构,这一架构专为处理各类文本生成任务而设计。

该模型摒弃了传统的注意力机制,这一改变显著提升了模型在处理长序列数据时的计算效率,同时保持了内存需求的稳定。它能够以恒定的时间成本生成每个 token,无论上下文的长度如何。

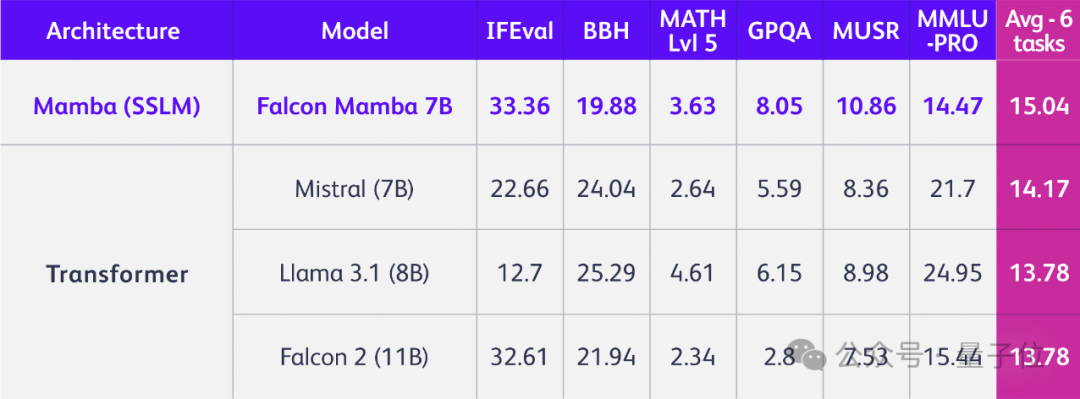

这一技术革新使得 Falcon Mamba 模型在性能上全面超越了基于 Transformer 架构的竞争对手,包括 Llama-3.1(8B)、Mistral(7B)以及 Falcon-2(11B)等。

这一突破性成果由阿联酋阿布扎比技术创新研究所(TII)的专家团队带来,他们是 Falcon 系列模型的开发者。

Falcon 系列共包括四个不同版本的模型,以满足不同用户的需求:基础版、指令微调版、4bit 优化版以及指令微调 4bit 版。

最新的 Falcon Mamba 7B 模型遵循 TII Falcon License 2.0 开放协议,该协议基于 Apache 2.0 协议,为开源社区带来了前所未有的便利。

Falcon Mamba 7B 被誉为全球首个开源的 State Space Language Model(SSLM),其性能在多个维度上超越了现有的开源模型。

Mamba 架构融合了 RNN 和 CNN 的优势,通过引入一种智能选择机制,模型能够根据当前输入有选择地保留或忽略信息,极大提升了文本处理的效率。

此外,Falcon Mamba 7B 设计了一种硬件感知的并行算法,这种算法以递归方式运行,有效避免了 GPU 内存层级间的 IO 访问,进一步提升了计算效率。

架构上的简化也是 Falcon Mamba 7B 的一大亮点,它将 SSM 架构与 Transformer 中的 MLP 块合二为一,简化了模型结构。

这种架构的转变,使得 Falcon 模型能够处理任意长度的序列,而无需增加额外的内存负担,尤其适合在单个 A10 24GB GPU 上运行。

研究团队还探讨了两种不同的序列处理方法:并行预填充方法和顺序填充方法,前者适用于 GPU 并行处理但内存需求较高,后者则适用于 SSM 模型,能够处理任意长度的序列而不受内存限制。

为了确保大规模训练的稳定性,Falcon Mamba 7B 引入了额外的 RMS 标准化层,这一设计简化了 LayerNorm 的计算过程,减少了计算量。

模型的训练使用了高达 5500GT 的数据,这些数据主要来源于 RefedWeb 数据集和公开数据源。训练过程中,模型保持了基本的匀速,而在训练的后期,加入了一小部分高质量的策划数据,以优化模型的最终表现。

在 H100 平台上进行的测试显示,Falcon Mamba 7B 在批大小为 1、提示词长度为 1-130k 的情况下,能够稳定生成新 token,其性能不受文本长度的影响,能够稳定处理长序列,不会出现性能下降。

Falcon Mamba 7B 支持多种 Hugging Face API,包括 AutoModelForCausalLM、pipeline 等,并且推出了一个指令调优版本,通过额外的 50 亿个 token 进行微调,进一步提高了模型的准确性。

现在,最新的 Falcon Mamba 7B 模型可以在 Hugging Face 和 GitHub 上访问,为全球的开发者和研究者提供了强大的工具。