8月16日,中国科学院自动化研究所传来振奋人心的消息,李国齐与徐波领衔的研究团队,携手清华大学、北京大学等高校,从大脑神经元的复杂动力学特性中汲取灵感,提出了一种创新的类脑神经元模型构建方法。这一方法针对传统模型在扩展规模时对计算资源的高消耗问题,提供了有效的解决方案。研究成果已在《自然・计算科学》杂志上发表,为人工智能领域的发展注入了新的活力。

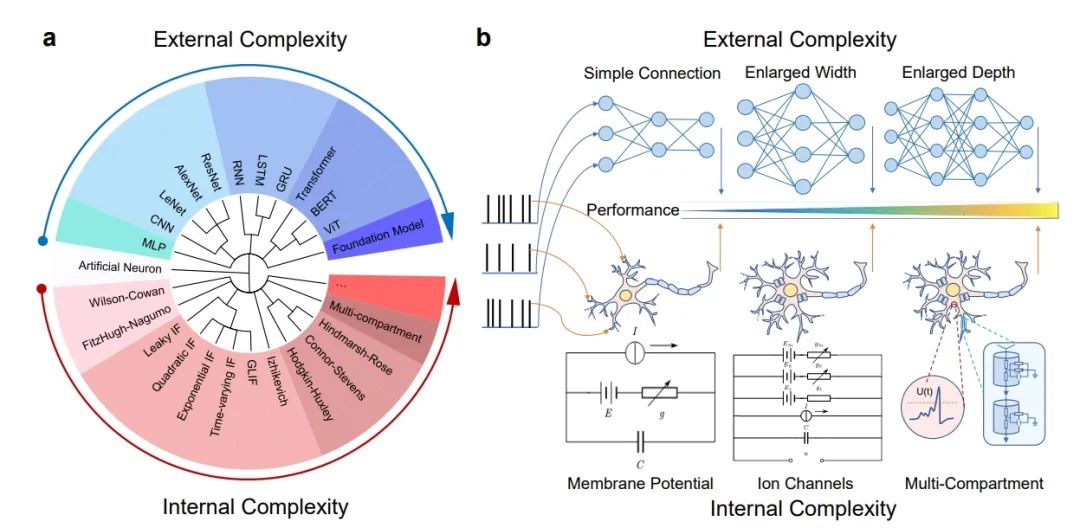

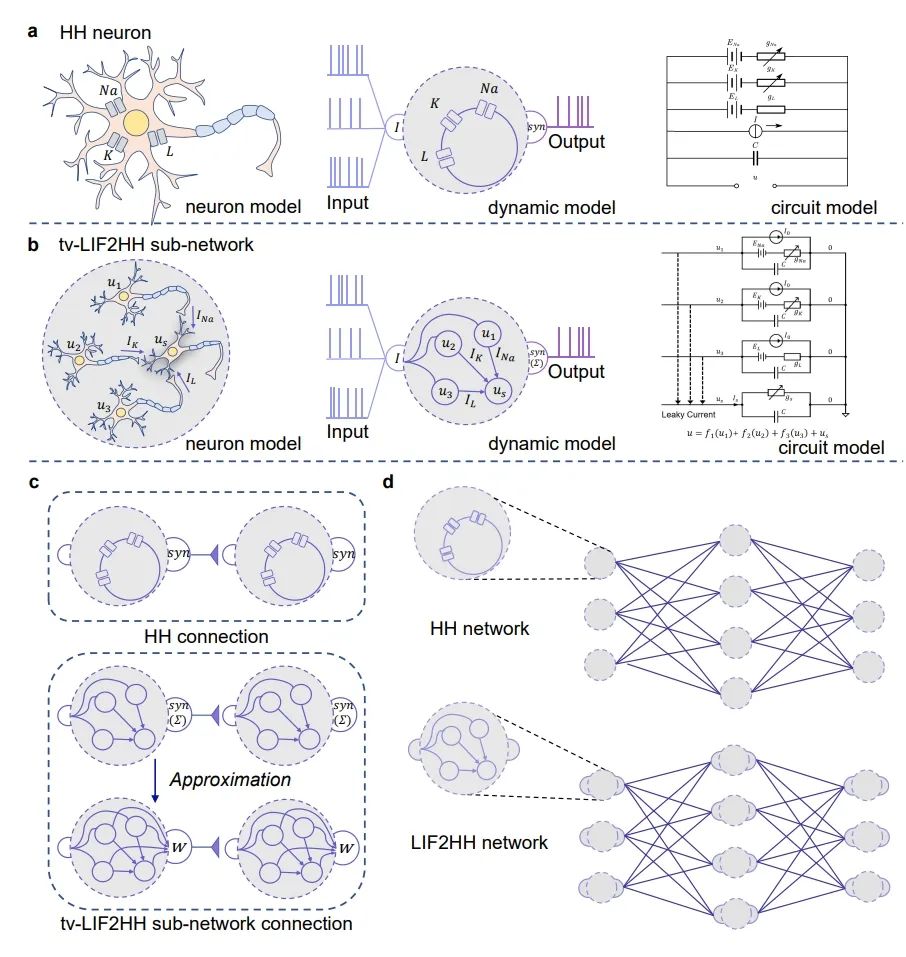

研究团队首先对脉冲神经网络中的LIF模型和HH模型进行了深入分析,发现两者在动力学特性上具有等效性。基于这一发现,研究者们设计了一种微架构,通过提升计算单元的内生复杂性,使得HH网络模型能够模拟更大规模的LIF网络模型,从而在较小的网络架构中实现相似的计算功能。

进一步的研究中,团队将HH模型简化为s-LIF2HH模型,并通过仿真实验验证了其在捕捉复杂动力学行为方面的有效性。实验结果显示,HH网络模型和s-LIF2HH网络模型在表示能力和鲁棒性上具有相似的性能,同时HH网络模型在计算资源消耗上更为高效,显著降低了内存和计算时间的使用,提高了运算效率。

研究团队还利用信息瓶颈理论对实验结果进行了深入解释,为神经科学与人工智能的融合提供了新的方法论和理论支持。这一研究不仅为AI模型的优化和性能提升提供了可行的解决方案,也为实际应用中的快速落地奠定了基础。目前,研究团队正致力于更大规模HH网络的研究,以及探索具有更大内生复杂性的多分支多房室神经元,以期进一步提升大模型的计算效率与任务处理能力。

这项研究的成果,无疑为人工智能的发展开辟了新的道路,预示着未来在智能科技领域的无限可能。

-

Internal complexity in network models: A bridge between artificial intelligence and neuroscience