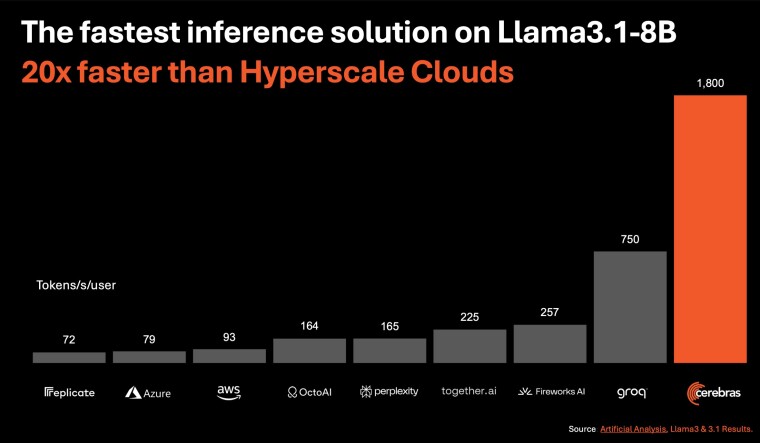

8月28日,Cerebras Systems公司宣布了一项重大突破,推出了被标榜为全球速度最快的AI推理解决方案——Cerebras Inference。这一技术革新为Llama 3.1 8B模型提供了每秒1800个token的处理能力,而对Llama 3.1 70B模型的处理速度也达到了每秒450个token,这一速度是当前市场上基于英伟达GPU的AI推理解决方案的20倍之多。

Cerebras Inference不仅在性能上取得了突破,其定价策略同样具有颠覆性。相较于市场上流行的GPU云服务,Cerebras Inference的定价更为亲民,每百万个token的起价仅为10美分,这为AI工作负载提供了高达100倍的性价比优势。

Cerebras Inference的推出,为AI应用程序开发者提供了构建下一代AI应用的新工具,且无需在速度和成本上做出妥协。该方案基于Cerebras CS-3系统和其Wafer Scale Engine 3(WSE-3)AI处理器,CS-3的内存带宽高达Nvidia H100的7000倍,有效解决了生成式AI在内存带宽上的技术瓶颈。

Cerebras Inference的推出,标志着AI推理解决方案的三个不同层级的服务:免费层为所有注册用户提供了免费的API访问和充足的使用限额;开发者层则为需要灵活无服务器部署的用户提供了一个成本极低的API端点,Llama 3.1 8B和70B模型的定价分别为每百万token 10美分和60美分;企业层则提供了更为全面的服务,包括模型微调、定制服务级别协议和专属支持,企业可以选择通过Cerebras管理的私有云或在客户场所部署Cerebras Inference,以满足持续的工作负载需求。

Cerebras团队表示:“Cerebras Inference以其破纪录的性能、行业领先的定价以及开放的API访问,为大型语言模型(LLM)的开发和部署树立了新的标杆。作为唯一能够同时提供高速训练和推理的解决方案,Cerebras正在为AI领域开辟新的可能性。”

AI技术正以前所未有的速度发展,尽管英伟达目前在AI市场占据领导地位,但Cerebras和Groq等新兴企业的崛起,预示着行业格局可能即将迎来变革。随着市场对更快速、更具成本效益的AI推理解决方案的需求日益增长,这些新兴企业正逐步挑战英伟达的市场地位,尤其是在AI推理领域。