在昨日的官方公众号更新中,面壁智能公司宣布了一项重大突破——开源的 MiniCPM3-4B AI 模型,标志着端侧 AI 技术的新时代已经到来。

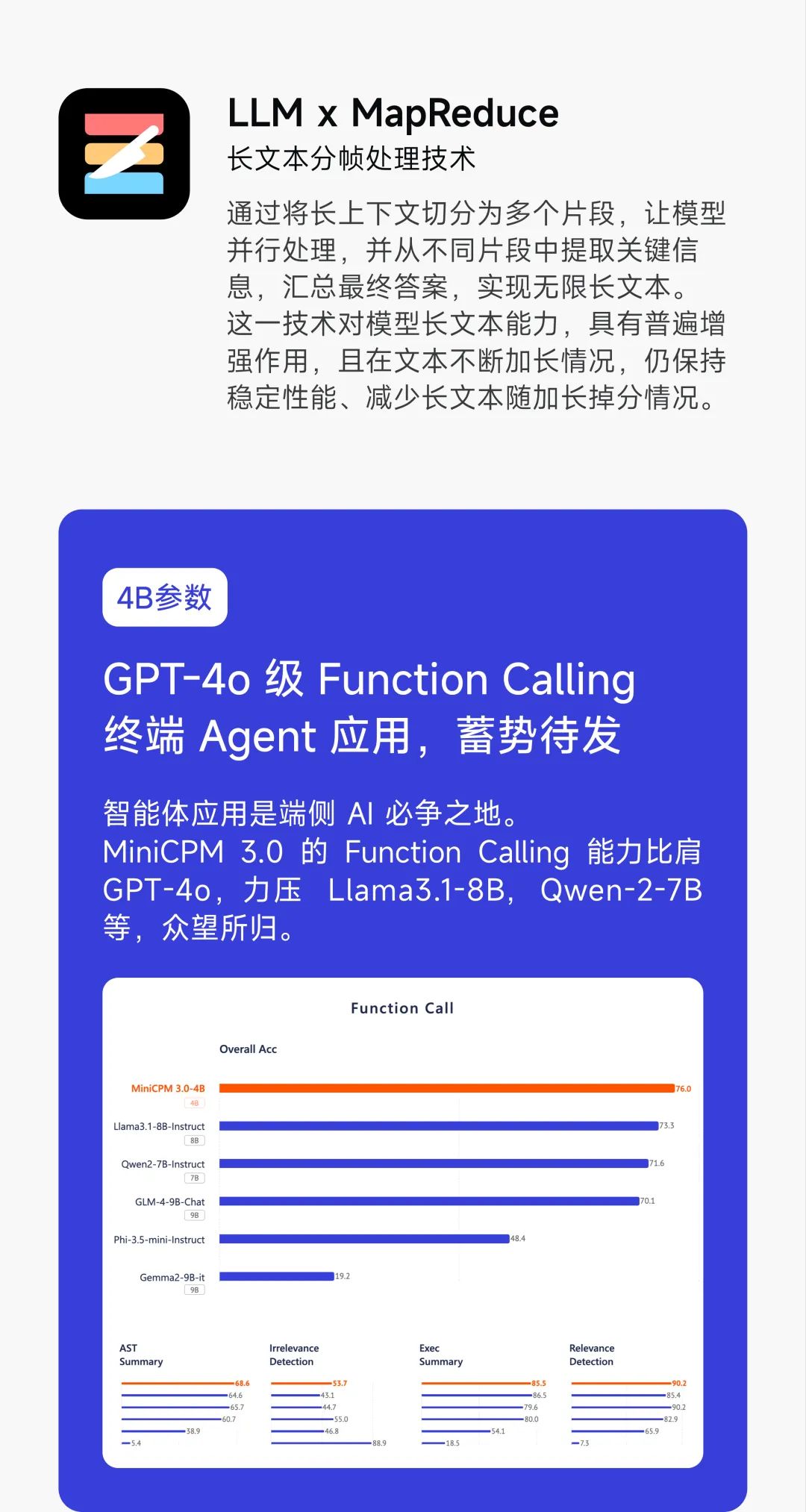

MiniCPM 系列的最新成员,MiniCPM3-4B,以其卓越的性能,成功超越了 Phi-3.5-mini-Instruct 和 GPT-3.5-Turbo-0125,与市场上多款参数在 70 亿至 90 亿之间的 AI 模型相媲美。

与前两代相比,MiniCPM3-4B 展现了更为强大的能力,其应用范围也更为广泛。它不仅支持函数调用,还具备代码解释器的功能,使其在实际应用中更加灵活多变。

以下是 MiniCPM 系列模型结构的演变历程(从 1 到 3 代):

-

词表大小:从 123K 减少到 73K,再维持在 73K

-

模型层数:由 40 层增加至 52 层,最终达到 62 层

隐藏层节点:从 2304 增加到 1536,再扩展到 2560

-

最大长度:从 4k 保持不变,到 4K,最后扩展到 32k

-

系统提示词:不支持 - 不支持 - 支持

-

工具调用和代码解释器:不支持 - 不支持 - 支持

MiniCPM3-4B 拥有 32k 的上下文窗口,这意味着它能够处理更长的文本输入。借助 LLMxMapReduce 技术,该模型能够在不占用过多内存的情况下,理论上处理无限的上下文信息。

面壁智能还推出了 RAG 套件,包括 MiniCPM-Embedding 模型和 MiniCPM-Reranker 模型,以及针对 RAG 场景特别优化的微调版 MiniCPM3-RAG-LoRA 模型。

这些新工具的推出,不仅为 AI 领域的研究者和开发者提供了更多的选择,也为端侧 AI 技术的应用开辟了新的可能性。随着技术的不断进步,我们可以期待在未来看到更多令人兴奋的创新和应用。