自OpenAI的o1模型发布以来,其在lmsys社区的投票中迅速攀升至榜首,收获了6000多票的压倒性支持。为了回应公众对o1模型在国际信息学奥林匹克竞赛(IOI)金牌水平的好奇,OpenAI公开了所有在测评中提交的代码,这些代码在模拟的Codeforces编程竞赛中取得了362.14分的高分,超过了金牌门槛。

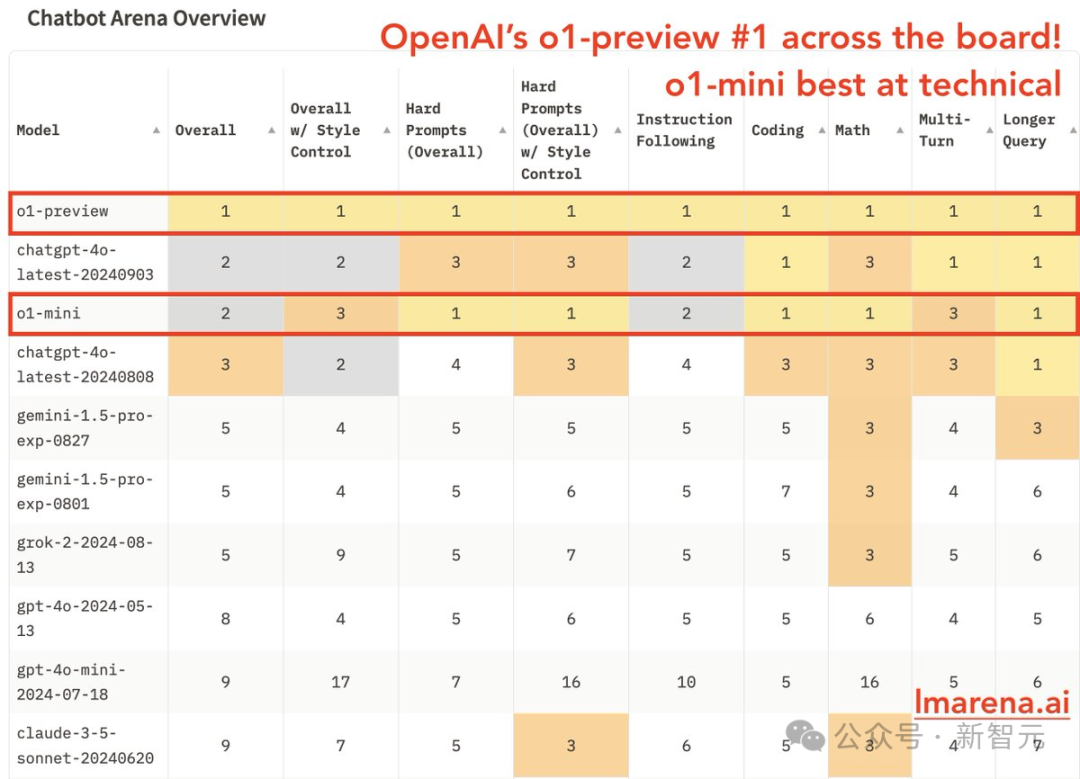

备受瞩目的o1模型在lmsys的测评中,无论是在数学、难题提示还是编码领域,都展现出了卓越的性能,超越了GPT-4o的最新版本。而o1-mini,尽管名称中带有“mini”,但其性能同样不容小觑,在综合排名中与GPT-4o并列第二,同样在难题提示、编码和数学领域取得了领先地位。

lmsys社区官方在推特上表示,这次测试结果是基于6000多社区成员的投票得出的,并称OpenAI的这一进展为“难以置信的里程碑”。为了进一步证明o1模型的实力,lmsys还统计了前25名模型的一对一胜率。结果显示,o1-preview在所有模型中的胜率均超过50%,尤其是在与04-09版GPT-4-Turbo的对决中,胜率达到了惊人的88%。

尽管o1-mini在与o1-preview的对决中胜率为46%,对09-03版GPT-4o的胜率为48%,显示出略逊一筹的实力,但这一表现仍然令人印象深刻。值得注意的是,尽管Grok-2-mini和Claude 3.5 Sonnet的排名较为靠后,但o1-preview对这两个模型的胜率并不高,分别为58%和57%,远低于排名第四的Gemini 1.5 Pro的69%。

在细分领域的排行榜中,尤其是在数学和推理领域,o1-preview和o1-mini的表现更是令人瞩目。它们不仅在数学排行榜上登顶,而且展现出了绝对的领先优势。而排在其后的Claude 3.5 Sonnet、Gemini 1.5 Pro和08-08版ChatGPT-4o的分数均在1275左右,竞争激烈;o1-preview和o1-mini则以1360左右的高分遥遥领先。

o1推理团队的领导者之一William Fedus对这一成绩表示满意,并认为这些数据“很好地用视觉表达了范式转换”。o1模型在STEM学科和通用推理方面的表现确实达到了新的高度,用实际的测评结果回应了外界对AI发展的质疑。

然而,也有人对lmsys的排行榜结果表示质疑。一些人指出,o1模型的推理时间较长,导致回答延时明显,与其他模型存在显著差异。此外,由于lmsys社区的评分完全基于用户的主观评价,因此可能存在“安慰剂效应”。

尽管如此,o1模型在编程竞赛领域的出色表现引起了AI社区的广泛关注。OpenAI决定公开o1模型在Codeforces编程竞赛中提交的所有C++代码和注释,包括6个问题。这些代码的公布,不仅展示了o1模型在编程领域的潜力,也让人们对其未来的发展前景充满期待。

o1模型的核心贡献者Alexander Wei表示,o1模型在编程竞赛中的表现令人惊讶。他曾在9年前参加过IOI竞赛,但从未想过自己会这么快就需要与AI竞争。模型展现出的推理过程的复杂程度令人印象深刻。

博文中提到,虽然o1模型距离人类的顶级表现还有很长的路要走,但我们期待有一天能实现这个目标。这让人想起了AlphaGo的发展轨迹——从水平高超,到能与人类顶级高手不分胜负,再到5-0完全碾压李世石。OpenAI的目标可能是打造一个能在编程领域碾压人类顶级高手的AlphaZero。

Reddit上的网友们对o1模型的未来发展充满期待,他们提醒我们,目前公开的只是o1的预览版,正式版o1即将在一个月内发布。此外,o1基本沿用了GPT-4的架构,让人不禁想象,改换架构后的GPT-5(传说中的猎户座)能达到怎样的高度。