在科技界,微软公司的最新动作引起了广泛关注。根据科技媒体marktechpost在10月18日的报道,微软开源了一个名为bitnet.cpp的框架,这是一个专为在CPU上高效运行1-bit大型语言模型(LLM)而设计的推理框架。

这一创新框架的推出,意味着用户无需依赖GPU即可在本地设备上运行拥有1000亿参数的庞大语言模型,这不仅将运行速度提升了6.17倍,还实现了能耗降低82.2%的惊人成果。

传统上,大型语言模型的运行需要依赖于庞大的GPU基础设施和大量的电力,这不仅使得部署和维护成本居高不下,也使得小型企业和个人用户难以触及这些技术。bitnet.cpp框架的出现,通过降低对硬件的要求,使得更多的用户能够以更低的成本享受到AI技术带来的便利。

bitnet.cpp框架专门针对1-bit LLMs的高效计算进行了优化,包含了能够最大化CPU推理性能的内核。目前,该框架支持ARM和x86 CPU,而微软计划未来将其扩展至NPU、GPU以及移动设备。

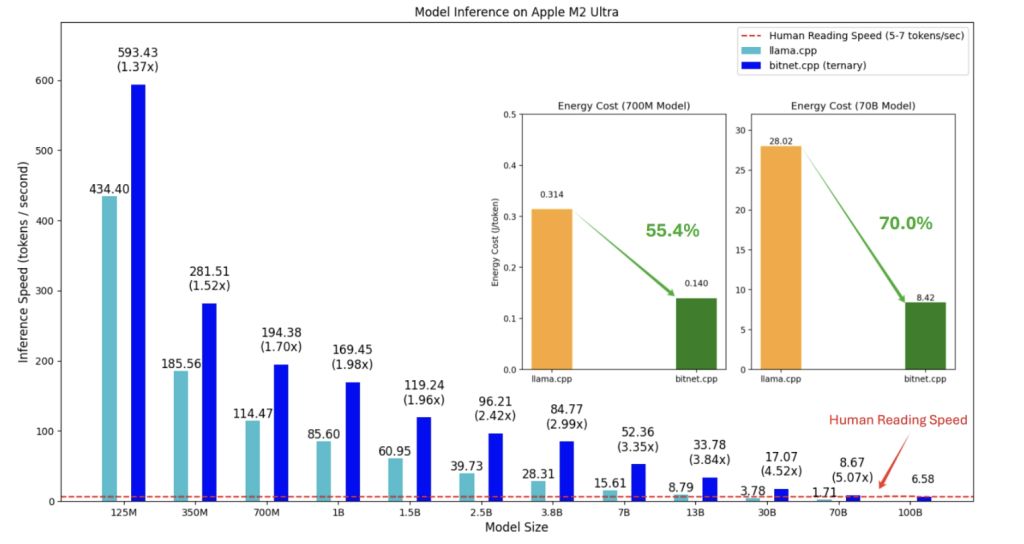

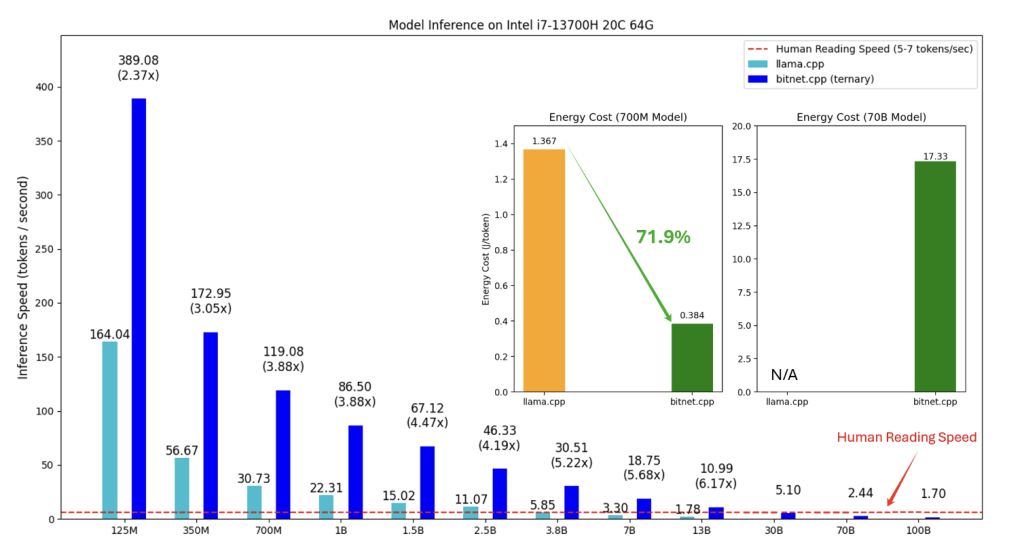

初步测试显示,在ARM CPU上的加速比达到了1.37x至5.07x,而在x86 CPU上则为2.37x至6.17x,能耗的减少范围在55.4%至82.2%之间。

bitnet.cpp的发布,预示着LLMs的计算模式可能会发生根本性的变化,减少对硬件的依赖,为本地大型语言模型(LLLMs)的发展铺平了道路。

用户现在可以在本地运行这些模型,这不仅减少了将数据发送到外部服务器的需求,还增强了数据的隐私保护。微软的“1-bit AI Infra”计划正在推动这些模型在工业领域的应用,而bitnet.cpp在这一过程中扮演了关键角色。

更多详细信息,可以参考以下链接:

-

Microsoft Open-Sources bitnet.cpp: A Super-Efficient 1-bit LLM Inference Framework that Runs Directly on CPUs

-

GitHub