在人工智能领域,智源研究院的最新力作Emu3,以其革命性的多模态能力,引起了业界的广泛关注。这款全新的模型,仅依赖于下一个token的预测,便能轻松驾驭文本、图像和视频的理解和创作,无需依赖复杂的扩散模型或组合方法。Emu3的问世,标志着我们向构建一个统一的多模态世界迈出了坚实的一步。

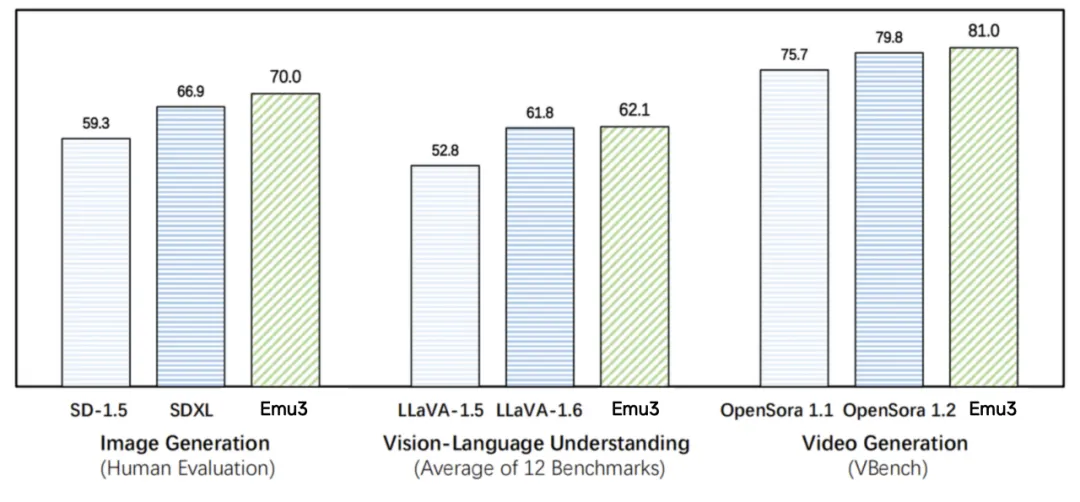

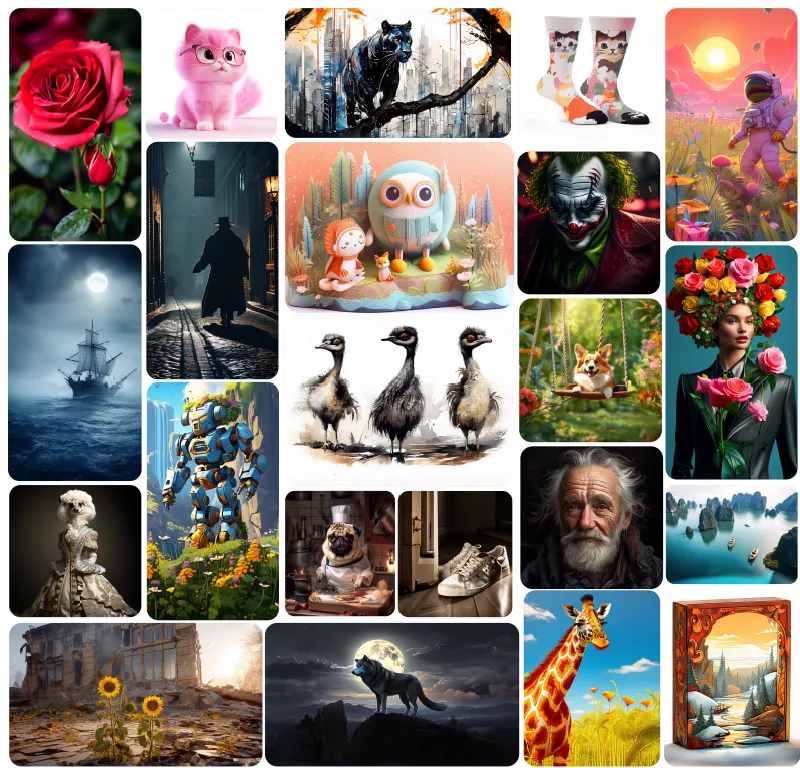

Emu3在图像生成方面的表现尤为出色,它能够根据人类的审美偏好,生成质量上乘的图像,其性能在与SD-1.5和SDXL模型的对比中更胜一筹。在视觉语言理解领域,Emu3同样展现出了卓越的能力,其在12项基准测试中的平均得分超过了LlaVA-1.6。而在视频生成任务上,Emu3在VBench基准测试中的得分也超越了OpenSora 1.2。

Emu3的核心优势在于其强大的视觉tokenizer,它能够将视频和图像转化为离散的token,这些token与文本tokenizer生成的token一同输入模型,使得模型输出的token能够直接转换为文本、图像和视频。这种Any-to-Any的研究范式,为多模态任务提供了一个更加统一和高效的解决方案。

Emu3的研究成果不仅证实了下一个token预测作为一种强大的多模态模型范式,能够实现超越语言的大规模多模态学习,而且在多模态任务中展现出了先进的性能。通过将复杂的多模态设计简化为token,Emu3在大规模训练和推理中释放了巨大的潜力。

目前,Emu3已经将其关键技术和模型开源,以促进全球人工智能社区的进一步发展。感兴趣的开发者和研究人员可以通过以下链接获取更多信息:

-

代码:[https://github.com/baaivision/Emu3](https://github.com/baaivision/Emu3)

-

项目页面:[https://emu.baai.ac.cn/](https://emu.baai.ac.cn/)

-

模型:[https://huggingface.co/collections/BAAI/emu3-66f4e64f70850ff358a2e60f](https://huggingface.co/collections/BAAI/emu3-66f4e64f70850ff358a2e60f)