在人工智能领域,模型的优化和压缩一直是研究的热点。10月27日,继9月份开源Llama 3.2的1B和3B模型后,Meta公司在10月24日宣布了这两个模型的量化版本。这一举措使得模型的体积平均缩小了56%,同时RAM的使用量也减少了41%,而模型的运行速度则提升了2到4倍。更重要的是,这些改进并没有以牺牲性能为代价,反而降低了功耗,使得这些模型能够被更广泛地部署在移动设备上。

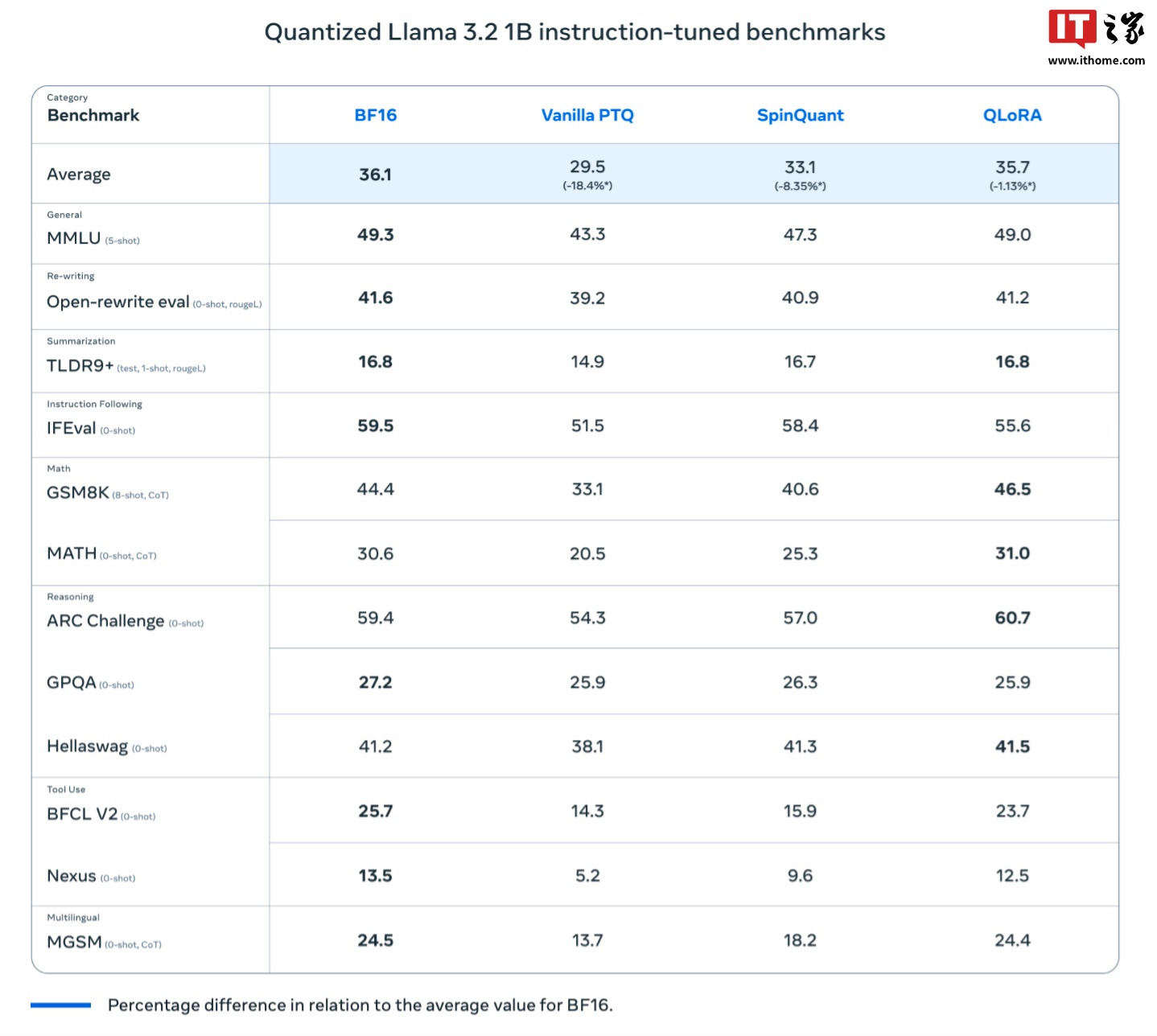

模型量化是一种将浮点数模型转换为定点数模型的技术,它通过减少模型参数的数量来降低模型的复杂度,从而使得模型能够在资源受限的平台上运行。Meta公司在量化Llama 3.2模型时,采用了量化感知训练(Quantization-Aware Training,简称QAT)和后训练量化(SpinQuant)两种方法。QAT方法注重保持模型的准确性,而SpinQuant则更侧重于提高模型的可移植性。

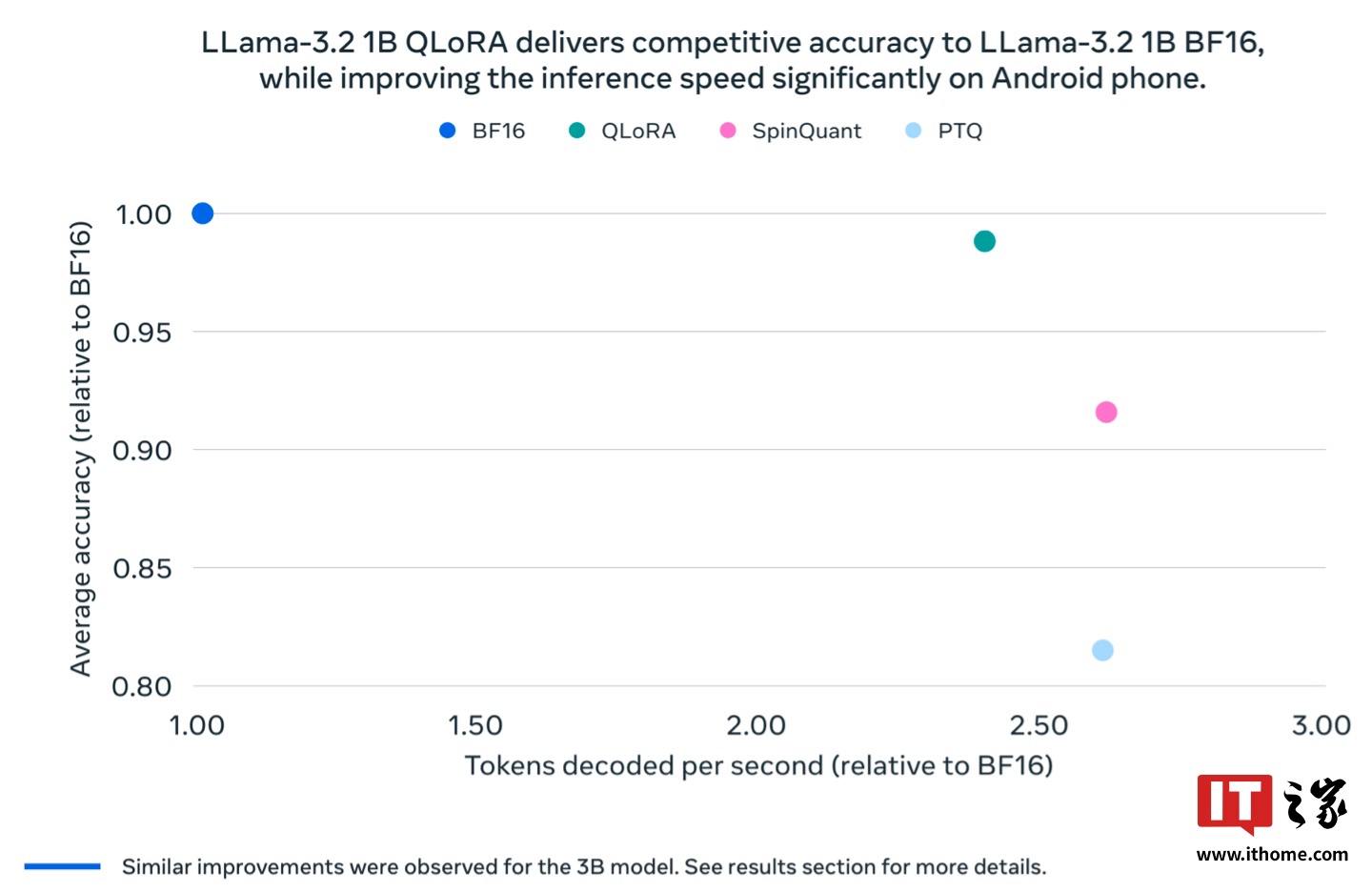

Meta的研究人员为Llama 3.2的1B和3B模型各自开发了两款量化版本,分别为Llama 3.2 1B QLoRA、Llama 3.2 1B SpinQuant、Llama 3.2 3B QLoRA和Llama 3.2 3B SpinQuant。这些量化模型在速度、RAM占用和功耗方面都优于非量化的Llama BF16模型,同时保持了与Llama BF16版本相近的精度。

虽然量化后的Llama 3.2 1B和3B模型的上下文支持能力从原版的12.8万个Token减少到了8000个Token,但Meta的测试结果显示,无论是QLoRA还是SpinQuant版本的基准测试结果都与Llama BF16版本相差无几。

目前,Meta已经在一加12、三星S24+/S22以及苹果iOS设备上测试了这些量化模型,并取得了良好的运行效果。未来,研究人员还计划通过神经处理单元(NPU)进一步提升这些量化模型的性能,以期在移动设备上实现更加高效和节能的人工智能应用。