最新报道,11月19日,阿里通义千问在昨日(11月18日)通过官方博文宣布,经过数月的精心优化和迭代,推出了Qwen2.5-Turbo这一全新的开源AI模型,以满足社区对于更长文本处理能力的需求。

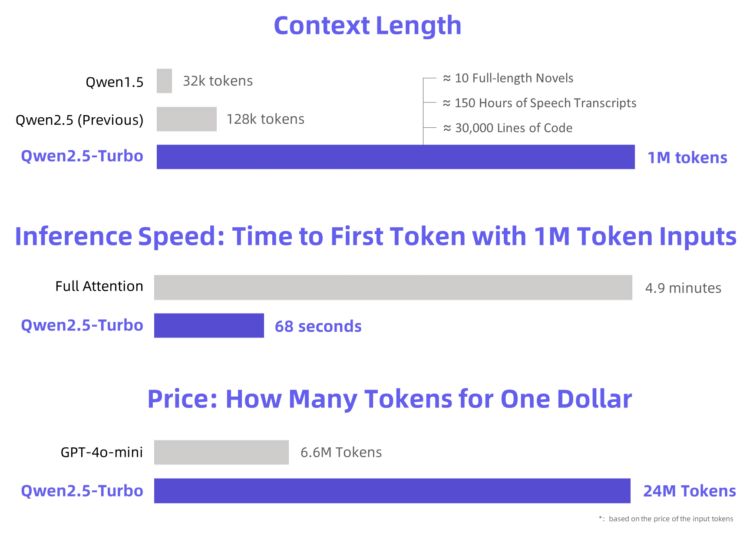

Qwen2.5-Turbo的上下文长度得到了显著提升,从原先的12.8万个扩展至100万个tokens,这一扩展相当于能够处理约100万英语单词或150万汉字的文本量,足以容纳10部长篇小说、150小时的演讲内容或30000行代码。

上下文长度(Context Length)在自然语言处理(NLP)领域中,指的是大型语言模型(LLM)在单次处理中能够考虑和生成的最大文本长度。

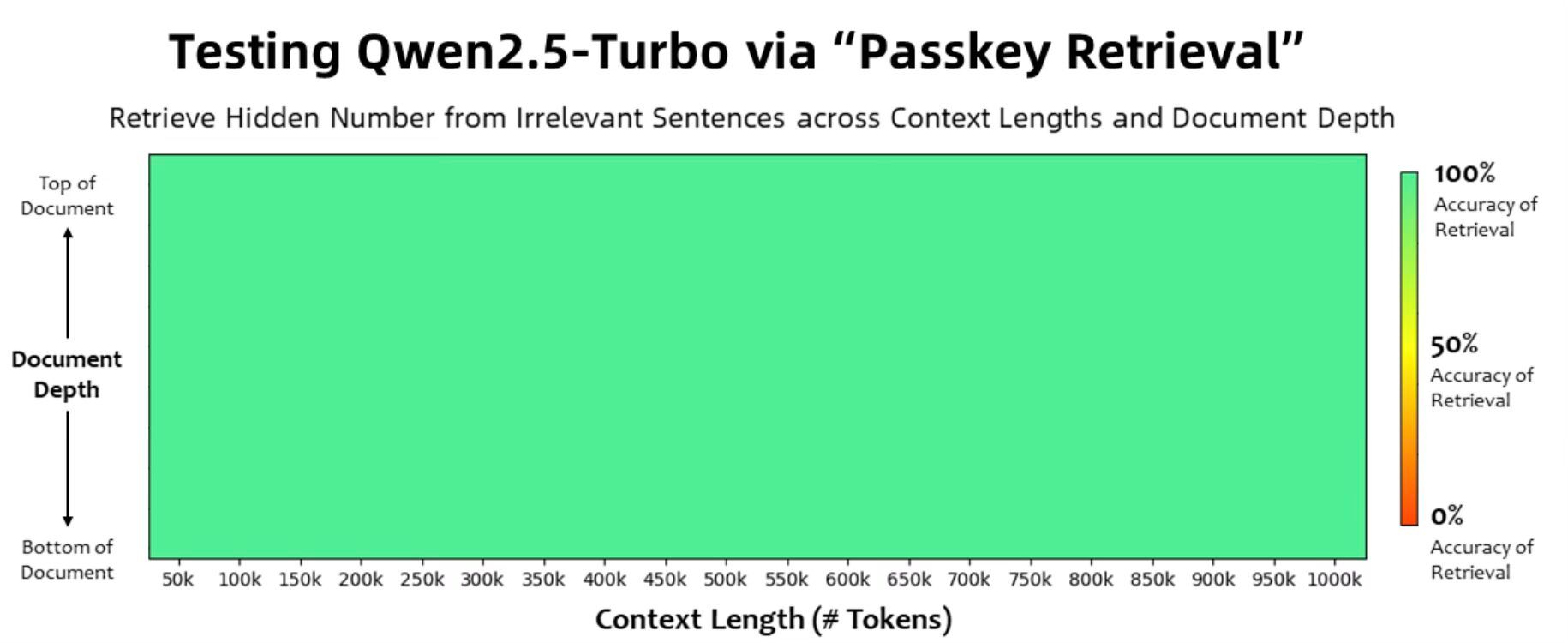

Qwen2.5-Turbo在1M-token的Passkey检索任务中达到了完美的100%准确率,并且在RULER长文本评估中得分高达93.1,超越了GPT-4和GLM4-9B-1M等竞争对手。

为了提升处理效率,团队引入了稀疏注意力机制,将处理100万tokens至输出第一个tokens的时间从4.9分钟大幅缩短至68秒,速度提升了4.3倍,使得Qwen2.5-Turbo在处理长文本时更加迅速和高效。

在成本控制方面,Qwen2.5-Turbo展现出了极高的经济性,每处理一百万tokens的成本仅为0.3元,能够处理的token数量是GPT-4o-mini的3.6倍,这使得Qwen2.5-Turbo成为了一个既高效又经济的长上下文处理解决方案。

尽管Qwen2.5-Turbo在多个基准测试中表现卓越,团队也清醒地认识到,在实际应用场景中,长序列任务的表现可能存在波动,且大型模型的推理成本仍有优化空间。

团队表示,他们将持续致力于提升模型的人类偏好理解能力、推理效率,并探索开发更加强大的长上下文模型。

以下是相关参考链接:

-

Qwen2.5-Turbo官方介绍

-

API文档

在线演示