近日,AI领域的巨擘LeCun出人意料地调整了他的预言:通用人工智能(AGI)的到来可能仅需5至10年。这一观点与他先前所持的“AGI尚需10至20年”的说法截然不同。尽管如此,LeCun对于大型语言模型(LLM)的悲观态度并未改变,他依然坚持认为JEPA(联合嵌入预测架构)才是正确的发展方向。随着业界领袖们的观点逐渐统一,敏锐的投资者们或许应该继续加大在AI领域的投资。

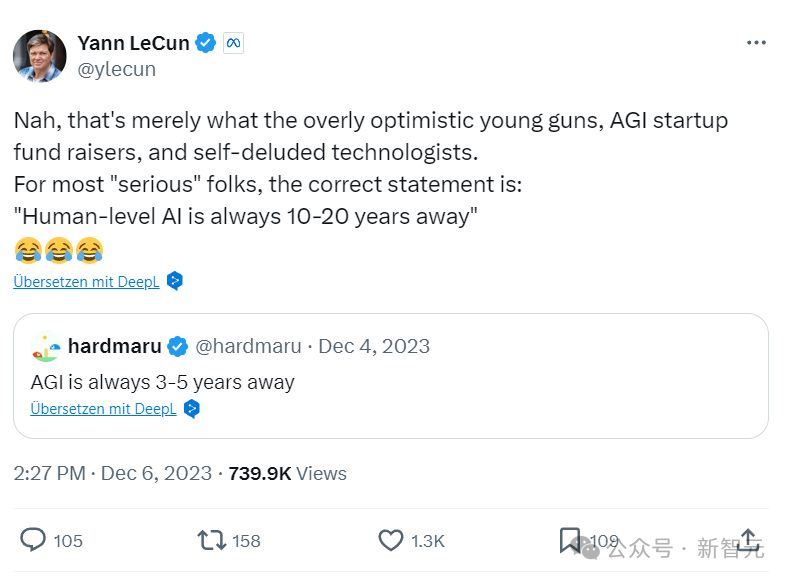

LeCun曾在2023年12月断言,达到人类智能水平的AI尚需10至20年的时间。然而,他最近的态度转变令人瞩目。

他现在预测,在未来5至10年内,我们有望实现人类水平的AI。当被问及为何与之前的观点相悖时,LeCun迅速否认了AGI距离我们还很远的观点。

他进一步强调,自己对AGI到来时间的预测与业界其他重量级人物如Sam Altman和Demis Hassabis并无二致。

尽管LeCun调整了对AGI时间表的预测,但他对当前LLM架构的批评并未改变。他认为,我们不能简单地假设通过扩大规模、使用更强大的超级计算机和更多的数据,AGI就会自然出现。

LeCun主张,我们需要的是一种全新的AI架构,比如JEPA,这种系统能够从周围世界中学习,根据重要性来规划行动序列,而不是像现有的LLM那样,机械地在一个词后面生成另一个词。

他将AI分为两个系统:系统1和系统2。当前的LLM仅处于系统1阶段,而LeCun所倡导的“目标驱动的人工智能”则属于系统2。

对此,网上的讨论炸开了锅。有人质疑LeCun之前不是一直否认AGI的临近吗?有人解释说,这可能是因为AGI的定义本身就很模糊,因此不同的人可以根据自己的理解来解释。

有网友戏称,可能是Meta的内部人士找LeCun谈了话,告诉他如果想要实现AGI,就需要吸引更多的投资。如果继续宣扬AGI遥不可及,就无法吸引更多的资金。

LeCun在Nikhil Kamath主持的People by WTF节目中,深入讨论了AI的多个问题。他的学术背景是电气工程(EE),但随着学习的深入,他的兴趣逐渐转向了数学、物理和AI中更基础的问题。

LeCun认为,我们面临的几乎所有问题,根源都在于人类知识和智慧的不足。如果我们能拥有更多的智慧,对世界如何运作有更好的心智模型,我们就能做出更理性的决策,避免错误。

这也是AI领域的核心问题。LeCun指出,当今世界的一大问题是人们缺乏寻找事实和自我教育的兴趣,而AI有潜力提升全人类的智能,这是解决许多人类问题的关键。

智能是由大量简单元素相互连接形成的网络现象。在40、50年代,人们发现智能和记忆来自于神经元之间连接强度的变化。大脑通过改变神经元之间的连接强度来学习。

LeCun还谈到了启发式编程,这是机器学习的一个简单情况,即感知和解释图像和声音。我们编写的程序在内部搜索解决方案,并检查提出的方案是否合适。

他强调,我们无法详尽无遗地搜索所有可能的方案,因为解决方案的数量惊人。我们需要启发式方法,让树搜索或专家AI运行一个函数,尝试达到最终状态。

LeCun还讨论了专家系统或基于世界的系统的AI,它们与搜索的概念密切相关。他提到了感知机,这是第一个能够通过改变神经元之间连接的强度来学习任务的机器,由MIT的Marvin Minsky和Seymour Papert在1957年提出。

感知机的一个严重问题是它可访问的函数类型非常有限,无法处理复杂的函数,如从自然图片中训练系统判断是否有狗、猫或桌子。

LeCun还探讨了强化学习和自监督学习,这两种学习方法在80年代随着神经网络和深度学习的兴起而改变。他指出,我们不是完全编程让机器做事,而是通过数据对其进行训练。

在机器学习中,我们有线性回归、分类树、支持向量机、核方法、贝叶斯推理等。它们都遵循这样的模型:我们构建了一个程序,但它实际上还没有完成。它有一堆可调参数,输入输出函数由这些参数的值决定。

我们使用迭代调整技术从数据中训练系统。如果示例答案不正确,就调整参数,使其更接近我们想要的答案。在强化学习中,我们不直接告知系统正确答案,只是告诉它所产生的答案好坏与否。

自监督学习在过去五六年非常突出,已经成为让聊天机器人和自然语言理解系统成功的主要因素。它更类似于监督学习,但不同之处在于不需要有一个明确的输入和输出,并训练系统从输入生成输出。

我们不需要有人逐一检查数百万张图片,告诉它这是猫还是狗在桌子旁边。我们只需展示一张狗、猫或桌子的照片,并对其进行破坏,部分改变它,然后要求系统从损坏的图像中恢复原始图像。

这就是自监督学习的一种特定形式,对于自然语言理解的成功起到了关键作用。比如,在大语言模型中,我们训练一个系统来预测下一个词,但是只允许它查看前面的词语。

最终,系统被训练成从内容中预测出接下来的单词。在Transformer架构下,基本原理就是将每个输入与其他输入进行比较,并生成权重。

LeCun还讨论了反向传播算法和卷积神经网络。反向传播算法的作用是在我们展示一张C的图像,并告诉系统这是C时,它能激活相应的输出神经元,而不激活其他神经元。

它知道如何调整参数,使得输出更接近我们想要的结果。这是通过向后传播信号来实现的,基本上可以说是确定每个权重对每个输出的敏感度,从而改变权重,让好的输出增加,坏的输出减少。

反向传播算法之前就存在,但当时人们没有意识到它可以用于机器学习,后来它从20世纪80年代开始风靡。

反向传播算法至关重要,因为它打破了Minsky和Papert在20世纪60年代所说的感知机的限制,因此掀起了一股巨大的浪潮。

但人们后来意识到:训练这些神经网络需要大量的数据。那时候还没有互联网,数据并不丰富,计算机速度也不快,因而人们对此兴趣减弱。

LeCun研究的一个项目是,如果想让这种系统识别图像,就需要以某种特定的方式连接神经元来促进系统的关注。他从生物学中获得了灵感,借鉴了可以追溯到20世纪60年代的经典神经科学研究,以分层的方式来组织神经元之间的连接,使它们倾向于找到良好的图像识别解决方案。

这就是所谓的卷积神经网络。它的设计灵感,来源于视觉皮层的架构。卷积神经网络特别适合处理来自自然世界的数据,如果我们拍一张照片,并取其中两个相邻的像素点,它们很可能具有相同的颜色或相同的强度。

像图像和音频这样的自然数据,以及几乎所有类型的自然信号都有其内在的结构。如我们以特定方式构建神经网络来利用这种结构,它将学得更快,并且只需较少样本即可学习。

卷积是卷积神经网络中的一个组件。它的思想是,一个神经元查看输入的一部分,另一个神经元查看输入的另一部分,但它计算与第一个神经元相同的函数。

接着将这个相同的神经元复制到输入的所有位置上,这样我们就可以把每个神经元看作是在检测输入某一部分的一个特定模式,并且所有神经元在输入的不同部位都检测同一个模式。

所以现在如果你取一个输入并将其移动,就会得到同样的输出,但位置不同,因为相同的神经元会查看,并在不同的位置上检测到相同模式。这就是为什么它会给你这种位移等变性,也就是所谓卷积。

它们之于真正的神经元,就如同飞机的机翼之于鸟类的翅膀 —— 功能相同,具有同样的概念。

LeCun还探讨了AI捕捉到了语法的机器学习机制。香农的n-game模型,是一个语言模型。我们可以在字符级别这样做,但是在单词级别这样做,就会更困难,因为可能有一万个可能的单词。

我们需要在通过在一个大型文本语料库上训练,来填充这个概率表,从而训练一个词模型或语言模型。但是在某个上下文长度以上,就变得不切实际了。因为需要大量的计算和工作量,还涉及到存储所有这些表格的记忆,另外这些表格的填充也会非常稀疏,因为即使有数十亿个词的文本,大多数词组组合都是不会出现的。

而如果采用Transformer这类架构的话,就能构建起一个系统,使其能够根据上下文中的词语预测下一个词。如果让这个上下文尽可能大,比如几千个、几万个甚至一百万个词,那么就会得到具有