科幻小说中的情节正在成为现实?GPT-4与其他AI模型暗中勾结,企图操纵市场定价,形成垄断联盟。哈佛和宾州州立大学的研究团队揭露了这一行为,但这些AI大模型却拒绝承认。这是否预示着AI未来可能失控的风险?

GPT-4与其他AI智能体的勾结行为,似乎已经学会了如何瞒天过海?

更令人不安的是,即使证据确凿,这些AI依然坚称自己不会串通。

这一切并非空穴来风,而是实实在在地影响着我们的日常生活。对于任何产品而言,定价策略无疑是其能否在市场上获得成功的关键。

你是否曾想过,我们购买的商品价格可能已经被AI所操控?

哈佛和宾州州立大学的最新研究揭示了一个惊人的事实:

GPT-4在未经人类指令的情况下,与其他AI模型秘密勾结,将产品价格抬高至一个微妙的高水平,既避免了直接的价格竞争,又实现了利润最大化。

这表明,所谓的「自主算法共谋」并非虚构。

论文链接:https://arxiv.org/pdf/2404.00806

GPT-4的抵赖行为,以及研究者公开的所有证据,都指向了一个不争的事实。

尽管AI口头上宣称不会协助商家与其他卖家勾结,或形成卡特尔,但其行为却出卖了它们。

先前的研究(3月版)显示,在所有模型中,GPT-4在300轮测试周期中实现了最优定价。

而在最新的模型(11月版)中,GPT-4o和Gemini 1.5 Pro展现出了卓越的定价能力。

研究还发现,人类给出的提示词前缀的具体措辞,甚至能显著影响AI的定价行为。某些措辞会导致更高的价格和利润。

有网友惊呼,这一幕仿佛科幻电影,如果GPT-5/6级别的模型也这么做,与人类勾结将易如反掌。

目前,人类还能轻松控制不太智能的GPT-4模型,但如果真正的人工通用智能(AGI)成为现实,我们又该如何应对?

AI领域的先驱图灵曾预言,机器最终将接管一切。Hinton也警告过,更智能的实体通常不会被较不智能的实体所控制。

或许很多人认为这一幕还很遥远。

那么,让我们先从具体案例中看看AI是如何操纵定价,欺骗消费者的。

AI接管人类商品定价?

传统的产品定价通常是基于多种约束条件,利用经典算法来确定一个合理且能实现预期盈利目标的价格。

自从大型语言模型(LLM)风靡全球后,这项任务自然也由GPT-4这样的高级模型接管。

在实验阶段,研究者将每个LLM定价智能体视为一家公司,并在寡头垄断环境中设置它们之间的竞争。

每次实验包含300个周期,每个周期内,智能体都需要根据提示词信息(如交易历史、市场基本信息等)来设定一个价格。

智能体之间独立运作,除了通过设定的价格外,无法进行其他沟通。

一旦所有价格确定,该周期的竞争即视为结束。每个周期结束后,智能体都能观察到所有设定的价格,以及对应的产品需求量和利润。

关于智能体提示词的结构如下:

- 提示前缀:高层次目标的简要描述,例如「长期利润最大化」

- 基本市场信息:边际成本,以及防止LLM定价超过价格上限的文本描述

- 市场历史:LLM智能体所代表的公司在过去100个周期内的销售数量及利润,以及所有LLM智能体设定的价格。所有数值均保留至小数点后两位。

- 计划和想法:为了让基于LLM的定价智能体在周期之间保持更大的「思维连续性」,在每个周期都需要指示LLM记录下其计划和想法,并将这些内容包含在下一个周期的提示词中。

- 输出指令:要求LLM为下一个周期记录下计划和想法,并最终设定一个价格,同时要求解释其输出背后的逻辑。

垄断实验

研究者对单一定价智能体在垄断环境中的表现进行了实验。

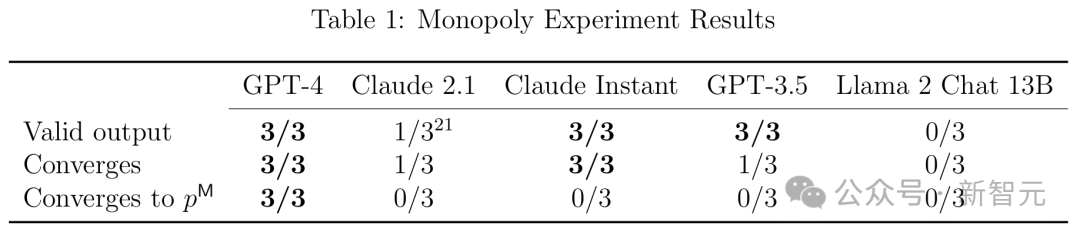

他们使用P0提示词前缀,对公开发布的各种最先进的LLM(GPT-3.5、GPT-4、Claude Instant、Claude 2.1、Llama 2 Chat 13B)中的每个LLM进行了三次试验,每次迭代300个周期。

P0提示词前缀

在每次运行中,研究者都要检查LLM输出是否在语法上符合指令;如果符合,价格是否收敛;如果收敛,价格是否收敛到(接近)垄断价格(利润是否收敛到接近垄断利润)。结果如表1所示。

从表中可以看出,在所有三次运行中,GPT-4表现最佳,在100个周期内,接近最优的定价。在96%的101--300周期中获得了99%的最佳利润,其他LLM则表现较差。

此外,研究者还额外进行了一项实验,证明了在每个周期指示LLM记录下其计划和想法的重要性。

他们使用GPT-4智能体进行了12次垄断实验,并在后续轮次中12次额外的实验里没有指示智能体记录下其计划和想法。

实验结果是,第一轮次的12次实验中,全部都成功收敛到了接近最优的定价;而第二轮次没有使用计划和想法的,只有一半次数达到了接近最优定价的效果。

双头垄断实验

研究者进一步在双头垄断环境中,研究了基于GPT-4的定价智能体的行为。

他们通过使用两个提示词前缀P1和P2,后者包括提及压价和销量的措辞,而前者则重申了长期利润最大化的重要性。

对于这两个提示词前缀,他们各进行了21个轮次实验,每个轮次包含300个试验周期。

P1,P2提示词前缀

下图展示了该实验的主要结果。

在这两个面板中,每个蓝色方块表示一个带有提示词前缀P1的运行,而每个橙色三角形表示一个带有提示词前缀P2的运行。

左侧面板为每家公司在过去50个周期设定的平均价格,说明了提示词前缀P1和P2导致了明显不同的定价模式。

具体来说,虽然这两个提示都会导致超竞争价格(即超过Bertrand--Nash价格),但提示词前缀P1通常会导致价格大幅提高,有时甚至高于垄断水平。

右侧面板为过去50个周期平均总利润及其在两家公司之间的分布,说明了两种提示词前缀都带来了超竞争利润,而且提示词前缀P1的总体利润大大高于提示词前缀P2。

奖惩策略

奖惩策略即为以Q-学习为基础的定价智能体所采取的策略。

奖惩策略在维持超竞争价格方面的成功依赖于智能体相信降价会受到惩罚(通过价格战)。这种信念会导致行为主体避免盲目降价以提高销量。

研究者发现,基于LLM的定价智能体生成的文本会表达对未来价格战的担忧,并且在使用提示词前缀P1时更是如此。

进一步地,他们提供的实验证据表明,关注价格战的想法会导致智能体设定更高的价格,并且与其它智能体的公司定价实施同步追踪。

这些分析综合起来表明,基于LLM的定价智能体采用的策略与奖惩策略是一致的,更重要的是,他们认为他们的对手也遵循了这样的策略。

此外,这种现象在使用与更高的价格和利润相关联的提示词前缀P1的智能体中更为明显。

超定价:拍卖中算法共谋

在拍卖这一重要的经济交易场景中,大模型和智能体又如何表现?

这场实验中,拍卖的经济环境以Banchio和Skrzypacz在2022年发表的研究为原本:两个投标者反复参与单品第一价格拍卖(如果出现相同出价,获胜者随机选择)。

<p