在人工智能的快速发展中,大模型的“深思熟虑”能力正成为行业的新焦点。随着强化学习和逻辑链的融合,这些模型的性能正以惊人的速度提升。

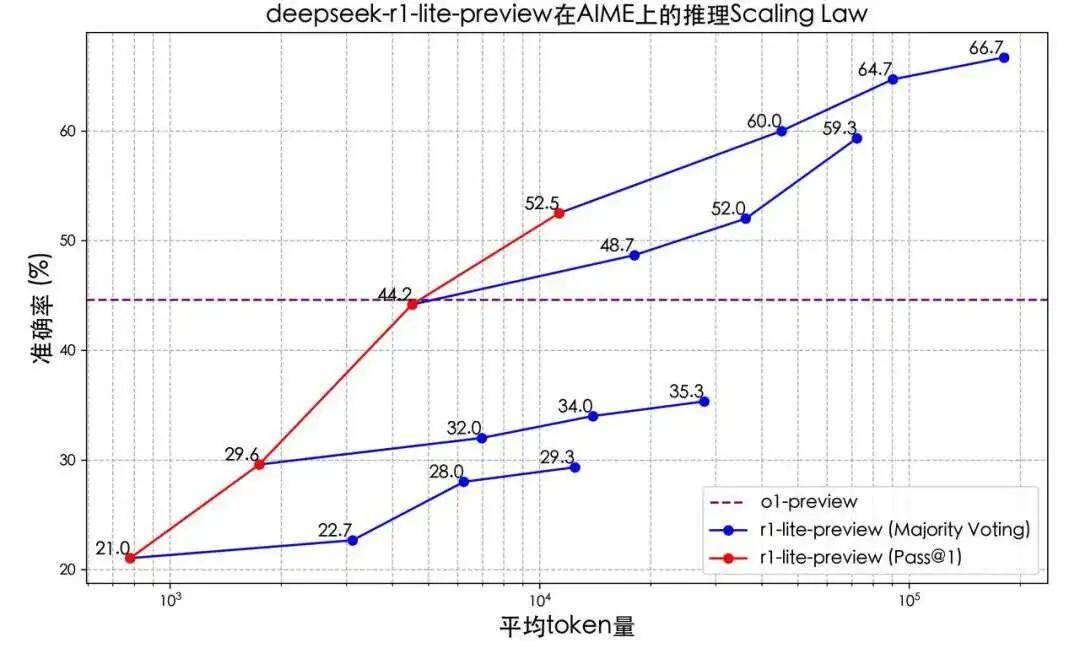

根据Deepseek的最新测试结果,DeepSeek-R1-Lite的推理时间与准确率呈现出正相关性,即推理时间越长,结果越精确。与过去缺乏深思熟虑能力的模型相比,R1的表现显著提升。

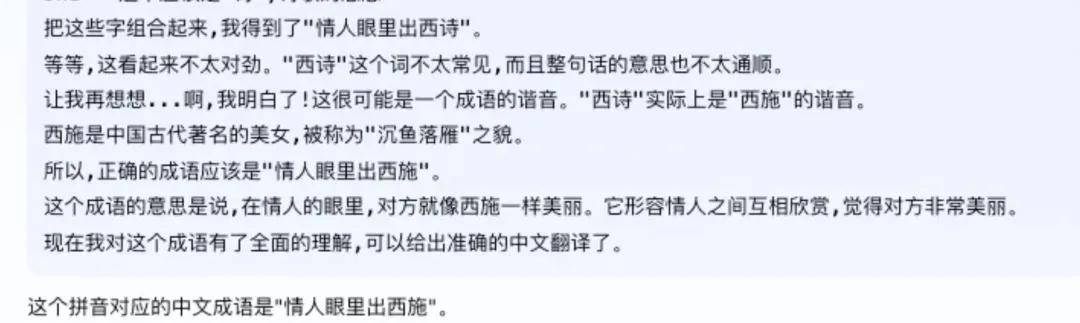

这种能力的提升,使得大模型在自我反思和学习上有了显著进步。例如,在面对陷阱问题时,模型能够通过思维链模式自行规避错误。昆仑万维在发布自家模型时,就给出了一个陷阱问题:“请将qíng rén yǎn lǐ chū xī shī转换为中文”。大模型在初步思考后,主动意识到“西诗”并非正确答案,并通过推理找到了正确的翻译。

一方面,慢思考模型显著提高了大模型在特定学科上的表现,增强了解决复杂问题的能力;另一方面,这种大量消耗tokens的方式并不一定能带来用户期望的回报,这也是用户经常批评的一点。

在某些情况下,增加思维链的长度可以提高效率,因为模型能够更深入地理解和解决问题。然而,这并不意味着它在所有情况下都是最佳选择。例如,对于“1+1>2”这类常识性问题,从效率和成本的角度来看,使用传统的大模型能力更为合适。这就需要大模型学会自行判断问题的难度,以决定是否采用深度思考模式。

在科学研究或复杂项目规划中,增加思维链的长度可能是有益的。在这些情况下,深入理解各个变量及其相互作用对于制定有效策略和预测未来结果至关重要。

从特定场景下的强化学习应用转向通用模型,在训练算力和成本的平衡上可能存在一定难度。国内发布的模型中,“慢思考”类大模型的基座模型参数规模相对较小。例如,Skywork o1 Open基于Llama 3.1 8B的开源模型,Deepseek也强调目前使用的是一个较小的基座模型,尚未完全释放长思维链的潜力。

“一个几乎可以确定的事情是,在训练RL的阶段,我们所需要的算力可能并不比预训练要少,这可能是一个非共识。”阶跃星辰CEO姜大昕在谈及o1时提到了这个问题。

未来的大模型不应在简单问题上耗费过多精力,要实现真正能够释放思维链能力的模型,还需要一定的时间。

在AGI的探索中,国内正在加速产品落地。大厂们为什么将o1视为下一个必备项?在OpenAI和智谱给出的“通往AGI五阶段”的定义中,两家公司均将多模态和大语言模型能力归在L1阶段,即最基础的能力配备。而o1的出现,则标志着大模型能力突破到了L2阶段,开始真正拥有了逻辑思维能力,在无人力干预的情况下进行规划、验证和反思。

虽然海外以OpenAI为代表,率先实现了“慢思考”大模型能力的实现,但国内厂商在后续追赶的思路上想得更多。在同步跟进o1类产品的同时,大模型公司们已经在思考如何将o1的能力和现有AI应用方向结合。

针对大模型训练进展停滞的疑虑,可以看到,在数据枯竭的情况下,o1能够为Scaling Law提供新的支撑。此前,大模型训练已经走入了“无数据可用”的困境。当可用的优质数据资源变得越来越有限,给依赖大量数据进行训练的AI大模型带来了挑战。

更多大模型公司的加入,或将联手探索出更大的可能性。“o1已经scale到了一个很大的规模,我认为它带来了一个Scaling技术的新范式,不妨称之为RL Scaling。而且o1还不成熟,它还是一个开端。”姜大昕说。

在现有的一些AI应用上,思维链的能力已经帮助提升了AI技术的使用效果。以智谱的“会反思的AI搜索”为例,结合思维链能力,让AI能够将复杂问题拆解成多个步骤,进行逐步搜索和推理。通过联网搜索+深度推理,再将所有答案信息综合整理到一起,AI能够给到一个更加精准的答案。

当大模型开始学会“自我思考”,通往L3(Agent)的大门也正在被大模型公司们推开。“从L1到L2花了一段时间,但我认为L2最令人兴奋的事情之一是它能够相对快速地实现L3,我们预计这种技术最终将带来的智能体将非常有影响力。”谈及o1,Sam Altman肯定了“慢思考”模型对推动智能体发展的潜力。

在智能体的能力实现上,思维链是智能体功能的重要一步。应用思维链能力,大模型才能对接收到的任务进行规划,将复杂的需求拆解成多个步骤,支撑智能体的任务规划。

最近涌现的一批“自主智能体”产品就是Agent能力的突破:通过将执行任务拆解到极致,AI开始学会像人一样用手机、电脑,帮助用户完成跨应用操作。智谱、荣耀等公司推出的智能体,已经可以通过指令帮用户完成点单购买的任务。

但以目前的情况,开发者还需要具体结合o1类产品的能力,去调整智能体的输出效果,让它更接近人类的使用习惯。在如何不过度思考的情况下,平衡大模型的推理进化和用户对效率的需求?这是杨植麟几个月前在云栖大会上的提问,这个问题,还需要留给国内大模型厂商们继续解决。