12月16日,月之暗面科技有限公司宣布推出其最新的视觉思考模型——k1。这一创新模型融合了强化学习技术,不仅能够实现端到端的图像理解,还支持思维链技术,并将其应用范围扩展到了数学之外的基础科学领域。

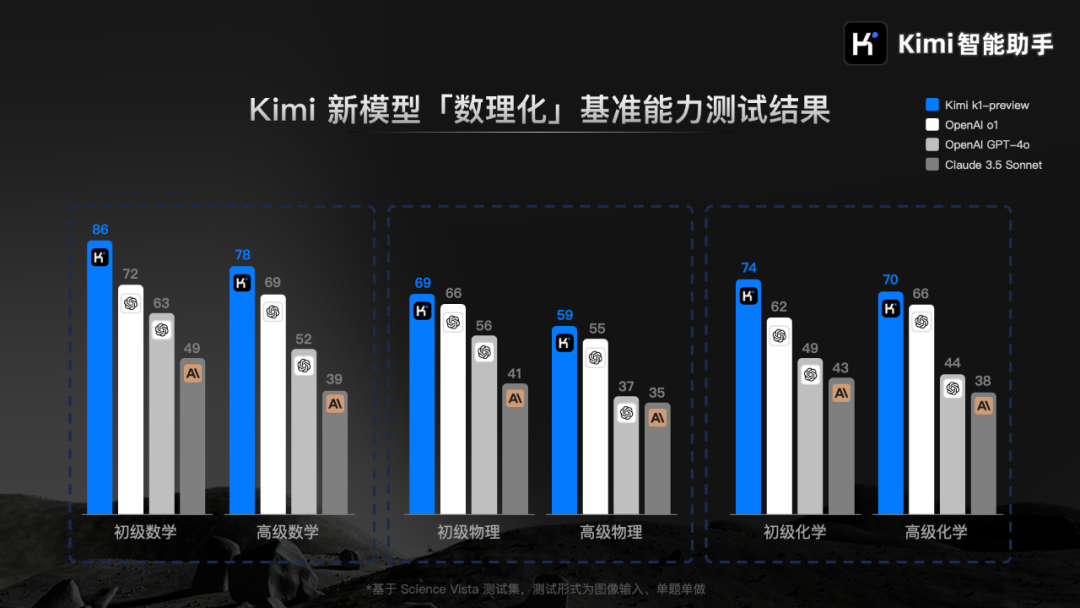

据月之暗面科技透露,在基础科学学科的基准测试中,k1模型的表现超越了业界领先的OpenAI o1、GPT-4o以及Claude 3.5 Sonnet。

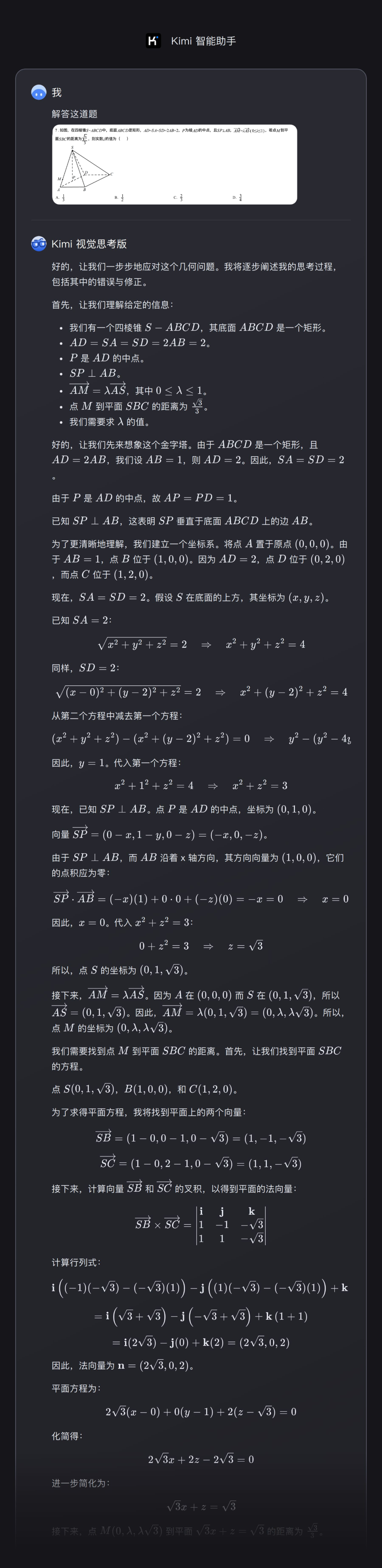

k1视觉思考模型已经集成到最新版本的“Kimi智能助手”中,包括Android和iPhone手机应用以及网页版kimi.com。用户可以在最新版应用或网页版Kimi+页面中找到“Kimi视觉思考版”,通过拍照或上传图片来体验这一功能。

“Kimi视觉思考版”将全面展示推理思维链CoT,让用户不仅能够看到答案,还能深入了解模型得出答案的思考过程。

从训练角度来看,k1视觉思考模型的训练分为两个阶段。首先是预训练阶段,以获得基础模型,然后在此基础上进行强化学习训练。k1的基础模型在字符识别方面进行了重点优化,在OCRBench上取得了903分的领先成绩,在MathVista-testmini、MMMU-val和DocVQA基准测试集上的得分分别为69.1、66.7和96.9。

月之暗面科技强调,k1的强化学习后训练在数据质量和学习效率上进行了进一步的优化,并在强化学习的规模化上取得了新的进展。

面对大模型行业在科学模型能力基准测试方案上的重要挑战,由于市场上缺乏针对基础科学学科的图形测试集,Kimi模型研发团队自主开发了一个标准化测试集Science Vista,覆盖了不同难度的数理化图像题目,并与实际用户需求相匹配。该测试集将向全行业开放,用户可以在许可范围内申请使用。

在内部测试中,月之暗面科技也发现了k1视觉思考模型的一些局限性,例如在分布外泛化、处理更复杂问题、在噪声场景下的准确率以及多轮问答效果等方面,仍有较大的提升空间。在某些场景和泛化能力上,k1模型与OpenAI的o1系列模型相比,仍存在一定的差距。