智能驾驶领域的竞争愈发激烈,技术发展的速度令人目不暇接。从最初的功能体验竞争,到如今的点到点落地应用,再到即将到来的Robotaxi大战,每一步都标志着行业的快速进步。而在技术层面,随着华为宣布加速端到端大模型的研发,软件技术的竞争也进入了白热化阶段。

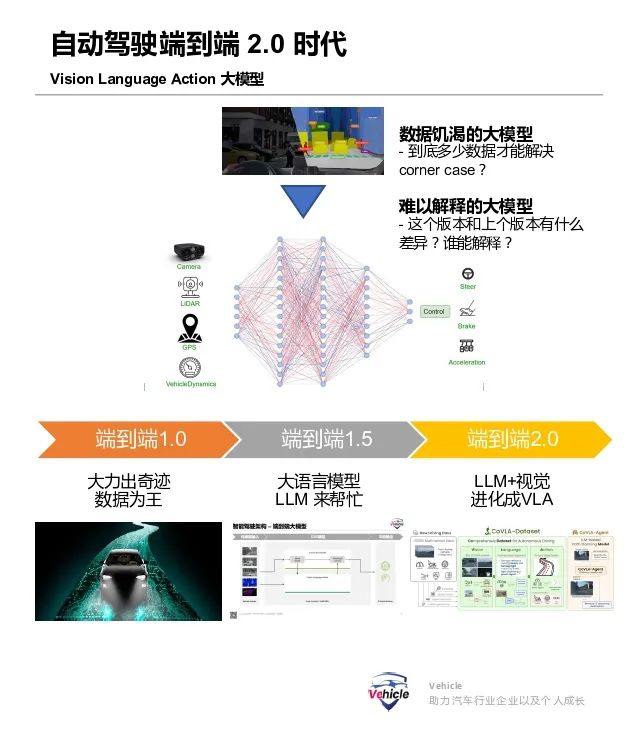

那么,在端到端大模型之后,智能驾驶的下一个风口会是什么?近期的迹象表明,VLA(Vision Language Action)模型可能会成为2025年国内自动驾驶行业的新焦点,各大企业将围绕这一技术展开激烈的竞争。

VLA模型不仅适用于自动驾驶,它还是智能机器人领域的核心,是具身智能的基础。这也解释了为什么人行机器人产业近期如此火热。相较于汽车,机器人在出现问题时的风险更低,因此更容易被市场接受。

本文将梳理VLA相关的研究论文和汽车行业的应用信息,旨在为读者提供科普和前瞻性的资讯。

VLA模型是什么?

VLA模型是在视觉语言模型(VLM)的基础上发展而来,VLM能够处理视觉信息和自然语言,将图像转换为自然语言文本。而VLA模型则进一步利用机器人或汽车的运动轨迹数据,对VLM进行训练,使其能够输出控制机器人或汽车的文本编码动作。

VLA模型的优势在于其端到端的特性,它不仅具备大模型的所有优点,还具有从视觉到执行的推理和解释能力。此外,VLA模型具有通用性,未来所有智能机器设备都可以通过微调这套大模型算法来实现控制,无论是汽车、飞行器还是其他智能机器人。

实验室中的VLA进展如何?

2023年7月,谷歌DeepMind推出了全球首个用于控制机器人的VLA模型RT-2。RT-2基于Google的VLM PaLI-X和PALM-E,通过机器人轨迹数据进行微调,能够将机器人动作表示为文本标记。这种创新的方法使得模型能够从自然语言响应和机器人动作中学习,执行各种任务。

RT-2模型展现出了卓越的泛化能力,在新的物体、背景和环境中表现出色。它能够解释训练数据中未出现过的命令,并根据用户指令进行基本推理。这种泛化能力是机器人控制领域的一大突破。

另一个值得关注的模型是OpenVLA,由斯坦福大学、加州大学伯克利分校、谷歌DeepMind和丰田研究院的研究人员共同发起。OpenVLA模型基于LLM/VLM构建,用于具身机器人和行为学习。它不是使用图像字幕或视觉问答,而是根据摄像头图像和自然语言指令生成动作标记。

落地应用VLA面临的挑战

尽管VLA模型前景广阔,但其大规模参数和对边缘算力的需求使得实际部署变得困难。大型VLA模型的推理速度慢,需要大量预训练数据,这增加了部署的难度。此外,可用于微调的开源VLM模型有限,未来的研究需要开发更高频率控制的技术,并使更多VLM模型可用于训练VLA模型。

Phycical AI需要与人类世界互动,因此实时高频精准的运动是必需的。汽车智能电控底盘的执行响应通常达到100Hz,而机器人的响应要求可能更低,但也需要达到30-50Hz。因此,VLA模型在实时运行和高频响应方面还有很长的路要走。

VLA模型应用于自动驾驶的主要障碍之一是缺乏能够有效结合视觉数据、语言描述和驾驶行为的大规模数据集。现有数据集在规模和全面注释方面存在不足,尤其是对于语言,这通常需要人工操作。这限制了能够处理现实世界驾驶复杂性的稳健VLA模型的开发和评估。

目前有哪些车企在布局VLA?

虽然目前应用VLA的企业还不多,但许多车企和自动驾驶企业正在积极布局。例如,Waymo内部团队正在探索VLA,而国外的创业公司Wayve则采用通用人工智能来解决自动驾驶问题。国内方面,元戎启行计划在英伟达Thor芯片上开发VLA,理想汽车也在推进VLM,并可能朝着VLA进发。小鹏和华为也在积极布局人工智能领域。

VLA会是自动驾驶的最终归宿吗?

虽然难以预测,但自动驾驶采用AI的大方向是明确的。AI的发展速度迅猛,从CNN识别物体到Transformer BEV构建时空关系应用,再到通用人工智能的VLM,每一步都在不断推进。未来,我们可能会看到空间Spatial人工智能的大力发展。AI仍然是一个快速发展的领域,一切皆有可能。