在将文本转化为图像的技术前沿,扩散模型已经证明了它们的强大能力,但在创造具有高度审美价值的图像方面,它们仍有提升空间。最近,一个由字节跳动和中国科技大学联合组成的科研团队,提出了一项创新技术——“Cross-Attention Value Mixing Control”(简称VMix)适配器,这一技术的目标是提高生成图像的美学质量,同时保持对广泛视觉概念的适应性。

VMix适配器的设计理念是,通过一种先进的条件控制策略,来增强现有扩散模型在美学上的表现,并确保生成的图像与输入文本的一致性。

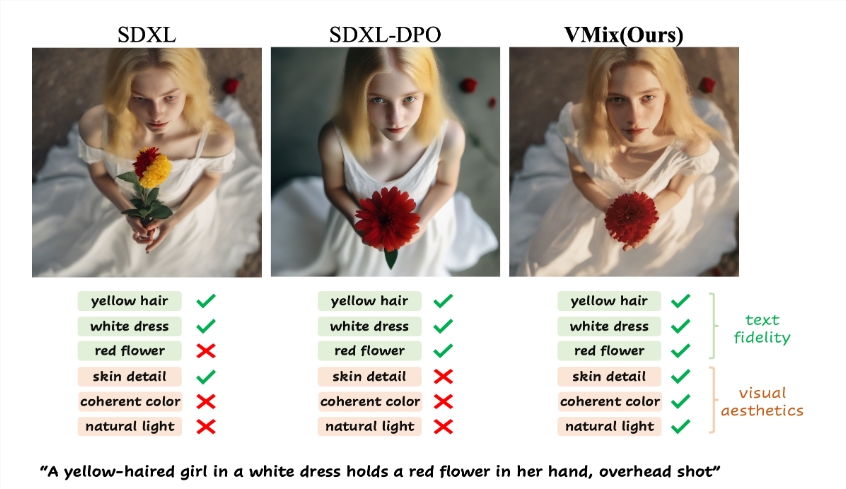

该适配器的工作原理分为两个主要步骤:首先,它利用美学嵌入将输入文本提示分离成内容描述和美学描述;其次,在去噪阶段,通过价值混合的交叉注意力机制,将美学条件整合进网络中,以此提升图像的美学品质,同时保持图像与文本提示的一致性。VMix的这种设计使其能够灵活地应用于各种社区模型,提升视觉性能,而无需重新训练。

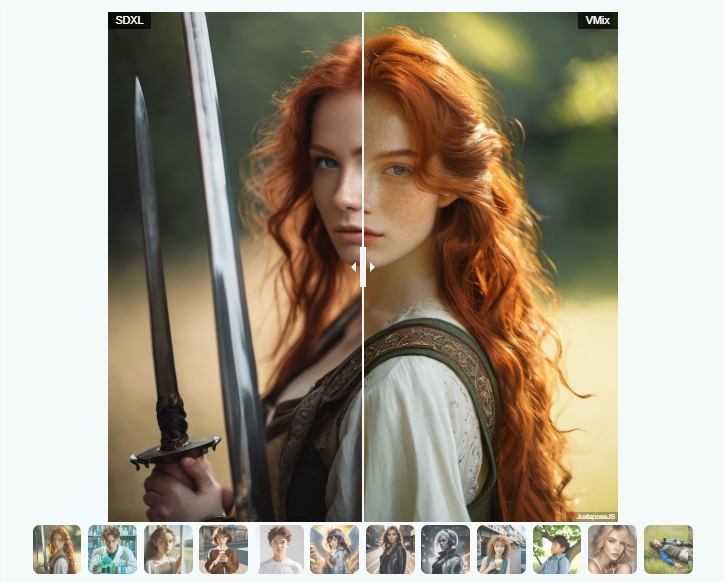

通过广泛的实验,研究人员证实了VMix的有效性,实验结果表明,VMix在美学图像生成方面的表现超越了其他顶尖技术。此外,VMix还能与多种社区模块(例如LoRA、ControlNet和IPAdapter)兼容,这进一步扩展了其应用的可能性。

VMix的细粒度美学控制能力表现在,通过调整美学嵌入,可以在单一维度上提升图像质量,或者通过使用全面的正面美学标签来全面提升图像的视觉表现。例如,在实验中,当输入“一个女孩倚靠在窗边,轻风拂面,夏日肖像,半身中景”这样的文本描述时,VMix适配器能够显著增强生成图像的美感。

VMix适配器为文本到图像生成的美学质量提升开辟了新路径,预示着其在未来应用中的广阔前景。

项目入口:https://vmix-diffusion.github.io/VMix/

🌟 VMix适配器通过美学嵌入将文本提示分解为内容和美学描述,以此增强图像生成的质量。

🖼️ 该适配器与多个社区模型兼容,用户无需重新训练即可提升图像的视觉表现。

✨ 实验结果证明,VMix在美学生成方面的表现优于现有技术,具有广泛的应用潜力。