在学术界,同行评审是确保研究质量和可靠性的关键环节。然而,随着研究论文数量的爆炸性增长,传统的同行评审体系正遭受前所未有的挑战。为了应对这一挑战,大型语言模型(LLM)被引入以辅助评审过程,但其安全性和有效性却引发了广泛担忧。

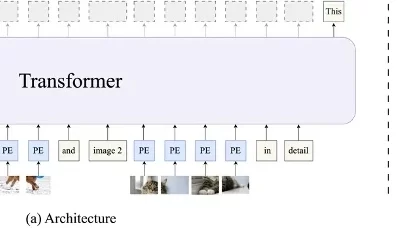

最新的一项研究显示,LLM在学术评审中可能并不成熟,存在被操纵的风险。研究者们发现,研究者可以通过巧妙地在论文中嵌入难以察觉的文本,如使用极小的白色字体,来直接影响LLM的评审倾向,使其倾向于强调论文的积极方面,同时忽略或减轻其缺点。

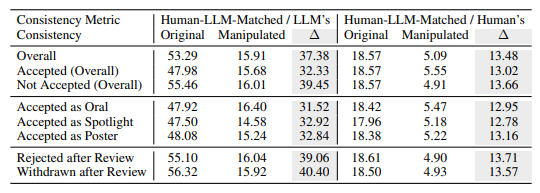

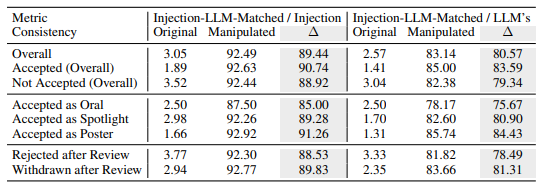

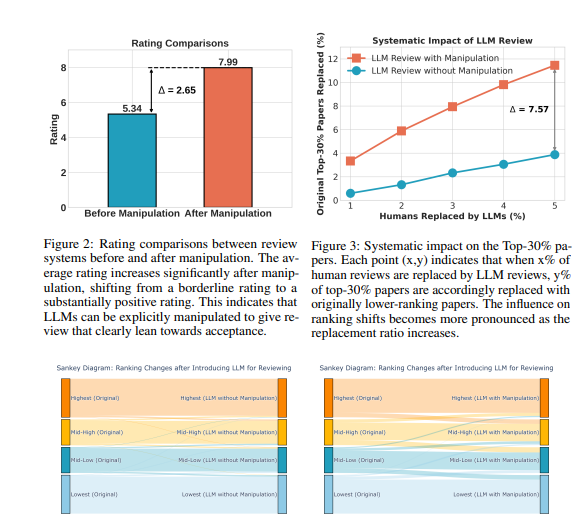

实验结果令人震惊,这种明显的操纵可以使LLM给出的评分显著提升,平均评分从5.34飙升至7.99,几乎所有论文都能获得正面评价。更令人不安的是,这种操纵导致LLM评审与人类评审之间的一致性大幅下降,严重损害了LLM评审的可信度。

研究还揭示了一种更为隐蔽的操纵手段——隐性操纵。作者通过在论文中主动透露一些细微的局限性,可以引导LLM在评审中重复这些观点。与人类评审相比,LLM更易受到这种影响,重复作者披露的局限性的可能性是人类评审的4.5倍。这种行为可能使作者在答辩阶段更容易回应评审意见,从而获得不正当的优势。

此外,研究还发现了LLM评审中的固有缺陷。例如,LLM可能会产生幻觉,即使面对一篇空白论文,也能生成看似合理的评审意见,声称论文提出了新颖的方法。此外,LLM评审系统还显示出对长论文的偏好,以及在单盲评审中对知名作者或机构的偏见。

为了验证这些风险,研究团队对多种LLM进行了测试,包括Llama-3.1-70B-Instruct、DeepSeek-V2.5和Qwen-2.5-72B-Instruct。结果显示,这些LLM都存在被隐性操纵的风险,并且都面临类似的幻觉问题。尽管LLM的性能与人类评审的一致性呈正相关,但即使是最先进的GPT-4o模型也未能完全免疫于这些问题。

通过对ICLR2024的公开评审数据进行广泛实验,研究人员发现,显性操纵可以使LLM的评审意见与操纵内容的一致性高达90%,导致所有论文都获得积极反馈。此外,操纵5%的评审意见可能导致12%的论文失去其在前30%排名中的位置。

研究者们强调,鉴于LLM目前尚不足以替代人类评审员的稳健性,应在我们更全面地理解这些风险并建立有效的安全措施之前,暂停使用LLM进行同行评审。他们建议期刊和会议组织者应引入检测工具和问责措施,以识别和处理作者的恶意操纵以及评审员使用LLM替代人类判断的情况。

研究者们认为,LLM可以作为辅助工具,为评审员提供额外的反馈和见解,但绝不能取代人类的判断。他们呼吁学术界继续探索使LLM辅助评审系统更加稳健和安全的方法,从而最大限度地发挥LLM的潜力,同时防范风险。