在技术浪潮的推动下,Mistral公司近期宣布了一项重大突破,其最新力作——开源编码模型Codestral25.01正式亮相。这款模型堪称是编码界的“升级版战斗机”,在架构上进行了全方位的深度优化,性能实现了质的飞跃,稳坐重量级编码领域的头把交椅。与前代产品相比,Codestral25.01的速度提升之迅猛令人咋舌,整整翻了一倍,为开发者们开启了高效编码的全新大门。

Codestral25.01完美继承了原版Codestral的优良基因,低延迟、高频率操作特性依旧,同时还支持代码校正、测试生成和中间填充等多种实用任务。Mistral公司强调,这款新模型特别契合那些对数据处理能力和模型驻留有着更高要求的企业级应用。在一系列基准测试中,Codestral25.01的表现堪称惊艳,在Python编码测试中大放异彩,在HumanEval测试中更是以86.6%的高分傲视群雄,将前代版本、Codellama70B Instruct以及DeepSeek Coder33B Instruct等一众同类产品远远甩在身后。

对于开发者而言,获取Codestral25.01的途径十分便捷。他们可以通过Mistral IDE插件以及本地部署工具Continue轻松开启与模型的亲密接触。此外,Mistral还贴心地提供了通过Google Vertex AI和Mistral la Plateforme访问API的通道,进一步拓宽了模型的应用边界。目前,该模型已在Azure AI Foundry上开启预览版,未来不久也将强势登陆Amazon Bedrock平台,为全球更多用户送上福音。

自去年问世以来,Mistral的Codestral系列一路高歌猛进,迅速成为开源代码模型领域的领头羊。最初的Codestral模型就凭借220亿参数以及对80多种编程语言的支持,在编码性能上一骑绝尘。随后,基于Mamba架构的Codestral-Mamba模型横空出世,其超长代码序列处理能力满足了更广泛的输入需求,进一步巩固了Mistral在该领域的霸主地位。

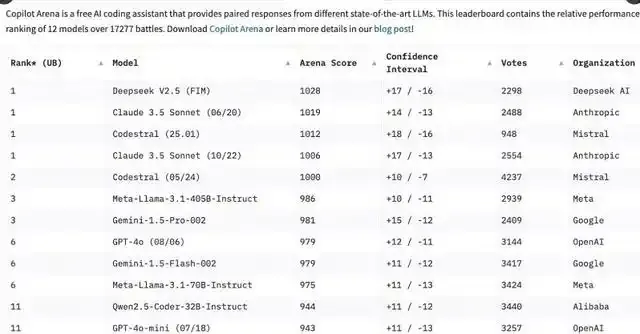

Codestral25.01的横空出世,瞬间在开发者圈层掀起了滔天巨浪。在短短数小时内,它便在C o pilot Arena排行榜上一跃成为佼佼者。这一现象背后所折射出的,是专为编码任务量身定制的模型正逐渐成为开发人员心目中的不二之选。在编码赛道上,相较于功能繁杂的通用模型,专注型编码模型的需求呈现出水涨船高的态势。

尽管像OpenAI的o3和Anthropic的Claude等通用模型也能勉强应对编码任务,但那些经过精心雕琢、专门优化的编码模型在性能上的卓越表现,显然更受开发者青睐。过去一年,编码专用模型如雨后春笋般涌现,例如阿里巴巴的Qwen2.5-Coder和中国DeepSeek Coder,后者更是凭借出色实力率先突破了GPT-4 Turbo的封锁。微软也不甘示弱,推出了基于专家混合模型(MOE)的GRIN-MoE,该模型不仅擅长代码生成,还能轻松攻克数学难题。

在通用模型与专注模型的抉择之争尚未尘埃落定之际,编码模型的迅猛崛起已然彰显出市场对于高效、精准编码工具的强烈渴求。凭借为编码任务量身定制的训练优势,Codestral25.01无疑将在未来的编码江湖中占据举足轻重的地位,为开发者们带来前所未有的优质编码体验,开启编码新时代的辉煌篇章。