在当下这个信息爆炸的时代,AI技术的发展既带来了诸多便利,也引发了一系列问题。

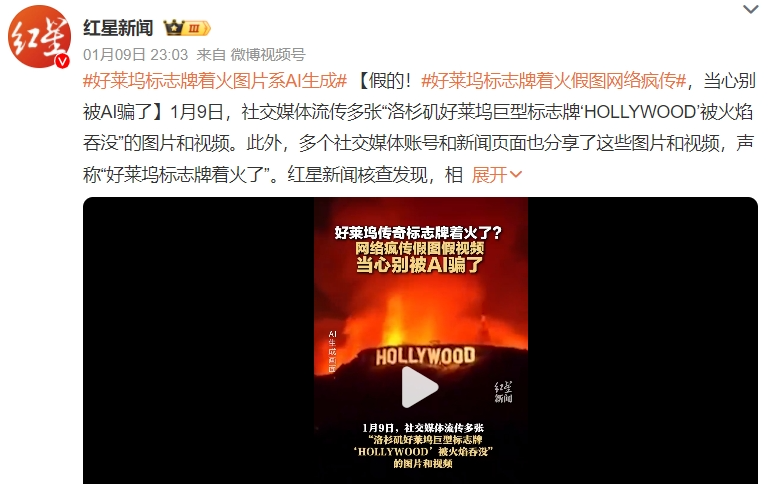

“我之前总以为社交平台上的AI生成图片一眼就能识破,可最近洛杉矶山火的新闻里,那张好莱坞标志牌着火的图,我竟然没看出是AI伪造的!”影迷小李感慨道。这张图在影迷群中广泛传播,大家还戏谑好莱坞在物理层面“陷落”了,结果第二天就被媒体辟谣。

其实,在此之前,西藏定日地震后,也曾有一张AI生成的“小男孩被困”图片在社交媒体上疯传。当时小李还觉得这种人物图AI痕迹明显,手指数目不对,脸部虚化严重,只有不了解AI的中老年人才会信。可没过多久,他就被好莱坞着火的AI图给“骗”了。

这些AI生成的图片,虽然已经被官方辟谣,但仍有不少网友深信不疑,其中不乏年轻人。据查,青海某网民为博眼球,将“小男孩被埋图”与日喀则地震信息关联拼凑,混淆视听,最终被公安机关依法行政拘留。

抖音官方也发布公告称,已严肃处置大量涉地震不实信息,并配发辟谣内容。此前,抖音就曾发布AI内容治理相关公告,明确不鼓励利用AI生成虚拟人物进行低质创作,将严格处罚违规使用AI生成虚拟人物发布虚假内容的行为。

如今,AI生成的内容在社交网络上越来越常见。经常刷短视频的小王表示,现在刷到AI创作内容的概率越来越高,看完一个换脸视频后,平台就会疯狂推送类似内容。但目前社媒平台的审核并不能完全精准识别所有AI创作内容,还需要用户发布时自觉勾选标注。然而,由于AI内容声明标识不显著,有些内容即使明确标识是AI创作,仍会被很多用户当作真实内容。

2024年6月中旬,一家MCN机构的实际控制人因利用AI软件生成虚假新闻并大肆传播,扰乱公共秩序,被警方行政拘留。据报道,该人员共经营5家MCN机构,运营账号842个,自2024年1月以来,通过AI软件生成虚假新闻,最高峰一天能生成数千篇。

2024年下半年,有网友称自己在小红书上通过账号矩阵管理软件同时操控1327个AI美女账号,未被平台识别。由于AI真人账号过多,小红书上还出现了专门打假的博主。

有网友指出,为了避开技术bug,很多AI生成的“真人图”会避免出现手指,采用各种方式遮挡;如果是真人视频,则要注意口型,因为AI生成视频一般口型和台词会不对上,或是不太自然。不过,也有人表示并不在乎照片、视频里的形象是不是真人,只要好看、能提供情绪价值就行。

由于对“数字人”警惕性不足,通过AI换脸的诈骗案也层出不穷。2024年2月,就有诈骗犯运用Deepfake深度伪造技术,制作出公司高层发言视频,诱导职员多次将巨额资金转至指定账户。

除此之外,还有用AI换脸真人制作色情影片、盗刷医保的违法案例。杭州曾有人通过AI换脸伪造女明星涉黄视频,甚至还组建群聊,满足定制换脸色情影片的需求,收取相应费用。杭州萧山检察在该群内查获的淫秽视频数量惊人。

AI模糊了真实与虚假的边界,给人们带来了诸多困扰。北京周泰律师事务所的张律师表示,在公共事件中,故意歪曲事实,用AI等技术手段制作图片、视频,并在社交平台传播造成负面影响的,首先要追究制作者的责任,可能是行政责任,也可能是刑事责任。此外,发布虚假信息的社交平台,也有可能要承担法律责任。

社交平台上,不少网友对“AI入侵”表达了担忧。有小红书网友表示,AI大模型迭代速度飞快,如今画手的正确率明显提升,再过几年,社交网络上可能会乌烟瘴气。AI生成的内容同样充斥着海外社交网络,严重侵害了明星、名人的权益,甚至在经济层面产生了严重影响。

2024年1月,由AI生成的明星泰勒·斯威夫特“不雅照”在多个社交媒体上流传,浏览量过千万,引发公众关注。据网络安全公司发布的数据,2023年网络上可监测到的Deepfake视频数量庞大,其中绝大部分是色情内容,且主角几乎都是女性。

2023年5月,一张五角大楼发生爆炸的照片曾在Twitter上被大范围转发,包括很多投资相关的网站和社媒账户,照片发布时正赶上美国股市开盘,一度引发美股恐慌性短暂下跌。

当AI生成的内容频繁与真实新闻掺杂在一起,不仅普通民众很难辨别真伪,一些专业机构也难以应对。互联网观察基金会的分析师曾表示,AI生成的非法内容正在急剧增加,像他们这样的组织或者警察,可能会被大量新图片的鉴别工作压垮。

张律师认为,AI技术的推广,可能使网民对网络信息从全信到全不信。除了入侵互联网内容生态,AI生成的内容也给大模型训练带来了风险。中国信通院发布的蓝皮书提到,近年来,人工智能内生风险加大,模型缺陷、幻觉等问题凸显;人工智能应用风险不断蔓延,人机伦理、劳动替代、能源短缺等问题突出。

OpenAl前首席技术官曾指出,底层大型语言模型的最大挑战是会编造错误或不存在的事实。牛津大学的伊利亚舒梅洛夫博士及其团队在《Nature》上发表的论文提到,当生成模型开始接受AI内容训练时,最终生成内容的质量会明显下降,反馈循环可能导致模型输出偏离现实、甚至有明显偏见的内容,研究人员将这种现象称为“模型崩溃”。

此前,国内领先的AI实验室发布的新的AI模型在测试中出现了声称自己是其他AI产品的情况。参与过文本生成模型研究的子璐表示,大模型训练的数据在投喂前都会进行筛选和清洗,图片、视频的生成在技术上更复杂,训练数据的样本也更容易去做清洗,相比之下,文本生成的训练数据会更杂一些,也更容易被污染。

如果AIGC的增加是必然趋势,那普通用户该如何对这类内容有效甄别?某互联网大厂AI安全研究员表示,普通用户可以从图像的视觉纹理特征来区分AI创作,一般生成的图片颜色更鲜艳、纹理更平滑,生成的视频运镜缓慢,画质模糊,经常出现类似文字的乱码内容。除此之外,文本和图像还可以借助第三方工具来辨别。

不过,大部分用户都是不熟悉AI技术的普通人,不具备鉴别意识和能力,识别AIGC、鉴别真假不应成为用户的负担和责任。创作者应自觉声明内容属性,平台拥有更完善的技术资源和团队,更应承担起识别和审查AI内容的主要责任。

张律师认为,想要防范AI创作内容带来的风险,除了用户增强核实意识与能力,平台也应当加强规范,尤其要关注短时间内被频繁关注、转发的内容,如果发现是AI创作且为虚假信息,应当予以删除,如果不能确认真假,也应当提示和标注该内容为AI创作。

据了解,目前已有多家社媒平台针对AIGC内容做出了相应的监管规范。小红书启动了AIGC治理体系建设,对疑似AI生成的内容进行显著标识;抖音发布了相关规范和公告,并持续打击多种AIGC造假内容;快手开设了“辟谣”榜位,通过官方账号转发辟谣作品,利用算法优化,增加辟谣内容曝光量,同时将辟谣信息精准推送给曾浏览过相关谣言的用户。

柏文喜认为,除了加强监管和治理,平台还可以完善用户举报机制,建立版权保护机制,要求用户在使用AI生成内容时遵守版权法规,明确标注内容的来源和版权归属,防止侵权行为的发生;同时也要注重用户教育,通过发布指南、教程、案例分析等形式,提高用户对AI内容的识别能力和辨别真伪的意识和能力。

张律师还表示,AI生成工具要有提供显著标识的功能,像人脸替换、人声合成等显著改变个人身份特征的编辑服务,应当强制标识为AI创作,如果这类服务未强制标识,创作者也不声明为AI创作,构成共同侵权的,需要承担一部分侵权责任。

从从业者角度来看,防止AI虚假内容泛滥,还需要对使用者进行限制。企业会避免生成含有色情、暴力等价值观扭曲的内容,但却管不了内容的用途。如果有人要求AI生成一张性感女孩的换脸照片,照片本身没有危害,但用户拿这张照片造谣中伤女孩,这是使用者的问题,也是AI企业很难管辖的领域。

如今,国内外都愈加重视对AIGC的监管与合规性问题,目前至少有60多个国家制定和实施了人工智能治理政策