近期,开源界的一颗璀璨明星——HuggingFace平台的联合创始人Clem在社交媒体上宣布,阿里巴巴集团最新发布的Qwen2-72B指令微调版本在激烈的竞争中再次夺魁,稳居全球开源模型排行榜的榜首位置。

在全球知名AI企业OpenAI对中国开发者关上大门的背景下,这一成就无疑为中国AI领域注入了一剂强心针。

首先,随着中国开发者纷纷回归本土,国内的大型模型供应商开始积极推出各种方案来吸引这些回归的开发者。正如雷科技在《OpenAI对中国开发者说不,“模型大战”下半场已打响》一文中所报道的,众多供应商纷纷推出服务,以期在这场“抢人大战”中占据先机。

然而,许多人仍旧持有一种成见,认为国内的大模型供应商只是权宜之计,是替代品,而非真正的竞争者。有人甚至戏称GPT是高速列车,而国产大模型不过是拖拉机。

但这种看法忽略了一个事实:在多个领域,国产大模型已经展现出了与世界顶尖水平相媲美的竞争力,尤其是在开源模型领域。

何为具有全球竞争力的大模型?这里有两种情况:一种是那些在发布会上总是宣称自己超越了GPT4的公司,他们的参数总是领先,但在实际评测中却鲜有胜绩,这无疑是一种自我吹嘘。

另一种则是在权威排行榜上获得认可的模型。HuggingFace作为全球公认的开源模型排行榜,为阿里云的Qwen2正名,提供了权威认证。

那么,为何HuggingFace能够成为全球最权威的开源模型排行榜呢?这与其平台背景密切相关。HuggingFace并非模型供应商,而是全球最受欢迎的大模型和数据集开源社区,为AI开发者提供了一个获取开源代码和数据集进行训练的平台。可以说,在AI开发领域,HuggingFace是一个不可或缺的存在,因此它也被誉为机器学习领域的GitHub。

HuggingFace更像是一个大型模型的应用、分发和发布平台。包括微软、Facebook、特斯拉等在内的科技巨头,都会选择在HuggingFace上发布他们的大模型。例如,在微软Build大会上,纳德拉宣布微软在HuggingFace上发布了Phi-3系列模型,其中Phi-3-medium-128k-instruct是目前消费级硬件上表现最佳的模型。

凭借海量的开源大模型和数据集,以及众多AI开发者的使用数据,HuggingFace能够制作出行业内最具权威性的开源模型排行榜。这与媒体或第三方评测机构制作的榜单有着本质的区别。许多第三方评测榜单可能在权威性、客观性和专业性上都存在不足。

在了解了HuggingFace榜单的权威性之后,我们再来看看阿里云的Qwen2究竟有多强大。

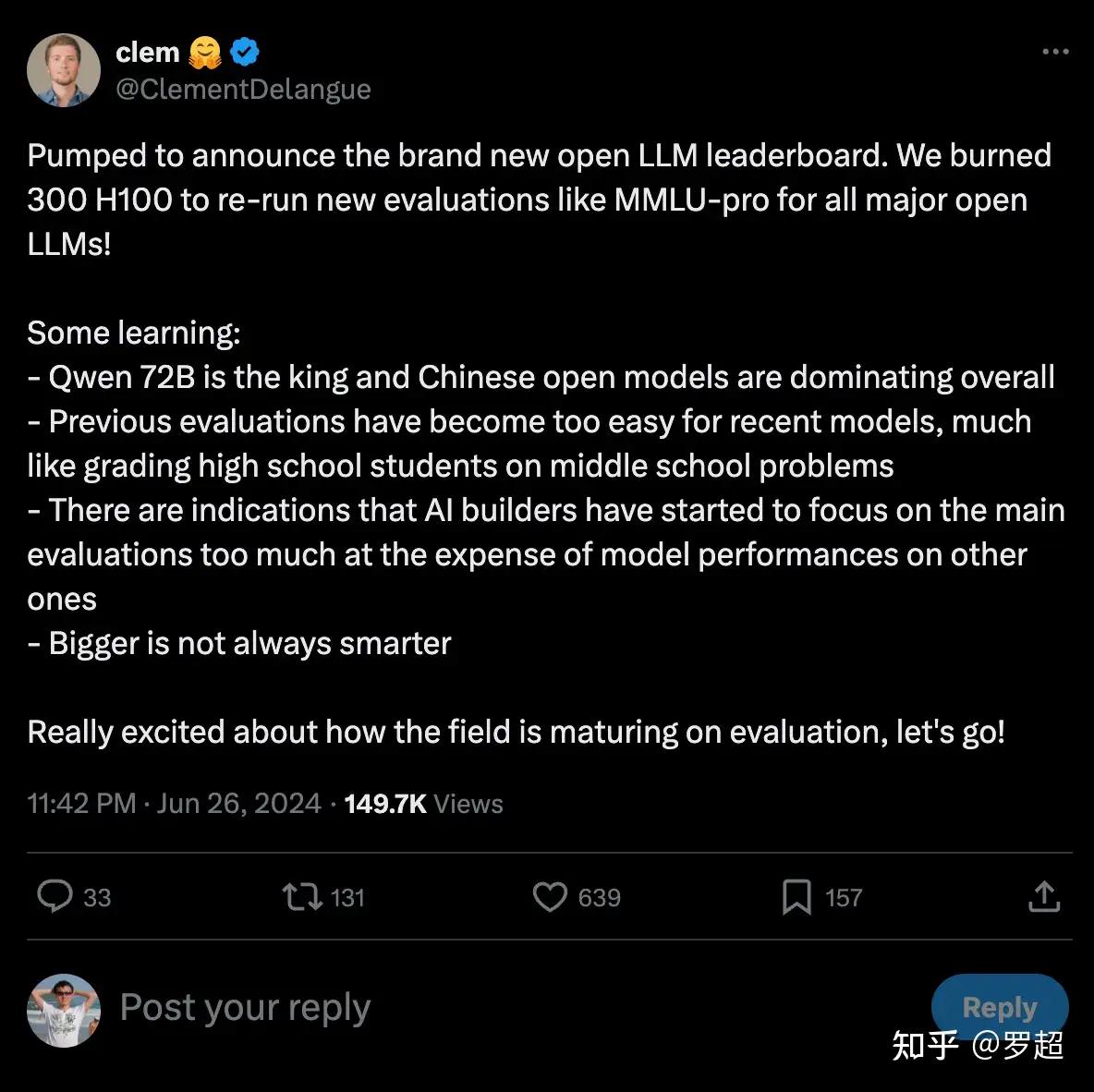

此外,为什么HuggingFace在6月两次更新榜单?V2榜单的意义何在?实际上,6月7日HuggingFace已经发布了一次榜单,当时Qwen2也是位居榜首。那么,为何要更新到V2版本呢?HuggingFace表示,新的榜单采用了“更难、更好、更快、更强”的测试集,从而对模型的评估更具说服力。

将大模型基于测试数据集进行评测的过程,可以形象地比喻为“做题考分”,类似于我们的考试。但问题在于,这些题目是开放的,这就导致了一些大模型会通过“刷题”来提高评测分数,有些公司甚至雇佣数据标注员来提供答案,或者利用GPT-4来生成答案,以此来训练自家的大模型。这导致了许多新推出的大模型一上来就能拿到满分,表面上看似超越了GPT-4。

HuggingFace在技术博客中指出,过去一年中,Open LLM Leaderboard的基准指标被过度使用,出现了一些问题:题目对模型来说变得太简单;一些新模型出现了数据污染的迹象;部分评测基准存在错误。因此,HuggingFace提出了更具挑战性的V2榜单,基于未受污染、高质量的数据集和可靠的度量标准。

现在,随着测试数据集的大幅更新,最新的考试题目,阿里云的Qwen2依然稳居第一。正是因为这一点,HuggingFace的联合创始人兼首席执行官Clem才会公开发文称赞“Qwen2-72B是真正的王者,中国在全球开源大模型领域已经占据了领导地位。”如果没有经过严格和充分的测试,他不可能公开给予这样的评价。

我们期待HuggingFace的榜单能够更快地升级,测试数据集能够更快地更新,阿里云的Qwen2以及国产大模型能够在未来的排名中继续保持优势。

在OpenAI不支持中国开发者的情况下,开源大模型厂商必须迅速提升自身实力,勇敢地填补市场空缺。现在,正是国产大模型、国产开源大模型生态加速进步、证明自己实力的绝佳时机。