今年春节,科技圈最火的非DeepSeek莫属了,其热度甚至让不少平时对科技不太关心的长辈都开始打听。上一次AI大模型如此火爆,还是OpenAI的ChatGPT。

然而,爆火的背后也伴随着问题。DeepSeek官网在春节期间频繁遭受高强度网络攻击,导致网站经常无法正常使用。即便关闭联网搜索,其深度推理能力强大的DeepSeek-R1在线模型也难以幸免于难。好在有华为等科技公司的支持,第三方平台接入DeepSeek的API,才让稳定在线使用成为可能。

但这些终究是线上访问,对于喜欢折腾的我来说,总觉得不够过瘾。春节放假在家,我突发奇想,要是能把DeepSeek大模型部署到本地电脑上,那该多有意思!

说干就干,这个春节我可没闲着。

打造“AI电脑”:挑战与收获

其实,无论是哪个大模型,本地部署的步骤大同小异,关键在于找到合适的资源和命令。不过,本地大模型虽然是训练好的“成品”,但想要获得良好的体验,也需要一定的硬件基础。

首先,要在Ollama官网下载桌面端应用,它就像是一个“容器”,用来承载本地大模型。除了DeepSeek,Ollama的模型库里还有许多开源大模型可供选择。

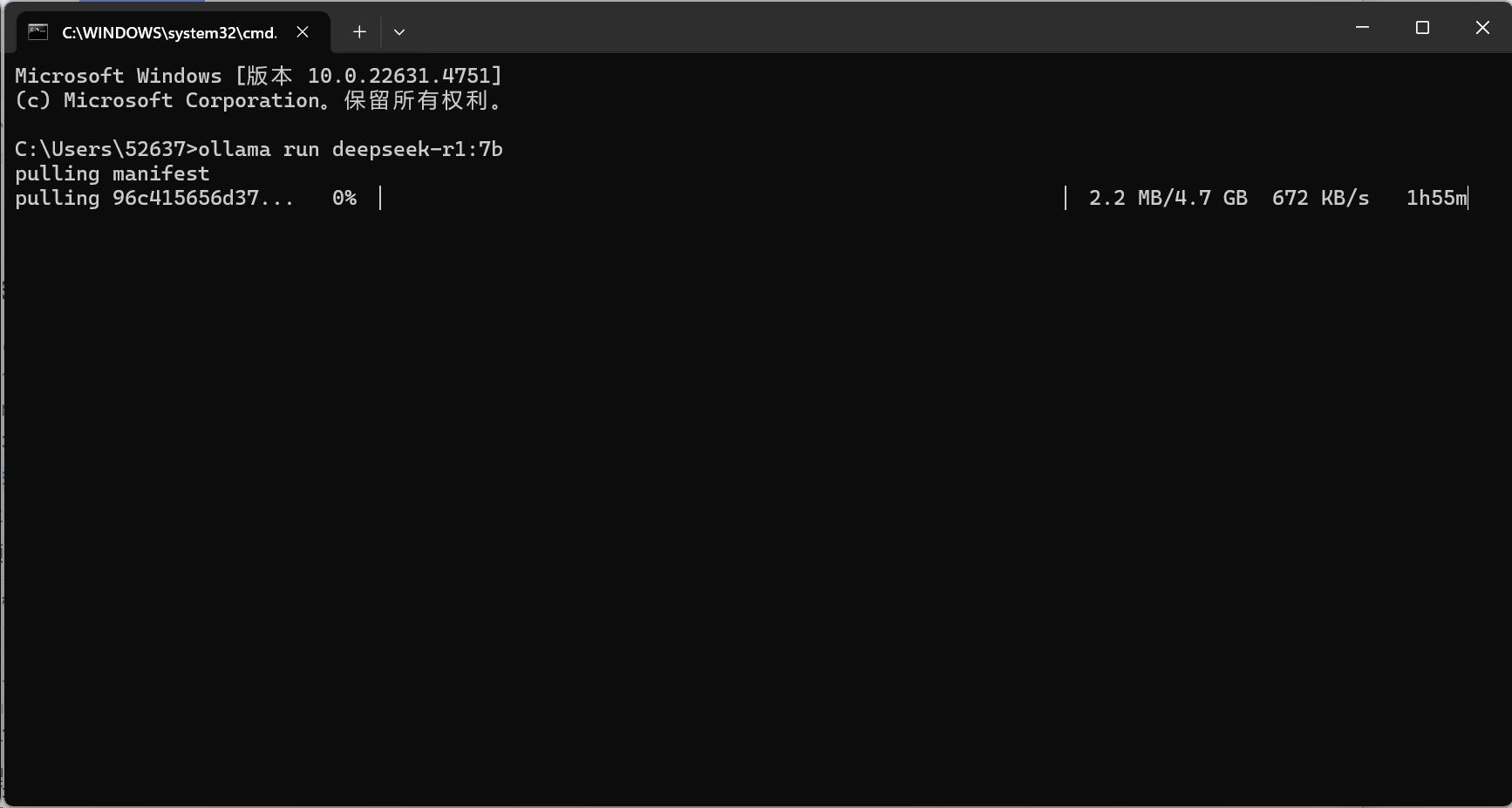

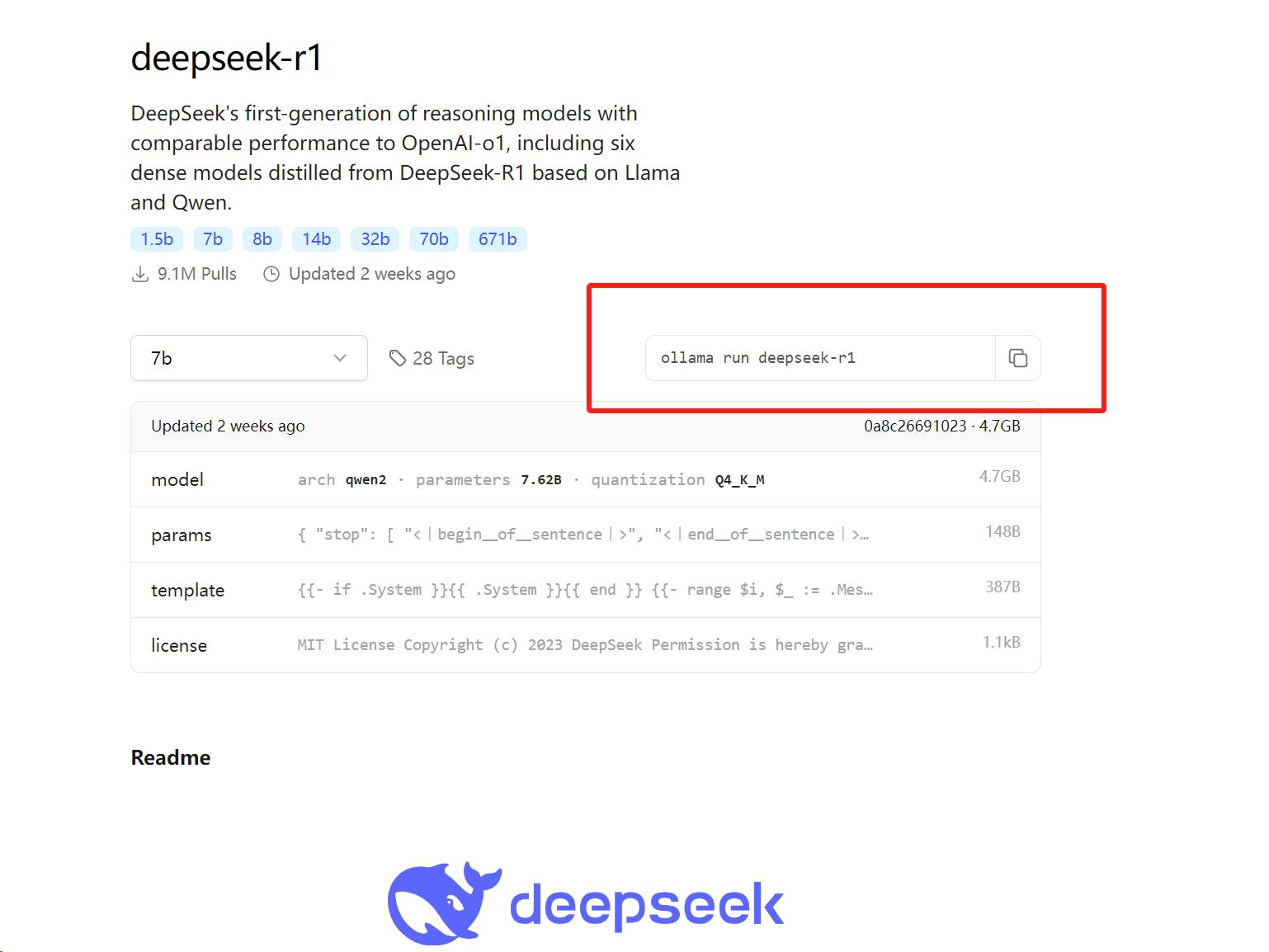

Ollama桌面端没有操作界面,要下载大模型,需要在Ollama模型库找到对应模型的代码,复制到PowerShell(Win+R,输入PowerShell回车打开)执行,这样就能拉取和安装模型数据。

我选择了DeepSeek-R1模型的7b版本,也就是70亿参数的版本,占用4.7GB。一般来说,参数越多,大模型的语言理解、文本生成、逻辑推理和学习能力就越强,知识储备和泛化能力也更好。但本地大模型依赖电脑的计算能力,大家要根据自己的需求选择,别盲目“硬上”。

一般来说,运行15亿参数的模型,最低需要4GB显存的GPU和16GB内存。如果达不到要求,就会强制使用CPU计算,硬件负担会更大,推理时间也会更长。满血版的DeepSeek-R1参数量高达6710亿,体积404GB,需要更高级的硬件才能负担。对于个人部署来说,15亿-80亿参数是比较合适的选择。

模型数据拉取完毕后,系统会自动安装。安装完成后,就可以在PowerShell窗口直接调用DeepSeek-R1模型,输入问题,本地大模型就会推理并生成答案。

至此,DeepSeek-R1本地大模型就部署完成了。理论上,可以用同样的方法部署其他大模型。

不过,每次开机都要打开PowerShell才能激活大模型,这对于普通用户来说不太方便。所以,我给DeepSeek-R1安装了一个更直观的交互界面。我选择了在Docker应用(蓝色海豚图标)上添加Open-WebUI组件,这样DeepSeek-R1就可以通过浏览器交互,还能联系上下文。

具体来说,先下载Docker桌面端,按照默认引导完成安装(可以跳过注册等步骤),然后在PowerShell界面复制并执行以下指令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

如果使用NVIDIA GPU,可以使用这条指令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

拉取大模型文件和Open WebUI组件需要一段时间,如果网络状况不佳(或者没有科学上网),下载器可能会不断重试或切换线路,导致下载进度丢失。

安装完成后,Docker应用会出现Open-WebUI组件,启动它,点击“3000:8080”链接,系统就会跳转到网页。

恭喜你,你现在拥有一台带有AI本地大模型的“AI电脑”了!

我体验了整个过程,发现步骤不算复杂,系统会自动拉取和安装数据,主要时间花在搜索命令行、安装资源,以及拉取和安装组件上。Ollama和Docker都可以通过百度搜索找到,有兴趣的朋友不妨试试。

当然,本地部署大模型的方法不止这一种。华为刚推出的ModelEngine,具备一站式训练优化和一键部署能力,应该是面向企业端的开发工具。

离线优势与能力差距

国内AI大模型应用众多,网页端服务也很完善,为什么还要本地部署呢?

关键在于两点:第一,本地大模型的数据和对话记录完全离线,存储在本地,响应更快,避免敏感内容泄露。在飞机等无网络环境下也能正常使用;第二,本地部署支持各种开源模型,可以灵活扩展和切换,根据自身需求优化和集成工具,操作空间更大。

我部署的时间不长,很多功能还没摸清楚,简单说说我的体验。

我用的是机械革命无界14X,轻薄本,24GB内存,没有独立显卡,不在推荐配置范围内,算是个“反面教材”。也就是说,DeepSeek-R1 7b模型在这台电脑上,需要更长的推理时间和更多资源占用才能生成内容。

像“饭后胀气”这类问题,大模型要思考30秒-1分钟才能生成答案。期间电脑负载达到高峰,CPU和内存几乎占满。可见没有独立显卡的电脑运行本地大模型确实很吃力,但给出的答案确实有参考价值。

相比于答案,我更喜欢DeepSeek拟人化的思考过程。很少有AI助手把思考过程做得这么人性化,不管答案是否准确,它的推理过程都能激起用户的兴趣。

如果把同样的问题放在网页端的DeepSeek大模型,并启用R1深度思考,直接返回“服务器繁忙”。看来密集的访问给DeepSeek造成了不少困扰。这时候,本地部署虽然能力不一定很强,但至少能访问得到。

换一道经典的概率题,网页端DeepSeek-R1持续繁忙,本地DeepSeek可能也有些手足无措,列举多种情况后又自行否定,最后还混入了之前提问的“饭后胀气”的内容,场面十分滑稽。

本地DeepSeek连续输出了十几分钟也没给出答案,考虑到时间有限,我停止了生成。看来数学题对于70亿参数的DeepSeek-R1 7b还是太难了,在线大模型都不一定能给出准确答案,本地就更不用说了。同时,高参数的本地大模型推理时,电脑的负载压力也会拉满。

从开源的角度来看,本地大模型的扩张性和可玩性比线上大模型更好。但本地部署操作起来并不容易,想要挖掘更多玩法,需要动手能力强的用户。

本地部署DeepSeek:只是尝鲜?

那么,本地大模型值得人手一个吗?我的答案是否定的。

就目前的生成能力而言,本地大模型很难与线上大模型媲美。参数规模和计算能力摆在那里,肯定比不上正规大模型公司背后的算力集群。本地大模型更适合动手能力强的用户折腾,深度发掘确实能带来一些功能上的便利,毕竟它在系统底层运行,能更好地与硬件结合。

但作为普通用户,部署本身就不容易,大模型的周边配套也没那么成熟,Ollama官网全是英文,Docker应用也不支持中文。我部署一个本地DeepSeek大模型,只是为了尝鲜,平均生成用时20秒起步,除了可以离线使用,体验不如在线大模型。

像读取文件分析、联网收集数据分析等能力,还需要用户自己来折腾。我目前部署的DeepSeek还只是个开始。而且,如果有一天不用了,还需要学习步骤清除数据,否则它会一直占用系统盘空间。

在我看来,DeepSeek走开源道路,是为了打响市场影响力,抢占市场地位,吸引行业围绕它建立完善的服务体系。国内众多大模型平台率先接入DeepSeek的API,就是开源带来的直接结果。

可以预见,随着DeepSeek的应用和渗透,个人本地部署的需求会变得更简单,调用PowerShell、敲代码这些事情甚至都不需要用户自己做。

DeepSeek会发展成什么样,我还无法预测。被行业关注是好事,不稳定的服务只是短痛。提高市场占比,走到用户身边,渗透到各种设备,到那时,本地部署或许就没必要了。