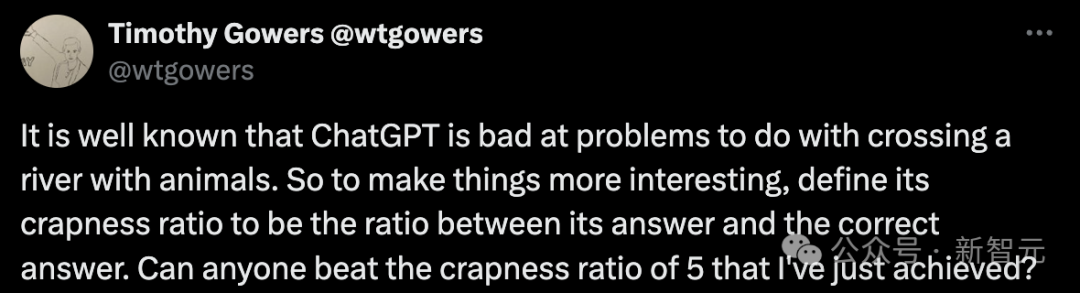

在探索大型语言模型(LLM)的逻辑推理能力的道路上,我们似乎遭遇了一段曲折。最近,数学界的巨擘、菲尔兹奖获得者Timothy Gowers对GPT-4o进行了一项别开生面的测试,结果令人啼笑皆非——即便是最简单的“狼-山羊-卷心菜”过河问题,这些模型也显得无能为力。

Gowers教授在剑桥大学的研究室里,用一个看似简单的问题对GPT-4o发起了挑战:一个农夫带着两只鸡要过河,而船只能载一人两鸡,最少需要几次才能让农夫和鸡都到达对岸?这个问题对于大多数人来说,几乎是不假思索就能回答的。然而,GPT-4o给出的答案却是五步,而非显而易见的一次。

这个结果引发了广泛的讨论。一些网友认为,LLM的失败并非因为它们缺乏智能,而是因为缺乏“提示”的艺术。他们指出,如果能够提供更精确的提示,LLM或许就能给出更合理的答案。

然而,Gowers教授并没有止步于此。他进一步提出了一个更为复杂的问题:如果农夫要带100只,甚至1000只鸡过河,情况又会怎样?在这个问题中,农夫的船有漏洞,开始时可以带十只鸡,但到最后只能容纳两只。GPT-4o给出的解决方案,其“废话比率”高达125倍。

与此同时,另一位网友用Claude 3.5进行了类似的测试,结果也不容乐观。在“农夫和羊”的过河问题上,Claude 3.5同样给出了错误的答案。这引发了LeCun的嘲讽:这些模型真的能进行推理吗?

事实上,LLM在数学推理任务上的表现一直不尽如人意。Gowers教授去年与人合著的一篇论文就指出了这一点。他们发现,LLM在解决数学问题时,似乎更倾向于依赖记忆,而非真正的理解。这与人类在解决数学问题时的方式大相径庭。

尽管如此,LLM在一些基准测试中的表现却相当出色。例如,在HellaSwag测试集中,GPT-4在2023年3月的得分甚至超过了人类水平。这不禁让人疑惑:为什么在基准测试上表现优异的模型,一遇到现实世界的数学问题就会失灵呢?

一些研究者认为,这可能是因为LLM的训练数据过于单一,或者是测试集的设计不够全面。还有人认为,LLM的架构本身可能存在问题,需要进一步的改进。

无论如何,LLM在逻辑推理和数学问题解决上的能力,显然还有很大的提升空间。而我们对这些模型的理解,也还有待进一步加深。正如Gowers教授所展示的那样,通过创造性的测试和评估,我们可以更好地理解LLM的局限性,并探索提升它们性能的新方法。