在人工智能领域,多模态技术正逐渐成为推动行业发展的新引擎。最近,微软研究团队携手多所高校,共同推出了一款名为“Magma”的多模态AI模型,这一创新成果标志着AI技术在融合图像、文本和视频等多种数据类型方面迈出了重要一步。Magma模型的发布,不仅为机器人技术、虚拟助手和用户界面自动化等前沿领域带来了新的可能性,也为未来的智能应用描绘了一幅令人期待的蓝图。

在过去,AI系统大多专注于单一领域,如视觉-语言理解或机器人操作,但很难将这些能力整合到一个统一的模型中。例如,Pix2Act和WebGUM模型在用户界面导航方面表现出色,而OpenVLA和RT-2则更适合机器人控制。然而,这些模型通常需要独立训练,难以跨越数字和物理环境的限制,导致其在不同应用场景下的泛化能力较弱。Magma模型的出现,正是为了打破这些局限。它通过创新的训练方法,将多模态理解、动作定位和规划能力整合在一起,使AI代理能够在各种复杂环境中流畅运行。

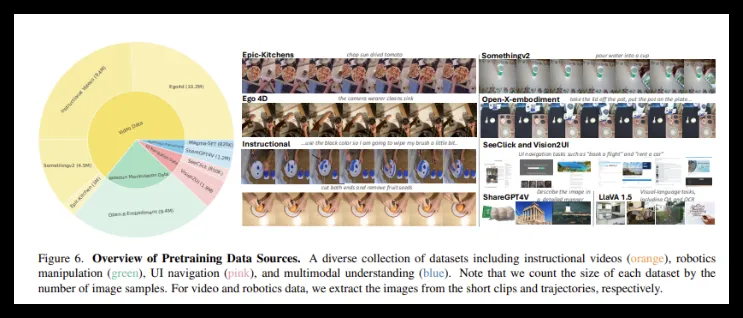

Magma模型的训练数据集规模庞大,包含3900万样本,涵盖了图像、视频和机器人动作轨迹等多种数据类型。此外,该模型还引入了两项关键技术:“可标记集”(SoM)和“轨迹标记”(ToM)。SoM技术使模型能够识别并标记用户界面环境中可操作的视觉对象,而ToM技术则能够追踪物体随时间的移动轨迹,从而为未来的行动规划提供更精准的依据。这些创新技术的应用,极大地增强了Magma模型在复杂环境中的适应性和决策能力。

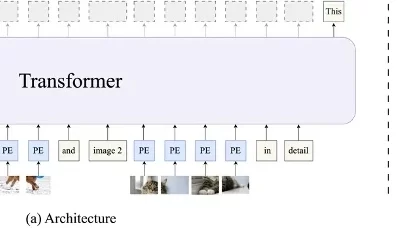

从技术架构上看,Magma模型采用了先进的深度学习架构和大模型预训练技术。它使用ConvNeXt-XXL视觉主干网络来处理图像和视频数据,同时借助LLaMA-3-8B语言模型来处理文本输入。这种架构设计使得Magma能够高效地整合视觉、语言与动作执行能力。经过大规模训练后,Magma在多项任务中均取得了优异的成绩,充分展现了其强大的多模态理解和空间推理能力。

总结来看,Magma模型凭借其超过3900万样本的训练基础,展现出了卓越的多模态学习能力。它成功地将视觉、语言和行动能力整合在一起,克服了现有AI模型的诸多局限。在多项基准测试中,Magma的表现都十分出色,显示出强大的泛化能力和决策执行能力。随着这一模型的不断优化和应用拓展,我们有理由相信,它将在未来的智能技术领域发挥更大的作用,为人类的生活和工作带来更多便利。